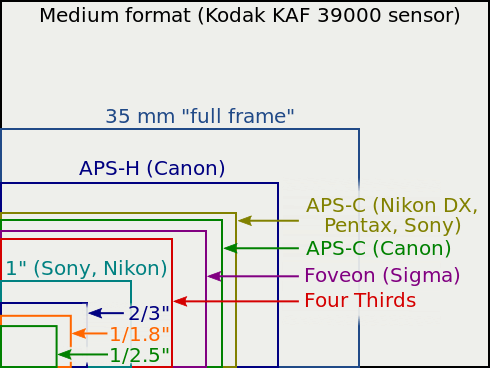

Er zijn tegenwoordig veel soorten cameras in omloop: compact-, bridge- en systeemcamera's (mirrorless en dslr). Vaak hebben deze camera's niet hetzelfde formaat sensor. Voor velen is dit niet zo'n probleem. Maar zodra je ze met elkaar wilt vergelijken, krijg je met deze verschillen te maken. Als je wilt weten hoe een lens zich gedraagt met verschillende sensorformaten, of als je op zoek bent naar een lens die je een gelijkwaardig beeld geeft, krijg je met deze verschillen te maken. Om eenvoudiger te kunnen vergelijken, maken we vaak gebruik van equivalentie. In de praktijk worden lenseigenschappen omgerekend naar 1 formaat: het kleinbeeldformaat ook wel 35mm-formaat of full frame genoemd. Men heeft hiervoor gekozen omdat dit formaat in het analoge tijdperk decennia lang het populairst was. Voordat we echter formaten kunnen gaan vergelijken en de verschillen opnoemen, moet je eerst wat basiskennis hebben van licht, lenzen en sensoren. Daarna zullen we aan de hand van voorbeelden laten zien hoe die equivalentie in de praktijk toegepast kan worden. Disclaimer: veel theorie is vereenvoudigd en daarom niet altijd precies de werkelijkheid. Het staat een ieder vrij om kanttekeningen te plaatsen bij de vereenvoudigingen, maar laat dit niet in een discussie op zich uitlopen.

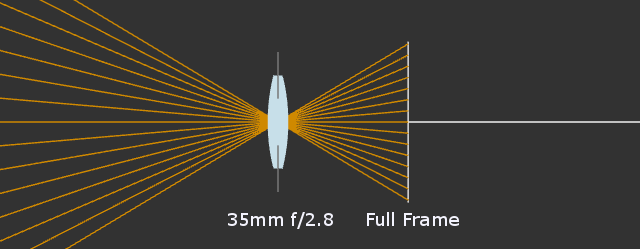

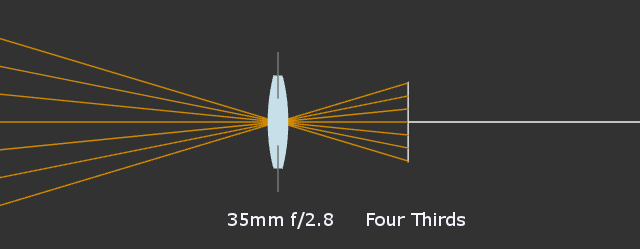

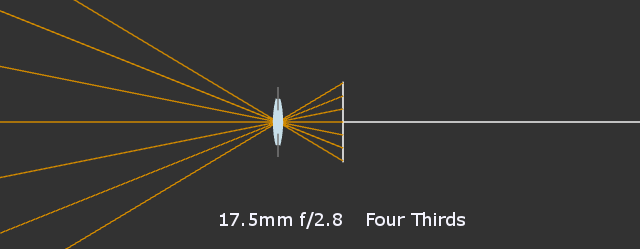

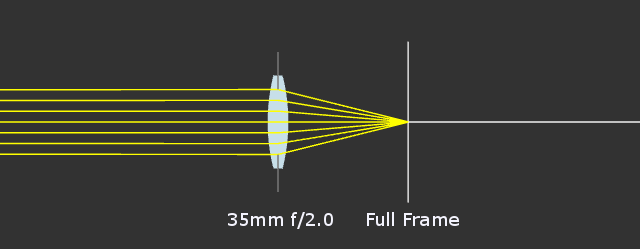

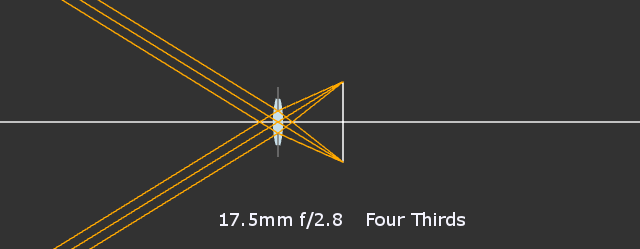

We gebruiken in de vergelijkingen hieronder een full frame camera en een m4/3 camera omdat dit makkelijker rekenen is vanwege de 2x cropfactor. Het zelfde is toe te passen op Nikon aps-c (1,5x cropfactor), Canon aps-c (1,6x cropfactor) en aps-h (1,3x cropfactor). De brandpuntsafstand van een lens is een fysieke eigenschap. Dus een 35mm lens blijft een 35mm lens ongeacht de sensorgrootte van de camera waarop deze lens geplaatst is. Wat wel afhankelijk is van de sensorgrootte is de beeldhoek die een lens geeft. Een kleinere sensor maakt een kleinere uitsnede, oftewel crop, dan een grotere sensor. Als je een 35mm lens op een m4/3 camera plaatst, geeft dit een veel smallere beeldhoek dan dezelfde lens op een full frame camera geeft. Hieronder een grafische weergave van het bovenstaande stukje.   Zoals je ziet is de hoek bijna gehalveerd van 63 graden op de full frame camera naar ongeveer 34 graden op de m4/3 camera. Door de grotere beeldhoek met de full frame camera krijg je dus een wijder beeld. Om een equivalente beeldhoek te krijgen op de m4/3 camera heb je een 17,5mm lens nodig wat een beeldhoek geeft van 63 graden en dus overeenkomt met de full frame camera met 35mm lens.

Het diafragma in een lens is een cirkelvormig mechanisme dat van diameter kan veranderen. Bij lenzen met een diafragmaring kun je dit goed zien, als je door de lens heen kijkt en aan de diafragmaring draait. Het kleiner maken van het diafragma heeft als resultaat dat er minder licht binnenkomt en de scherptediepte groter wordt. Het groter maken van het diafragma heeft het tegenovergestelde effect en laat meer licht binnen met als en een kleinere scherptediepte. Het diafragma wordt bij fotografie vaak aangeduid in een diafragmawaarde. Waarbij een kleiner getal staat voor een grotere opening. Dit vergt misschien een creatief stukje omredeneren. De diafragmawaarde wordt gerelateerd aan de brandpuntsafstand van de lens opgeschreven. Bijvoorbeeld 100mm f/2. Hierin is 100mm de brandpuntsafstand van de lens en staat de kleine f ook voor de brandpuntsafstand. f/2 levert dus 50mm op. Hoe groter het diafragam, hoe meer licht de lens doorlaat. Dit betekent dat een 100mm f/2 lens meer licht doorlaat dan een 50mm f/2 lens. 100/2 is immers meer dan 50/2. Toch levert dit dezelfde lichtintensiteit op, zodat je camera dezelfde instellingen kan gebruiken voor een 100mm f/2 lens als voor een 50mm f/2 lens. Dit heeft te maken met de beeldhoek van de lens. Een 100mm lens heeft een kleinere beeldhoek dan een 50mm lens, waardoor er ook minder licht vanaf je onderwerp in je lens terecht komt. Dit verschil wordt dan weer gecompenseerd door het grotere diafragma van de 100mm lens, zodat er evenveel licht op de sensor terecht komt. Voor de guru's: helaas is in de praktijk de lichtopbrengst van de ene f/2 lens niet hetzelfde als van de andere f/2 lens. Dit heeft te maken met de transmissie van het glas. Hoe helder het gebruikte glas ook is en hoe goed de coatings op het glas ook zijn, nooit wordt 100% van het opvallende licht doorgelaten. Tegenwoordig is dit minder een issue dan vroeger, maar vooral in de filmwereld wil men graag van lenzen de transmissie weten. De transmissie van lenzen wordt aangegeven met een transmissiewaarde zoals T3.1. Bijvoorbeeld een 100mm f/2.8 kan dan worden aangeduid met 100mm T3.1. Dit betekent dat de transmissie van deze lens vergelijkbaar is met een perfecte f/3.1 lens. Net zoals met de brandpuntsafstand is ook het diafragma helaas niet 1 op 1 over te nemen als we twee sensoren van verschillende groottes gaan vergelijken. Daarvoor moeten we weten wat het diafragma precies doet met het licht in deze situaties.

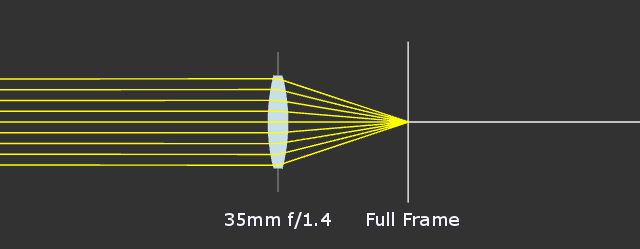

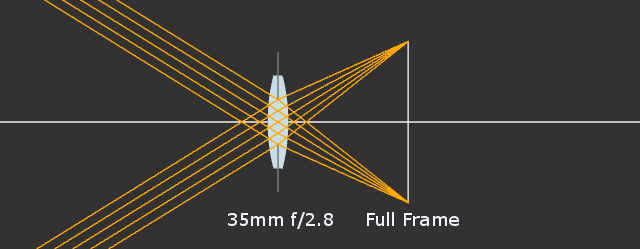

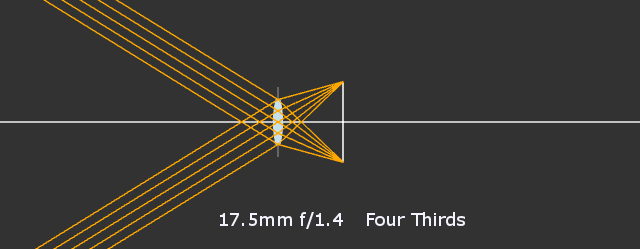

Een van de dingen waar het diafragma invloed op heeft is hoeveel licht er door de lens heen kan komen. Door een kleiner gaatje kan immers minder licht dan door een groot gat. Elke "stop" is een verdubbeling of halvering van de hoeveelheid licht. Dus als diafragma van een lens 1 stop wordt dichtgeknepen, komt er nog maar de helft aan licht doorheen. Als voorbeeld nemen we even een 35mm f/1.4 lens op een full frame sensor.  Als we het diafragma 1 stop dicht knijpen (van f/1.4 naar f/2.0) wordt het inkomende licht gehalveerd. Dit lijkt misschien gek omdat de diameter 1,4x kleiner is geworden en niet 2x. Dit komt omdat de oppervlakte bepalend is voor de hoeveelheid licht die doorgelaten wordt en niet de diameter. De oppervlakte is namelijk wel gehalveerd en kan berekend worden met de formule: O = ¼πd² (afgeleid van r = ½d en O = πr²). In dit geval is de oppervlakte van ongeveer 490mm² op f/1.4 naar ongeveer 245mm² op f/2 gegaan.  We weten nu dus dat de diafragmawaarde relatief is aan de brandpuntsafstand. Wat van groot belang is als we verschillende camerasensoren gaan vergelijken. Want zoals we in het vorige hoofdstuk behandeld hebben, verschilt de brandpuntsafstand met verschillende camerasensoren als we de beeldhoek gelijk willen houden. We nemen in dit voorbeeld weer even de 35mm f/2.8 lens op een full frame sensor en de equivalente 17,5mm lens op de m4/3 sensor (zoals vastgesteld in het vorige hoofdstuk).  Het diafragma van deze 35mm f/2.8 lens op een full frame sensor heeft een diameter van 35/2,8 = 12,5mm en daarmee een oppervlakte van ongeveer 123 mm². Zouden wij nu de equivalentie van het brandpunt negeren en direct met een 35mm f/2.8 op een m4/3 sensor vergelijken komen we natuurlijk op de zelfde waarden uit. Alleen levert dit niet dezelfde foto op, omdat de beeldhoek compleet anders is (zie vorige hoofdstuk).  Om het geheel equivalent te houden moeten we dus gaan vergelijken met een 17,5mm f/1.4 waarbij we zowel de brandpuntsafstand als diafragma gedeeld hebben door de crop factor, in het geval van een m4/3 sensor dus 2x. Je kan aan de afbeelding hier onder al zien dat de diameter van het diafragma even groot is als van de 35mm f/2.8 op een full frame sensor. Nu is dit Tweakers en willen we graag ook even de cijfers zien om het te geloven, tijd om te gaan rekenen.  Het diafragma van deze 17,5mm f/1.4 lens op een m4/3 sensor (met 2x crop factor) heeft een diameter van 17,5/1,4 = 12,5mm en daarmee een oppervlakte van ongeveer 123 mm². Daarmee is de totale oppervlakte van het diafragma exact even groot als van een 35mm f/2.8 op een full frame sensor.

Voor de mensen die thuis meeschrijven of geen zin hebben om een lap tekst te lezen. Full frame Brandpunt: 35mm Beeldhoek: 63,4° Diafragma: f/2.8 (diameter: 12,5mm, oppervlakte: 123 mm²) Nikon APS-C (1,5x cropfactor) Brandpunt: 23,33mm Beeldhoek: 63,4° Diafragma: f/1.86 (diameter: 12,5mm, oppervlakte: 123 mm²) Micro four thirds (m4/3, 2x cropfactor) Brandpunt: 17,5mm Beeldhoek: 63,6° Diafragma: f/1.4 (diameter: 12,5mm, oppervlakte: 123 mm²)

Scherptediepte, vaak afgekort DoF (depth of field) genoemd, is het gebied wat "in focus" is. Het punt waarop je focust, is altijd het scherpste. De scherpte neemt daarna langzaam af, totdat je het niet meer scherp kunt noemen en het "out of focus" is. Maar wat is nu "niet meer scherp"? Dit heeft te maken met hoe goed onze ogen scherpte kunnen waarnemen. Op het moment dat een punt een vlekje wordt, noemen we het onscherp. Deze vlek wordt ook wel Circle of Confusion genoemd en schaalt mee met het formaat van de foto. bij een grote afdruk ga je ook verderweg staan en is de CoC ongeveer gelijk als een kleinere foto waar je dichterop staat. Meer hierover kun je hier lezen: Wikipedia: Circle of confusion Tijdens het maken van een foto hangt de scherptediepte af van het gebruikte diafragma en de afstand tot je onderwerp. Met een groter diafragma krijg je minder scherptediepte en met een kleinere focusafstand krijg je minder scherptediepte. Als de brandpuntsafstand groter wordt gemaakt (met gelijk diafragma) moet je ook meer afstand nemen tot je onderwerp en blijft de scherptediepte uiteindelijk gelijk. Ook als je een lens van een full frame camera op een aps-c camera zet met dezelfde diafragmawaarde en focusafstand blijft de scherptediepte hetzelfde, maar is de uitsnede van de foto uiteraard wel anders

De sensor in een camera is een complex ding. Iedere pixel heeft een microlens, een kleurfilter, en een fotodiode met bijbehorende A/D convertor. Dit kleurenfilter wordt volgens een bepaald patroon over de pixels verspreid en zorgt ervoor dat de sensor kleuren kan "zien". Door bij iedere pixel slechts één kleur door te laten zien (rood, groen of blauw), is door combineren van deze kleurenpixels een kleurenfoto mogelijk.

De fotodiode en analoog-digitaal convertor werken samen om licht om te zetten in een digitale waarde. De fotodiode vangt licht en zet het om in een spanning. Helaas wordt niet al het licht omgezet, er zijn verliezen. Een deel raakt bijvoorbeeld niet de fotodiode maar de omliggende "bedrading". Ook is de fotodiode zelf niet 100% efficiënt; sommige fotonen worden niet omgezet in een elektrisch signaal (=quantum efficiëntie (afgeleid van DxOmark data)). Als laatste is er de "dark current"; er loopt een beetje stroom door de "well", waardoor er toch elektronen verzameld worden, ook als er geen fotonen worden gedetecteerd. Dit noemt men ook wel de "noise floor". Deze hangt ook af van de temperatuur. De rest van het licht wordt wel omgezet in een spanning en opgeslagen in de well. Hoe groter de well hoe meer elektronen er in passen, voordat de well verzadigd raakt. Na het verzadigen neemt het immers geen extra elektronen meer op. Een grote well heeft het voordeel dat de signaal-ruisverhouding hoger is; je kan nauwkeuriger het aantal fotonen waarnemen, terwijl de uitleesruis constant blijft. Kleinere sensoren hebben kleinere pixels en een kleinere well en dus een lagere signaal/ruisverhouding. Na het nemen van de foto wordt van iedere pixel de spanning uitgelezen en met de A/D convertor omgezet in een waarde tussen 0 en 4096 (12 bit per kanaal). Tussen AD converters op een sensor bestaan soms ook nog wat verschillen, waardoor een bepaalde spanning niet altijd resulteert in een dezelfde waarde. Sommige camera's hebben de optie om voor 14 bit te kiezen, waardoor de max waarde 214= 16384 is. Een nadeel hiervan is dat de raw bestanden ongeveer 17% groter zijn en de winst aan dynamic range klein is: Bron: Cambridge in Colour

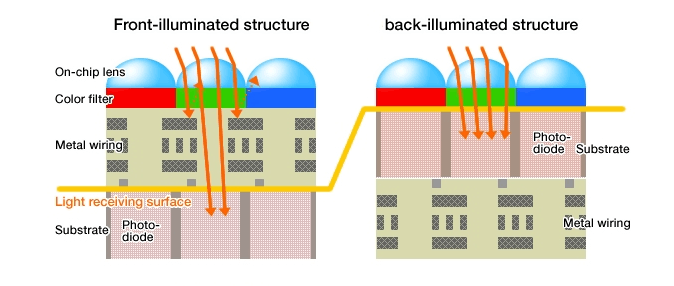

Licht bestaat uit fotonen, deze fotonen zijn de "dragers" van lichtenergie. Hoe meer fotonen per seconde er van een object komen, hoe feller het object is. De sensor is gevoelig voor deze fotonen. Het kan zijn dat de ene pixel nu net wel een foton vangt en de andere niet. Dit verschil noemen wij lichtintrinsieke ruis, aangezien het een eigenschap van licht is. In donkere plekken/gebieden zie je deze intrinsieke ruis veel sneller dan met zonlicht, want 1 foton meer of minder op 100.000 heeft veel minder invloed dan 1 op 10. Kleurruis is vrij makkelijk weg te filteren, omdat er vergeleken kan worden met de waarde van naastgelegen kleuren op de sensor. Luminantieruis is een stuk lastiger omdat het alle naastgelegen pixels evenveel beïnvloedt. Luminatieruis kan een foto behoorlijk beïnvloeden, en krijg je alleen met agressieve ruisreductie weg.  Deze oorzaak wordt vaak onderschat, en zie je het sterkste terug in donkere gebieden, waar een foton meer of minder relatief veel uitmaakt. Naast verschil in licht bij de bron, ontstaat er ook in de camera ruis. Op sensorniveau heb je vanwege de A/D convertors, quantum efficiëntie, dark current, pixelgrootte, front side illumination en ruimte tussen de pixels allemaal verliezen die bijdragen aan een slechtere signaal-ruis verhouding.

Net als bij lenzen geldt dat een verdubbeling van het oppervlak één stop extra licht wordt opgevangen. Een halvering van het aantal pixels zorgt ook dat de oppervlakte per pixel verdubbeld. Een sensor met minder pixels geeft veel voordelen, ruis zie je minder (als de foto op 100% bekeken wordt), maar je kunt ook de sensor sneller uitlezen. Voor de camera betekent het ook dat ie minder data hoeft te verwerken en dat je meer foto's in burst kan schieten. De buffer is minder snel vol en de data is eerder weggeschreven. Er zitten ook nadelen aan minder pixels: je kan minder scherpte waarnemen en je hebt minder ruimte om te croppen. Een misverstand is dat kleinere pixels tot meer ruis in de uiteindelijke foto leiden. Bij het bekijken van een foto op hetzelfde afdrukformaat geven de kleinere pixels totaal evenveel ruis als grotere pixels. Vergelijken van ruisprestaties tussen sensoren moet dan ook altijd op gelijk afdrukformaat gedaan worden.

Een overzicht van veelgebruikte sensorformaten  In een tabelletje met de verschillen in getallen

De termen "front side" en "back side illumination" kunnen wat verwarrend zijn, omdat men vanuit de halfgeleider kijkt. De bovenkant waar het licht vandaan komt, is dus de achterkant van de halfgeleider. Back side illumination is beter omdat het licht niet meer langs de bedrading hoeft en direct op de fotodiode valt. Door bsi te gebruiken heb je ongeveer 1/3 stop meer licht tot je beschikking. BSI is nog in opkomst; veel kleinere sensoren worden er al mee uitgerust, maar bij de grotere sensoren is het nog lang niet standaard. De Samsung NX1 had als eerste een bsi aps-c sensor. En daarnaast heeft de nieuwe Sony A7R II een full frame bsi sensor.

Een sensor heeft geen bewegende delen; hij kan niet even extra licht opvangen of zijn gevoeligheid aanpassen. Extra gevoeligheid toevoegen gaat niet. Bij iedere fotodiode op de pixel zit een well waarin het het signaal wordt opgeslagen. Een grotere pixel heeft een grotere well. De rechter pixel heeft een 2x zo groot oppervlak, daardoor neemt de inhoud van de well ook 2 maal toe. Dit zijn dwarsdoorsnedes.  In dit voorbeeld heeft de kleinere pixel een capaciteit van 10.000 elektronen en de grotere pixel een capaciteit van 20.000 elektronen. Beiden zijn hier voor de helft gevuld.  Nu is er door de diverse soorten ruis totaal 500 elektronen aan ruis ontstaan. Bij de kleinere pixel maken die 500 elektronen een groter deel van het totaal uit dan bij de grotere pixel.  De 12-bits AD convertor zet het aantal elektronen om in een waarde tussen 0 en 4096. Je ziet hier dat de linker pixel 100 stapjes helderder is dan de rechter pixel.  De ontstane ruis in een plaatje van een egaal grijs vlak.  Het instellen van de ISO gevoeligheid doet men met een digitaal truukje: de waardes na de A/D convertor worden vermenigvuldigd.  Een nadeel hiervan is dat alle ruis ook wordt versterkt. De uitleesruis blijft altijd hetzelfde, maar de thermische ruis en de fotonruis nemen wel toe naarmate de iso hoger wordt.  De ruis wordt nu duidelijk zichtbaar.  Hier zijn real world resultaten: Canon 5D mkIII iso800 vs Olympus E-M1 iso200  Canon 5D mkIII iso6400 vs Olympus E-M1 iso800

Een sensor verdeelt de helderheid in 4096 stapjes (=12 bit). Hierdoor kunnen 12 stops (=12 verdubbelingen) worden geregistreerd.  De base iso is de meest optimale stand van de camera: er wordt geen vermenigvuldiging toegepast. Hiermee heb je de minste ruis en het meeste dynamisch bereik. Sommige camera kunnen lager dan hun base iso, dit doen ze door de opname extra lang te belichten en daarna de waardes te delen.  Je hebt dan nog minder ruis, maar je kapt de hooglichten ook eerder af, waardoor het dynamisch bereik kleiner wordt.

Als we alles op een rijtje zetten, kunnen we een paar conclusies trekken. Wanneer we camera's (sensoren met lenzen) met elkaar vergelijken, kunnen we dit op verschillende manieren doen. Eigenschappen zoals sensorgrootte, brandpuntsafstand en diafragma hebben veel invloed op het uiteindelijke beeld. Als we eerlijk willen vergelijken, dien je rekening te houden met de crop-factor bij zowel brandpuntsafstand en diafragma. Indien je dat doet, krijg je dezelfde beeldhoek, dezelfde scherptediepte en dezelfde hoeveelheid ruis (mits zelfde sensortechnologie) bij dezelfde sluitertijd. Voor de liefhebbers van vuistregels, hebben we er 1: ruis gaat altijd samen met scherptediepte Wil je zelf nog wat spelen met lichtstralen om de equivalentietekeningen zelf te maken: https://mrc4.nl/meuk/projecties/diafragma.html Nog een laatste opmerking: dit alles is puur de techniek in de camera zelf en zegt niets over fotografische kwaliteiten en wat het beste is. Een camera is meestal slechts een stuk gereedschap of voor sommigen iets om in een vitrinekast te zetten, maar maakt niet zelf de foto's. Dat doet de persoon die de camera bedient. |

[ Voor 0% gewijzigd door Universal Creations op 10-08-2017 19:05 ]

ora et labora

:strip_icc():strip_exif()/u/373647/b1aa8209a437bf987cf066823c044f0a.jpeg?f=community)

:strip_icc():strip_exif()/u/1981/Image00001.jpg?f=community)

:strip_icc():strip_exif()/u/162143/crop5b6d888e9cc79_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/59664/crop63e2bd9de7d58_cropped.jpg?f=community)

/u/276077/cerberus.png?f=community)

:strip_icc():strip_exif()/u/35381/2532909.jpg?f=community)

:strip_exif()/u/106968/belkar2.gif?f=community)

:strip_icc():strip_exif()/u/496922/Balance%252060x60.jpg?f=community)

/u/369276/crop5dbad118e94c6_cropped.png?f=community)

/u/237448/crop5c6563ec880df.png?f=community)

/u/757673/crop5f7b6e38be093_cropped.png?f=community)

/u/890799/crop595ce6d0de4f0_cropped.png?f=community)

/u/602366/crop6478e12ac629b.png?f=community)

:strip_exif()/u/586016/crop56e077980b180_cropped.gif?f=community)