foto van een rommelige zooi heeft m.i. helemaal niets met Tweaken te maken, lijkt mij eerder de zooi van iemand die te lui is om het een beetje netjes opgebouwd te houden?tHe_BiNk schreef op vrijdag 21 september 2012 @ 21:45:

...een echte tweaker...

Wat is dat witte ding dan rechts in het rack? Ik had het idee dat het een APC Back-UPS is.Verwijderd schreef op zaterdag 22 september 2012 @ 13:43:

Valt wel mee, een tijdje terug voor 120 euro op de kop kunnen tikken. En hij wordt wel degelijk als 19" rack gebruikt, alleen zit de ups helemaal bovenin, en is hij dus niet zichtbaar op deze foto.

Verwijderd

Dat is een kartonnen doos.

Ik zal maar even het vooraanzicht plaatsen:

Straks zal ik ook nog effe wat schrijven over de server zelf, aangezien die toch een plaatsje heeft (ergens onderaan) in de ranglijst.

Ik zal maar even het vooraanzicht plaatsen:

Straks zal ik ook nog effe wat schrijven over de server zelf, aangezien die toch een plaatsje heeft (ergens onderaan) in de ranglijst.

[ Voor 34% gewijzigd door Verwijderd op 22-09-2012 13:56 ]

| Mainboard | Gigabyte GA-H67M-UD2H-B3 |

| Geheugen | Kingston HyperX Blu 8GB DDR3 |

| Processor | Intel i3-2100T |

| OS Drive | Western Digital Blue WD5000AAKS |

| Raid Controller | Intel RAID Controller SASUC8I |

| Raid Level | Raid 6 via mdadm |

| Storage | 10x Western Digital Green WD20EARS, 2TB |

| Case | Lian Li PC-A77FB |

| Power Idle | geen idee |

| OS | OpenSuse 12.2 |

| Functies | Samba XBMC glftpd uTorrent |

En de foto's

De schijven bovenin, moeten ook nog in zo'n Bay, maar diegene waar ze in horen is kapot. Na verloop van tijd vallen de schijven uit de array.

* HyperBart meldt zich... Weliswaar nipt over de benodigde hoeveelheid, maar toch...

[tr]

[td][url=<link naar post met systeem>] HyperBart[/url][/td][td] 10.7 TB[/td][td] <RAID level> [/td][td] 5[/td][td]ZFSguru (FreeBSD)[/td][td]N40L MicroServer met 4 hotswapbays en de Optical Disk Drive Bay opgevuld met de 5de disk[/td]

[/tr]

Ik heb de N40L EN de disks tweedehands aangekocht. Thuis draaide nog een ESXi-machine met 32GB geheugen. Deze werd zwaar ondergebruikt qua memory, dus ik heb 16GB van de 32GB ECC UDIMM er uit gehaald en deze in de N40L gestoken.

N40L by hyperbart, on Flickr

Omdat de N40L standaard maar ruimte heeft voor 4 x 3,5" disks heb ik de Optical Disk Drive Bay "misbruikt" om er een 5de disk in te plaatsen... Voorlopig heb ik het quick'n'dirty gedaan, maar in de toekomst wordt deze ODD opgevuld met een bay waarin een 3,5 en 2,5 inch disk in kan.

Tiewrap Disk 5 by hyperbart, on Flickr

Vervolgens heb ik ZFSguru op een Kingston USB-stickje geïnstalleerd, de disken er in gestoken en een RAIDZ-pool aangemaakt.

De server performt behoorlijk goed qua throughput maar de IOPS vallen omwille van het technische karakter van ZFS natuurlijk wat tegen zonder SSD...

De 5de disk wordt niet via de SAS-kabel van de cage met de 4 hotswapbays met het moederbord verbonden maar met een aparte SATA-kabel die je netjes via de binnenkant van de N40L kan routeren:

Onboard SATA + USB by hyperbart, on Flickr

Disk 5 Cabling by hyperbart, on Flickr

Tiewrap Disk 5 by hyperbart, on Flickr

Je ziet hierboven dat de sluiting van één van de tiewraps er wat raar uitziet. Dat komt omdat ik met een aansteker deze wat "afgesmolten" heb zodat de scherpe kantjes er wat van af zijn en het geheel ook definitief vast zit.

In het begin had ik wat problemen om de 5de disk te laten detecteren. Hiervoor moet een gemodifieerd BIOS op de N40L geflashed worden. Ik had dat gedaan, maar de 5de disk werd niet gedetecteerd. Na enkele minuten had ik iets van "laat ik de disk eens checken", deze was opgespinned, maar bij nadere inspectie:

Detail Disk 5 ODD SATA disconnected by hyperbart, on Flickr

Stap 1: Check de kabel!

Foto's zijn hier allemaal te vinden:

http://www.flickr.com/pho...3/sets/72157631596551214/

| System specifications | |

| Component | Value |

|---|---|

| Case | HP N40L MicroServer |

| CPU | AMD Turion II Neo |

| RAM | 2 x 8GB ECC UDIMM |

| Motherboard | HP |

| Operating system | FreeBSD 9 (ZFSguru) |

| Controller | Onboard HP SAS/SATA |

| Hard drive | 5 x Hitachi Deskstar 7K300 3TB |

| RAID array configuration | Boot: Kingston USB 4GB RAIDZ : 5 x 3TB |

| Netto storage capacity | 12 TB |

| DD Read | 506.29 MB/s |

| DD Write | 175.41 MB/s |

| Network | Onboard + 2x GBit HP NC360T Low Profile Dual NIC |

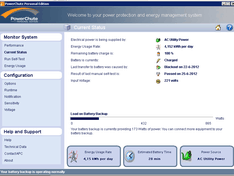

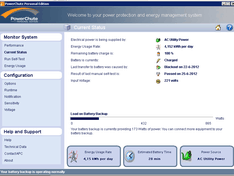

| UPS | APC BackUPS |

| Filesystem | ZFS |

| Idle power usage | Voorlopig onbekend |

| Extra | Kleinste bakje waar ik zoveel storage in kon proppen. In de toekomst had ik graag een SSD toegevoegd en de ODD-bay netjes uitgerust met een bay voor die SSD en de 3,5 inch HDD die daar nu nog in ligt met tiewraps (wat ik eigenlijk nu ook niet zo slecht gedaan vind Met mijn write-speeds is op dit moment nog iets geks aan de hand: met 4 disks haal ik hogere snelheden dan met 5 |

[tr]

[td][url=<link naar post met systeem>] HyperBart[/url][/td][td] 10.7 TB[/td][td] <RAID level> [/td][td] 5[/td][td]ZFSguru (FreeBSD)[/td][td]N40L MicroServer met 4 hotswapbays en de Optical Disk Drive Bay opgevuld met de 5de disk[/td]

[/tr]

Ik heb de N40L EN de disks tweedehands aangekocht. Thuis draaide nog een ESXi-machine met 32GB geheugen. Deze werd zwaar ondergebruikt qua memory, dus ik heb 16GB van de 32GB ECC UDIMM er uit gehaald en deze in de N40L gestoken.

N40L by hyperbart, on Flickr

Omdat de N40L standaard maar ruimte heeft voor 4 x 3,5" disks heb ik de Optical Disk Drive Bay "misbruikt" om er een 5de disk in te plaatsen... Voorlopig heb ik het quick'n'dirty gedaan, maar in de toekomst wordt deze ODD opgevuld met een bay waarin een 3,5 en 2,5 inch disk in kan.

Tiewrap Disk 5 by hyperbart, on Flickr

Vervolgens heb ik ZFSguru op een Kingston USB-stickje geïnstalleerd, de disken er in gestoken en een RAIDZ-pool aangemaakt.

De server performt behoorlijk goed qua throughput maar de IOPS vallen omwille van het technische karakter van ZFS natuurlijk wat tegen zonder SSD...

De 5de disk wordt niet via de SAS-kabel van de cage met de 4 hotswapbays met het moederbord verbonden maar met een aparte SATA-kabel die je netjes via de binnenkant van de N40L kan routeren:

Onboard SATA + USB by hyperbart, on Flickr

Disk 5 Cabling by hyperbart, on Flickr

Tiewrap Disk 5 by hyperbart, on Flickr

Je ziet hierboven dat de sluiting van één van de tiewraps er wat raar uitziet. Dat komt omdat ik met een aansteker deze wat "afgesmolten" heb zodat de scherpe kantjes er wat van af zijn en het geheel ook definitief vast zit.

In het begin had ik wat problemen om de 5de disk te laten detecteren. Hiervoor moet een gemodifieerd BIOS op de N40L geflashed worden. Ik had dat gedaan, maar de 5de disk werd niet gedetecteerd. Na enkele minuten had ik iets van "laat ik de disk eens checken", deze was opgespinned, maar bij nadere inspectie:

Detail Disk 5 ODD SATA disconnected by hyperbart, on Flickr

Stap 1: Check de kabel!

Foto's zijn hier allemaal te vinden:

http://www.flickr.com/pho...3/sets/72157631596551214/

[ Voor 15% gewijzigd door HyperBart op 24-09-2012 08:27 ]

De link die je nu maakt is voor in de lijst, maar ik mis nog de tabel "Tabel met systeem info" met specs, zoals beschreven in de topic start. Wel leuk compact storage doosje. Heb 'm zelf ook maar dan puur als Linux-based internet router.

[ Voor 5% gewijzigd door Q op 23-09-2012 01:50 ]

Bij deze aangepast  .

.

Kan zijn dat ik je wel nog even een nieuwe DD-snelheid meedeel, ben daar nu nog wat mee aan het troubleshooten (met 4 disks valt de dd write hoger uit dan met 5 onder ZFS).

Als je een idee hebt waarom dat kan hoor ik het graag . We zijn er over aan het brainstormen in het ZFS topique...

. We zijn er over aan het brainstormen in het ZFS topique...

Kan zijn dat ik je wel nog even een nieuwe DD-snelheid meedeel, ben daar nu nog wat mee aan het troubleshooten (met 4 disks valt de dd write hoger uit dan met 5 onder ZFS).

Als je een idee hebt waarom dat kan hoor ik het graag

Kun je der nu ook nog een extra raid kaar of iets inzetten voor extra disken? Denk aan SSD's die je nog ergens weg kunt proppen.

ICTWebSolution - Wi-Fi Problemen? Stuur maar een berichtje! - Wi-Fi Bereik verbeteren?

Absoluut... Ik weliswaar niet meer, maar je kan perfect nog een PCIe slot gebruiken voor een M1015 oid...djkavaa schreef op zondag 23 september 2012 @ 08:26:

Kun je der nu ook nog een extra raid kaar of iets inzetten voor extra disken? Denk aan SSD's die je nog ergens weg kunt proppen.

Dat zou op termijn ook nog de "last resort" kunnen zijn om deze bak qua storage te upgraden: extra kaart er in, zo een 5,25 naar 6x2,5inch bay en die nog volsteken met laptopdiskjes...

Ja bijvoorbeeld, die zullen ook snel wel goedkoper worden en dan nog 2x ssd en 4x 1tb laptop disk zal ook goed gaan:)HyperBart schreef op zondag 23 september 2012 @ 20:16:

[...]

Absoluut... Ik weliswaar niet meer, maar je kan perfect nog een PCIe slot gebruiken voor een M1015 oid...

Dat zou op termijn ook nog de "last resort" kunnen zijn om deze bak qua storage te upgraden: extra kaart er in, zo een 5,25 naar 6x2,5inch bay en die nog volsteken met laptopdiskjes...

ICTWebSolution - Wi-Fi Problemen? Stuur maar een berichtje! - Wi-Fi Bereik verbeteren?

Nu, de kans dat het dat gaat worden is behoorlijk klein:

Vermoedelijk consolideer ik tegen dan mijn QNAP en N40L in mijn ESXi-server...

Dat zou dan betekenen dat ik met volgende spindles zit:

6 Seagates van 2TB

5 Hitachi's van 3TB

de 6 Seagates gaan omwille van hun onbetrouwbaarheid in een RAIDZ2 array en de 5 Hitachi's blijven gewoon in RAIDZ draaien...

Het leuke is op dit moment dat ik de data die op mijn QNAP nog volledig kan overzetten naar mijn N40L en de QNAP kan degraderen tot backupserver. Maw: mijn data is nog niet zo gegroeid dat ik de capaciteit van mijn Seagates nog nodig heb.

Vermoedelijk consolideer ik tegen dan mijn QNAP en N40L in mijn ESXi-server...

Dat zou dan betekenen dat ik met volgende spindles zit:

6 Seagates van 2TB

5 Hitachi's van 3TB

de 6 Seagates gaan omwille van hun onbetrouwbaarheid in een RAIDZ2 array en de 5 Hitachi's blijven gewoon in RAIDZ draaien...

Het leuke is op dit moment dat ik de data die op mijn QNAP nog volledig kan overzetten naar mijn N40L en de QNAP kan degraderen tot backupserver. Maw: mijn data is nog niet zo gegroeid dat ik de capaciteit van mijn Seagates nog nodig heb.

Staat in de lijst, 5x3TB in RAIDZ = 12 TB netto. toch?HyperBart schreef op zondag 23 september 2012 @ 02:05:

Bij deze aangepast.

Kan zijn dat ik je wel nog even een nieuwe DD-snelheid meedeel, ben daar nu nog wat mee aan het troubleshooten (met 4 disks valt de dd write hoger uit dan met 5 onder ZFS).

Als je een idee hebt waarom dat kan hoor ik het graag. We zijn er over aan het brainstormen in het ZFS topique...

Ja, maar ik had al gerekend in de "echte capaciteit" die ik ter beschikking heb. Maar het klopt dat volgens de regeltjes ik eigenlijk 12TB beschikbaar heb, dus 10,7 à 10,8 TiB.

Hoe is het afgelopen met de 4TB?lampie1979 schreef op dinsdag 28 augustus 2012 @ 23:22:

1 extra 3TB en een 4TB zijn onderweg. Gekozen voor Hitachi externe (gezien die substantieel goedkoper zijn dan interne...). Open maken en inbouwen die handel.

Eens kijken hoe die 4TB samengaat met de 1280ML. Areca heeft mij verzekerd dat dat gaat werken.

Ben benieuwd.

Heeft die ook volledige diepte? Of is het een halve variant?Verwijderd schreef op zaterdag 22 september 2012 @ 13:33:

Voor diegene wat zich afvragen of zo'n 19"rackje wel handig is, het zijn prima bureaubladextensions:

[afbeelding]

Mocht het een hele zijn ben ik wel benieuwd naar het typenummer, zoiets moet ik ook nog op de kop tikken voor weinig

Sony A7III | Sony a6300 | Sony ZV-E1 | 12 2.0 | 21 1.4 | 24 1.4 | 35 2.8 | 50 1.4 | 135 1.8 | 16-28 2.8 | 16-70 4 | 28-75 2.8 | 70-200 2.8 II |

Verwijderd

De kast is precies 1 meter diep. Het typenummer is overigens HP S10614. Een tijdje terug waren er een aantal op marktplaats die van de hand gingen voor 120 á 170 euro.

Hier dan eindelijk het overzicht van mijn systeem.

In de Norco case zijn de fans vervangen voor NoiseBlocker fans, om het geluid wat te dempen. De 12 4TB disks hangen aan de Areca controller in RAID6 met een global hotspare.

Ik heb voor RAID6 gekozen om het uitvallen van 2 disks te kunnen opvangen en de global hotspare zodat rebuilden meteen kan beginnen. Met zo een grote raid array moet je het wel

de tijd gunnen om te kunnen rebuilden.

Voor boot worden de 2 SSD's in RAID1 gebruikt. Aangezien de Areca al vol zit, zitten deze direct op het moederbord. De RAID1 config gebeurt via MDADM.

De /boot draait op ext3, en de rest op BTRFS.

Ik heb veel foto's gemaakt van elke stap van het proces, maar kwam er een beetje laat achter dat de flits niet goed stond afgesteld. Er zijn dus niet zo

veel bruikbare foto's

Voor de 2 SSD's is in de Norco case standaard geen plek. Ik heb hiervoor de 2 onderste expansion slots gebruikt. Deze vallen buiten het bereik van het moederbord

en zijn hiermee ook nog hotswapable.

De 2 NoiseBlocker fans doen hun werk goed.

Hier een van de Mellanox kaartjes. Aangezien de storage server gebruikt voor media opslag, maar ook VM storage, vond ik performance redelijk belangrijk. Hierom heb ik

3 van deze Mellanox kaartjes aangeschaft. De kaart in de storage server heeft een directe verbinding naar elk van de 2 vHosts. Deze verbinding wordt puur en alleen gebruikt

voor 'storage' verkeer. Het enige wat er overheen gaat zijn de iSCSI connecties tussen de vHost's en de storage server.

Performance

Ik heb even een paar simpele DD testjes gedaan.

Disclaimer: De DD tests zijn gedaan op een draaiende omgeving met 15 active VM's

Allereerst de local DD tests :

Schrijven op de storage bak zelf van een 10GB file.

Teruglezen van de 10GB file op de storage bak.

Schrijven op de storage bak zelf van een 100GB file.

Teruglezen van de 100GB file op de storage bak.

Schrijven van een 10GB file over het netwerk.

Teruglezen van de 10GB file over het netwerk.

Schrijven van een 100GB file over het netwerk.

Teruglezen van een 100GB file over het netwerk.

Dit is allemaal over de Infiniband controller. Ik heb de Intel quad-port niet getest, maar die draait in een 802.3ad trunk op de switch.

| System specifications | |

| Component | Value |

|---|---|

| Case | Norco RPC-4224 |

| CPU | Intel Xeon E3-1230 8M @ 3.2Ghz |

| RAM | Kingston 16GB 1333Mhz DDR3 ECC CL9 |

| Motherboard | SuperMicro X9SCM-F |

| Operating system | SLES11 SP2 |

| Controller | Areca ARC-1882ix |

| Hard drive | 12 x Hitachi DeskStar 7K4000 4TB |

| Hard drive | 2 x Crucial CT128M4SSD2 128GB |

| RAID array OS | 2 x 80GB RAID1 (MDADM) |

| RAID array DATA | 12 x 4TB RAID6 (+ Global HotSpare) |

| Netto storage capacity | 36 TB |

| Network | Intel i350-T4, Quad port |

| Network | Mellanox MHEA28-XT 10Gb/s Dual-Port Infiniband |

| UPS | Sweex 1500 |

| Filesystem | BTRFS voor shares, iSCSI block-dev's voor de VM's |

| Idle power usage | Onbekend (stroom-meter kaduuk) |

| Extra | - |

In de Norco case zijn de fans vervangen voor NoiseBlocker fans, om het geluid wat te dempen. De 12 4TB disks hangen aan de Areca controller in RAID6 met een global hotspare.

Ik heb voor RAID6 gekozen om het uitvallen van 2 disks te kunnen opvangen en de global hotspare zodat rebuilden meteen kan beginnen. Met zo een grote raid array moet je het wel

de tijd gunnen om te kunnen rebuilden.

Voor boot worden de 2 SSD's in RAID1 gebruikt. Aangezien de Areca al vol zit, zitten deze direct op het moederbord. De RAID1 config gebeurt via MDADM.

De /boot draait op ext3, en de rest op BTRFS.

Ik heb veel foto's gemaakt van elke stap van het proces, maar kwam er een beetje laat achter dat de flits niet goed stond afgesteld. Er zijn dus niet zo

veel bruikbare foto's

Voor de 2 SSD's is in de Norco case standaard geen plek. Ik heb hiervoor de 2 onderste expansion slots gebruikt. Deze vallen buiten het bereik van het moederbord

en zijn hiermee ook nog hotswapable.

De 2 NoiseBlocker fans doen hun werk goed.

Hier een van de Mellanox kaartjes. Aangezien de storage server gebruikt voor media opslag, maar ook VM storage, vond ik performance redelijk belangrijk. Hierom heb ik

3 van deze Mellanox kaartjes aangeschaft. De kaart in de storage server heeft een directe verbinding naar elk van de 2 vHosts. Deze verbinding wordt puur en alleen gebruikt

voor 'storage' verkeer. Het enige wat er overheen gaat zijn de iSCSI connecties tussen de vHost's en de storage server.

Performance

Ik heb even een paar simpele DD testjes gedaan.

Disclaimer: De DD tests zijn gedaan op een draaiende omgeving met 15 active VM's

Allereerst de local DD tests :

Schrijven op de storage bak zelf van een 10GB file.

Teruglezen van de 10GB file op de storage bak.

Schrijven op de storage bak zelf van een 100GB file.

Teruglezen van de 100GB file op de storage bak.

Schrijven van een 10GB file over het netwerk.

Teruglezen van de 10GB file over het netwerk.

Schrijven van een 100GB file over het netwerk.

Teruglezen van een 100GB file over het netwerk.

Dit is allemaal over de Infiniband controller. Ik heb de Intel quad-port niet getest, maar die draait in een 802.3ad trunk op de switch.

-==||| INSANE |||==-

Eindelijk ook maar eens een post van mijn systeem. Heeft wel wat voeten in de aarde gehad maar uiteindelijke draait de server naar tevredenheid.

Edit: Na aanleiding van tips van CiPHER een paar post na deze heb ik toch een aantal wijzigingen doorgevoerd. Zo heb ik een areca backup battery unit aangeschaft. Tevens zijn molex naar sata connectoren vervangen door connectoren van Silverstone. Om het overzichtelijk te houden heb ik deze post inclusief plaatjes aangepast.

Was begonnen met een intel moederbord de Intel Desktop Board DH67BL (B3) met Areca 1220. Hierop kreeg ik echter de Areca kaart niet aan het werk. Het systeem wilde niet booten met de Areca kaart. Navraag bij de Intel support community leerde mij dat het pci slot op dat moederbord deze kaar niet ondersteunde. Zie hier voor de reactie op de Intel support community. Na een tip van een mede tweakers overgestapt naar dit super micro bordje met ECC geheugen. Helaas werke de kaart ook niet in dit systeem. Bleek de kaart dus overleden. Van een mede tweaker een Areca 1222 over kunnen nemen en nu werkt het prima.

De server wordt voornamelijk gebruikt om backups te maken van twee workstations en een laptop. Daarnaast heb ik al mijn cd's gedigitaliseerd als FLAC file en staan deze ook op de server. Tot slot draait SABNzbd op het systeem.

Hieronder de foto's;

Voor een grotere versie klik hier

Voor een grotere versie klik hier

Voor een grotere versie klik hier

Ben redelijk tevreden over het kabelmanagement op twee zaken na.

Edit: Na aanleiding van tips van CiPHER een paar post na deze heb ik toch een aantal wijzigingen doorgevoerd. Zo heb ik een areca backup battery unit aangeschaft. Tevens zijn molex naar sata connectoren vervangen door connectoren van Silverstone. Om het overzichtelijk te houden heb ik deze post inclusief plaatjes aangepast.

| System specifications | |

| Component | Value |

|---|---|

| Case | Cooler Master CM 690 II Advanced |

| CPU | Intel Pentium G620 |

| RAM | 2 x Kingston ValueRam KVR1333D3E9SK2/8G |

| Motherboard | Supermicro X9SCM-F |

| Operating system | WHS 2011 |

| Controller | Areca ARC-1222-SAS met BBU |

| Hard drive (boot) | Western Digital Green WD10EZRX |

| Hard drive array | 8 x Samsung Spinpoint F4 EG HD204UI |

| RAID array configuration | RAID5 : 8 x 2TB waarvan 1 hotswap |

| Netto storage capacity | 12 TB |

| Network | Onboard Intel 82574L Gigabit Ethernet |

| UPS | Nog geen. Wordt aan gewerkt |

| Idle power usage | 78 watt zonder spindown |

| Extra | Wordt gebruikt voor: (1)backup van 2 workstations en laptop (2) fileserver voor foto's, muziek, series en films (3)downloadbak |

Was begonnen met een intel moederbord de Intel Desktop Board DH67BL (B3) met Areca 1220. Hierop kreeg ik echter de Areca kaart niet aan het werk. Het systeem wilde niet booten met de Areca kaart. Navraag bij de Intel support community leerde mij dat het pci slot op dat moederbord deze kaar niet ondersteunde. Zie hier voor de reactie op de Intel support community. Na een tip van een mede tweakers overgestapt naar dit super micro bordje met ECC geheugen. Helaas werke de kaart ook niet in dit systeem. Bleek de kaart dus overleden. Van een mede tweaker een Areca 1222 over kunnen nemen en nu werkt het prima.

De server wordt voornamelijk gebruikt om backups te maken van twee workstations en een laptop. Daarnaast heb ik al mijn cd's gedigitaliseerd als FLAC file en staan deze ook op de server. Tot slot draait SABNzbd op het systeem.

Hieronder de foto's;

Voor een grotere versie klik hier

Voor een grotere versie klik hier

Voor een grotere versie klik hier

Ben redelijk tevreden over het kabelmanagement op twee zaken na.

- De kabels van de voeding die in het moederbord gaan zijn te kort. Deze kunnen niet achterlangs. Dit komt mede door de plaats van de aansluitingen op het moederbord. Misschien dat ik ooit mijn voeding nog ga vervangen.

- De voeding heeft te weinig sata aansluitingen. Ik heb daarom een aantal verloopjes gekocht van molex=> sata. Ik vraag me alleen af of er niet meer hd's op één molex aangesloten kunnen worden. Dit kan ook schelen in de warboel. Edit aangepast en Silverstone connectors gekocht. Dit is dus sterk verbeterd.

[ Voor 10% gewijzigd door jjust op 27-09-2012 13:15 ]

voor mij verrassende keuze (dezelfde norco kast en areca gebruik ik ook) van hardware raid in combinatie met gebruikte OS en filesystem. Gebruik je deze setup zo om met SLES en btrfs te kunnen testen?Intellium schreef op maandag 24 september 2012 @ 15:50:

Hier dan eindelijk het overzicht van mijn systeem.

Holy shit, mag ik na 3 jaar eindelijk de read performance kroon aan iemand anders overdragen, 1,6 GB/s is best pittig. Test dat ook nog eens met een 100 GB file als je wilt, want je hebt zoveel RAM.Intellium schreef op maandag 24 september 2012 @ 15:50:

Hier dan eindelijk het overzicht van mijn systeem.

Maak even een tabelletje voor je entry in de grote lijst.

[ Voor 7% gewijzigd door Q op 24-09-2012 20:19 ]

Een vraag vooral: is BTRFS goed genoeg? Gebruik je enkel die Infiniband kaart of ook andere want ik dacht dat ESXi die niet ondersteunde.

[ Voor 55% gewijzigd door analog_ op 25-09-2012 01:32 ]

Mooie setup, man!Intellium schreef op maandag 24 september 2012 @ 15:50:

...

Hier een van de Mellanox kaartjes. Aangezien de storage server gebruikt voor media opslag, maar ook VM storage, vond ik performance redelijk belangrijk. Hierom heb ik

3 van deze Mellanox kaartjes aangeschaft. De kaart in de storage server heeft een directe verbinding naar elk van de 2 vHosts. Deze verbinding wordt puur en alleen gebruikt

voor 'storage' verkeer. Het enige wat er overheen gaat zijn de iSCSI connecties tussen de vHost's en de storage server.

...

Wat stel je via iSCSI aan je vHosts ter beschikking, een vdisk_fileio of een vdisk_blockio?

Als ik deze VMWare pdf mag geloven werkt RDMA onder ESXi 5. Als je 't VMWare community forum rondom IB afschuimt kom je minder glorieuze reacties tegen m.b.t. de overdrachtssnelheid en de tip om vooralsnog bij ESXI 4 te blijven.analog_ schreef op dinsdag 25 september 2012 @ 01:25:

Een vraag vooral: is BTRFS goed genoeg? Gebruik je enkel die Infiniband kaart of ook andere want ik dacht dat ESXi die niet ondersteunde.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Verwijderd

Je wilt géén Molex gebruiken omdat die 4-polige stekkers regelmatig slecht/niet contact maken. Dit kan dan zorgen voor twee schijven die plots even geen stroom krijgen. Hier kun je vrij ernstige problemen mee krijgen door tijdens gebruik je array de failen of degraden. Later moet je dan weer rebuilden wat een eeuwigheid duurt.jjust schreef op maandag 24 september 2012 @ 17:58:

De voeding heeft te weinig sata aansluitingen. Ik heb daarom een aantal verloopjes gekocht van molex=> sata. Ik vraag me alleen af of er niet meer hd's op één molex aangesloten kunnen worden. Dit kan ook schelen in de warboel.

Je wilt liever alleen SATA stekkers gebruiken, en dan in het bijzonder deze:

pricewatch: Silverstone SST-CP06 4x SATA

Als je geen BBU hebt moet je je Areca instellen als Write-Through en níet als Write-Back. Areca is één van de weinige controllers die je onveilig laat draaien dus Write-Back inschakelen zonder BBU. Andere controllers verbieden dat, omdat het je data kan corrumperen in geval van onverwacht stroomverlies. De data in de RAM van de controller ben je dan kwijt, inclusief de metadata waar het allemaal om draait.Tot slot heb ik nog geen UPS hier ga ik nog eens voor kijken. Verder heeft de Areca kaart een mogelijkheid tot aansluiten van een Battery Backup Unit.

HP kan het tegenwoordig ook. "Enable write-cach while battery is absent or broken"

Even niets...

Bedankt voor de tips. Ik was er zelf ook niet zo gelukkig mee. Geen BBU is verkeerde zuinigheid. Heb inmiddels een BBU binnen. Heb een Mycom winkel erg blij gemaakt door hem bij ze af te halen. Zij hadden deze speciaal besteld voor een klant maar die zag er vanaf.

De sata stekkers heb ik inmiddels ook online besteld. Op dit moment heb ik twee keer twee sata aansluitingen op de voeding. Ik moet in totaal 9 schijven van prik voorzien. Zou ik op eén van die sata voedingsdraden in totaal vijf schijven kunnen aansluiten? Dus één direct en vier via de Silverstone stekkers?

Ik gebruik SLES voornamelijk omdat ik onder OpenSUSE de drivers voor de infiniband controller maar niet goed gecompiled kreeg. SLES dropped ext4 support, en gaat richting BTRFS, dus is ook een mooi moment om daar eens mee te testen.BartNL schreef op maandag 24 september 2012 @ 20:07:

[...]

voor mij verrassende keuze (dezelfde norco kast en areca gebruik ik ook) van hardware raid in combinatie met gebruikte OS en filesystem. Gebruik je deze setup zo om met SLES en btrfs te kunnen testen?

Ik gebruik de infiniband controller voor de iSCSI connecties. De storage bak heeft zoals je in de table ziet, ook een Intel quad-port gigabit adapter. Vooralsnog lijkt BTRFS goed te performen.analog_ schreef op dinsdag 25 september 2012 @ 01:25:

Een vraag vooral: is BTRFS goed genoeg? Gebruik je enkel die Infiniband kaart of ook andere want ik dacht dat ESXi die niet ondersteunde.

BlockIO. Ik gebruik geen ESX, maar KVM op me vhosts...Pantagruel schreef op dinsdag 25 september 2012 @ 10:30:

[...]

Mooie setup, man!

Wat stel je via iSCSI aan je vHosts ter beschikking, een vdisk_fileio of een vdisk_blockio?

[...]

Als ik deze VMWare pdf mag geloven werkt RDMA onder ESXi 5. Als je 't VMWare community forum rondom IB afschuimt kom je minder glorieuze reacties tegen m.b.t. de overdrachtssnelheid en de tip om vooralsnog bij ESXI 4 te blijven.

-==||| INSANE |||==-

Ik wil ook een table row aangeleverd zien voor de grote tabel met systemen met daarin de info.

[ Voor 3% gewijzigd door Q op 26-09-2012 20:52 ]

Onderstaand mijn bescheiden servertje, zal later foto’s en screenshot toevoegen

| System specifications | |

| Component | Value |

|---|---|

| Case | Yeong Yang YY-0420 |

| CPU | Intel Xeon E3-1220 |

| RAM | Patriot 32GB DDR3 |

| Motherboard | Asus P8B WS |

| Operating system | VmWare ESX |

| Controller | IMB Serverrair M1015 IT-flashed |

| Hard drive ESX Vm Storage | 2x 750GB Seagate |

| Hard drive ESX Backup (Timemachine) | 2x 1.5TB Western Digital Green |

| Hard drive Storage (OpenIndiana+nappit | 8x 3TB Seagate |

| RAID array configuration | RaidZ2 |

| Netto storage capacity | 22.5TB |

| Network | Standaard gigabit |

| UPS | Nog niet |

| Filesystem | ZFS |

| Idle power usage | |

| Extra | |

Je opmerkingen heb ik ter harte genomen. Om het overzichtelijk te houden heb ik mijn eerdere post aangepast. Kabelmanagement is hierdoor ook sterkt verbeterd.

Nieuw server systeem staat hier in bestelling, over aantal weken foto's en benchmarks ed.

Even snel de specs :

Dell PowerEdge T620 server. (gekozen doordat Dell gewoon koeling en geluidsniveau prima in orde heeft, en leuke extra opties zoals drac en goede raid controller)

Intel E5-2620

2GB memory

Perc H710P raid controller

En daar komen de volgende uitbreidingen op :

6*3TB WD Red harddisk in raid6 (1 drive al binnen, de andere 5 staan al bijna 2 maanden in backorder)

1*Intel 520 180GB als cachecade drive (read cache voor de raid6)

3*Intel 520 180GB in raid5 als os drive en opslag voor vm's

16GB memory

dell hotswap caddy's (vanaf ebay)

Ik twijfel nog even over wat ik exact met de Intel drives ga doen mbt overprovision.

Ik denk erover om ze als 150GB drives in te zetten. (even onder voorbehoud dat het gaat lukken icm met de hw raid controller)

Ik wilde eerst 2 drives in raid1 draaien, maar ik zit dan toch beetje krap met ruimte.

Is een upgrade van m'n huidge Dell T300 server met 4*1TB in raid5.

OS wordt centos 6 met qemu/kvm als virtualisatie (voor paar vm's waarop ik bijvoorbeeld mailserver en windows remotedesktop pc draai)

Even snel de specs :

Dell PowerEdge T620 server. (gekozen doordat Dell gewoon koeling en geluidsniveau prima in orde heeft, en leuke extra opties zoals drac en goede raid controller)

Intel E5-2620

2GB memory

Perc H710P raid controller

En daar komen de volgende uitbreidingen op :

6*3TB WD Red harddisk in raid6 (1 drive al binnen, de andere 5 staan al bijna 2 maanden in backorder)

1*Intel 520 180GB als cachecade drive (read cache voor de raid6)

3*Intel 520 180GB in raid5 als os drive en opslag voor vm's

16GB memory

dell hotswap caddy's (vanaf ebay)

Ik twijfel nog even over wat ik exact met de Intel drives ga doen mbt overprovision.

Ik denk erover om ze als 150GB drives in te zetten. (even onder voorbehoud dat het gaat lukken icm met de hw raid controller)

Ik wilde eerst 2 drives in raid1 draaien, maar ik zit dan toch beetje krap met ruimte.

Is een upgrade van m'n huidge Dell T300 server met 4*1TB in raid5.

OS wordt centos 6 met qemu/kvm als virtualisatie (voor paar vm's waarop ik bijvoorbeeld mailserver en windows remotedesktop pc draai)

[ Voor 5% gewijzigd door DDX op 27-09-2012 22:00 ]

6 x 3TB in Raid 6 maakt waarschijnlijk iets meer als 10TB aan storage ruimte, maar wat ik niet uit je post kan opmaken is hoe je die gaat aanbieden als storage.

Hoe bedoel je aanbieden ?

Zal idd raid6 zijn en dus iets van 11TB ruimte zijn, zal xfs partitie worden die ik ga gebruiken als opslag. (waarvan aantal TB voor dreambox waarbij hd opnames best wel veel ruimte innemen)

Eventueel kan ik er later nog 2 drives bij hangen om de raid uit te breiden. (blijven 2 drive bays over)

Zal idd raid6 zijn en dus iets van 11TB ruimte zijn, zal xfs partitie worden die ik ga gebruiken als opslag. (waarvan aantal TB voor dreambox waarbij hd opnames best wel veel ruimte innemen)

Eventueel kan ik er later nog 2 drives bij hangen om de raid uit te breiden. (blijven 2 drive bays over)

[ Voor 19% gewijzigd door DDX op 27-09-2012 22:13 ]

wordt die eerste post nog eens qua lijst bijgewerkt?

Artificial Intelligence is no match for natural stupidity | Mijn DVD's | Mijn Games | D2X account: Hakker9

ervaring m.b.t. vermelding mijn systeem, wanneer je een nu nog actieve TS mailt welHakker schreef op vrijdag 28 september 2012 @ 20:23:

wordt die eerste post nog eens qua lijst bijgewerkt?

Zonder het frontje :

Server staat nu nog naast z'n oudere broertje op de grond, maar hij zal vanavond omgewisseld worden :

En uiteraard nog even foto's van de binnenkant :

En genoeg uitbreidingsmogelijkheden :

| System specifications | |

| Component | Value |

|---|---|

| Case | Dell PowerEdge T620 |

| CPU | Intel E5-2620 |

| RAM | 32GB (2x 16GB 1333Mhz DDR3) |

| Motherboard | Iets met Intel C600 chipset van Dell |

| Operating system | CentOS 6 |

| Controller | Dell Perc H710P (1GB cache) |

| Hard drive | 4 x Intel 520 SSD 180GB (ingesteld op 140GB) |

| RAID array configuration | 3 disken in RAID 5 |

| Hard drive | 6 x WD Red 3TB |

| RAID array configuration | 6 disken in RAID 6 + 1 SSD als read cache |

| Netto storage capacity | 12.3TB |

| Network | Standaard gigabit |

| UPS | APC Back-UPS RS 1500 |

| Filesystem | xfs |

| Idle power usage | 56W als wd's in spindown zijn, anders 84W |

code:

1

2

3

4

5

6

7

8

9

10

11

| [root@t620 ~]# df -h

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/vg_t620--1-lv_root

9.9G 1.9G 7.6G 20% /

tmpfs 16G 0 16G 0% /dev/shm

/dev/sda2 485M 63M 397M 14% /boot

/dev/sda1 200M 268K 200M 1% /boot/efi

/dev/mapper/vg_t620--2-lv_raid

11T 2.5T 8.5T 23% /raid

/dev/mapper/vg_t620--1-lv_ssdraid

270G 99G 171G 37% /ssdraid |

Bonnie++ benchmark van de Raid5 met 3 SSD's :

code:

1

2

3

4

5

6

7

8

9

10

| Version 1.96 ------Sequential Output------ --Sequential Input- --Random-

Concurrency 1 -Per Chr- --Block-- -Rewrite- -Per Chr- --Block-- --Seeks--

Machine Size K/sec %CP K/sec %CP K/sec %CP K/sec %CP K/sec %CP /sec %CP

t620.a2000.nu 63G 1213 99 564403 39 281986 29 3151 99 883785 39 1877 119

Latency 9884us 127ms 118ms 4968us 23803us 4729us

Version 1.96 ------Sequential Create------ --------Random Create--------

t620.a2000.nu -Create-- --Read--- -Delete-- -Create-- --Read--- -Delete--

files /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP

16 +++++ +++ +++++ +++ +++++ +++ +++++ +++ +++++ +++ +++++ +++

Latency 1290us 191us 130us 105us 23us 72us |

Bonnie++ benchmark van de Raid6 met 6 WD's:

code:

1

2

3

4

5

6

7

8

9

10

| Version 1.96 ------Sequential Output------ --Sequential Input- --Random-

Concurrency 1 -Per Chr- --Block-- -Rewrite- -Per Chr- --Block-- --Seeks--

Machine Size K/sec %CP K/sec %CP K/sec %CP K/sec %CP K/sec %CP /sec %CP

t620.a2000.nu 63G 1202 98 540955 36 228018 23 2800 87 588798 29 392.2 26

Latency 11232us 30778us 138ms 60239us 73707us 96330us

Version 1.96 ------Sequential Create------ --------Random Create--------

t620.a2000.nu -Create-- --Read--- -Delete-- -Create-- --Read--- -Delete--

files /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP

16 6034 13 +++++ +++ +++++ +++ +++++ +++ +++++ +++ +++++ +++

Latency 1864ms 92us 134us 81us 20us 75us |

Waarom een Dell oplossing :

-stil

De oude Dell poweredge T300 hoorde je niet meer als deur dicht was, de T620 zou zelfs naast m'n bed kunnen staan, zitten 2 fans in die 500-1000 RPM draaien

Voor m'n T300 heb ik aantal zelfbouw servers gehad maar dat waren ongeveer vliegtuigen die je in kamer ernaast nog duidelijk hoorde.

-idrac7

eigen netwerk poort met remote console/virtual media

-management software

dell openmanage waarmee je alles kan uitlezen, inclusief raid status ed

-perc h710p raid controller

goede hw raid controller

-5 jaar garantie

De t300 heb ik nu ook ruim 5 jaar gehad, was ik met deze server ook weer van plan

En omdat budget niet oneindig is, via ebay drive caddy's besteld en disken niet via dell.

Systeem draait Centos 6, op de ssd raid draaien een aantal vm's (via qemu/kvm) zoals bijvoorbeeld mailserver.

Ik heb nog even ruzie met spindown van de hd's ivm xfs filesystem wat ongeveer continu aangesproken wordt.

(oorzaak http://old.nabble.com/xfs...n-down-td30523706i20.html)

Probleem met spindown is opgelost door te upgraden naar nieuwere kernel.

En om toch nog centos 'supported' te blijven heb ik kernel-nl (steeds de nieuwste 3.0.x kernel) repo in gebruik van http://elrepo.org/tiki/kernel-ml

En om toch nog centos 'supported' te blijven heb ik kernel-nl (steeds de nieuwste 3.0.x kernel) repo in gebruik van http://elrepo.org/tiki/kernel-ml

Dit zal hier wel een simpele vraag zijn. Maar ik zit er al een tijdje mee en vind geen bevredigend antwoord.

Welke raidcontroller moet ik nou nemen die:

- onder windows 7/ windows server 2012 draait.

- spindown van de Hdd's doet maar dan wel goed, dus elke schijf onafhankelijk (ik gebruik geen raid).

- niet te duur

Ik heb ooit een highpoint gehad, deze zou spindown ondersteunen en deed dit ook wel, alleen gingen alle schijven aan en uit die er aan hingen. Ik wil dus graag dat elke schijf onafhankelijk van elkaar aan gaan, ik gebruik niet altijd alle schijven.

Welke raidcontroller moet ik nou nemen die:

- onder windows 7/ windows server 2012 draait.

- spindown van de Hdd's doet maar dan wel goed, dus elke schijf onafhankelijk (ik gebruik geen raid).

- niet te duur

Ik heb ooit een highpoint gehad, deze zou spindown ondersteunen en deed dit ook wel, alleen gingen alle schijven aan en uit die er aan hingen. Ik wil dus graag dat elke schijf onafhankelijk van elkaar aan gaan, ik gebruik niet altijd alle schijven.

Ik ben ook Anno007

gisteravond viel mijn 10+TB fileserver uit. Brandlucht en bij uit en weer aanschakelen bleek er rook uit de sata backplane (natuurlijk de meest lastig te bereiken onderste) te komen. Schade zoals op de foto,

Hopelijk is de array nog in tact maar dat weet ik pas nadat ik een vervangende backplane heb...

Hopelijk is de array nog in tact maar dat weet ik pas nadat ik een vervangende backplane heb...

Oei dat ziet er serieus niet goed uit

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Waarom zou je een raidcontroller gebruiken als je geen RAID draait? Puur om de extra aansluitingen?Alexander006 schreef op zaterdag 27 oktober 2012 @ 13:41:

Dit zal hier wel een simpele vraag zijn. Maar ik zit er al een tijdje mee en vind geen bevredigend antwoord.

Welke raidcontroller moet ik nou nemen die:

- onder windows 7/ windows server 2012 draait.

- spindown van de Hdd's doet maar dan wel goed, dus elke schijf onafhankelijk (ik gebruik geen raid).

- niet te duur

Ik heb ooit een highpoint gehad, deze zou spindown ondersteunen en deed dit ook wel, alleen gingen alle schijven aan en uit die er aan hingen. Ik wil dus graag dat elke schijf onafhankelijk van elkaar aan gaan, ik gebruik niet altijd alle schijven.

Dat is niet best..Was het een voltage regulator ofzo die stuk is gegaan? Anders ook ff checken of je voeding ook nog oke is..BartNL schreef op zaterdag 27 oktober 2012 @ 15:21:

gisteravond viel mijn 10+TB fileserver uit. Brandlucht en bij uit en weer aanschakelen bleek er rook uit de sata backplane (natuurlijk de meest lastig te bereiken onderste) te komen. Schade zoals op de foto,

[afbeelding]

Hopelijk is de array nog in tact maar dat weet ik pas nadat ik een vervangende backplane heb...

dat is wat ik dacht toen ik de backplane zag en smd condensatortje heeft inderdaad serieus in de fik gestaan.

er zit een Seasonic X-660 in die via 4-pins molex rechtstreeks op de zes backplanes is aangesloten. Computer lijkt nog op te starten dus ik hoop dat de voeding nog ok is. Zo niet dan heb daarvoor nog wel een backup liggen.Mr_gadget schreef op zaterdag 27 oktober 2012 @ 15:28:

[...]Dat is niet best..Was het een voltage regulator ofzo die stuk is gegaan? Anders ook ff checken of je voeding ook nog oke is..

Op zich is uitval van een backplane en daarmee 4 schijven wel een uitdaging voor mijn raid-6 setup. Ik hoop dat het meevalt

[quote]Mr_gadget schreef op zaterdag 27 oktober 2012 @ 15:28:

[...]

Waarom zou je een raidcontroller gebruiken als je geen RAID draait? Puur om de extra aansluitingen?

Ja alleen voor de extra aansluitingen. Ik ben in 2006 begonnen met mijn eigen pc's te bouwen en ik heb nog nooit 1 schijf kapot gehad. Ik zie geen reden om een moeilijke configuratie te bouwen als het simpel kan...

[...]

Waarom zou je een raidcontroller gebruiken als je geen RAID draait? Puur om de extra aansluitingen?

Ja alleen voor de extra aansluitingen. Ik ben in 2006 begonnen met mijn eigen pc's te bouwen en ik heb nog nooit 1 schijf kapot gehad. Ik zie geen reden om een moeilijke configuratie te bouwen als het simpel kan...

Ik ben ook Anno007

Fuck, de nachtmerrie van iedere storage fetisjist. Hoop dat de disks nog leven. Op de backplane zitten er wel meer dan 2 dus hopen dat je er niet meer dan 2 kwijt bent, liefst niets.

Heb ook meegemaakt dat ik een electronica brandlucht rook. Dat bleek de voeding te zijn van mijn 18 TB NAS. Horror.

Bewijst maar weer dat als je dikke storage wil je eigenlijk twee losse machines met replicatie nodig hebt, hardware gaat stuk. Maar dat is dus de trade-off. Dat wordt onbetaalbaar voor thuis.

Volgens mij heeft slechts 1 persoon of hooguit 2 mensen in de lijst van dit topic een dubbele setup.

Ik droom om ooit iets van een 128 TB setup te bouwen. Geen idee wat ik met zoveel storage moet. Misschien voor 4K content.

Maar dat zou dan op basis van een server of 3 worden, waarbij ik iets met clustering zou doen, zodat ik een server kan verliezen en toch de data in leven kan houden. Dat zou de ultieme build zijn. Maar of dat ooit betaalbaar wordt. Wordt een projectje van 10K+ en dat wordt me teveel.

Heb ook meegemaakt dat ik een electronica brandlucht rook. Dat bleek de voeding te zijn van mijn 18 TB NAS. Horror.

Bewijst maar weer dat als je dikke storage wil je eigenlijk twee losse machines met replicatie nodig hebt, hardware gaat stuk. Maar dat is dus de trade-off. Dat wordt onbetaalbaar voor thuis.

Volgens mij heeft slechts 1 persoon of hooguit 2 mensen in de lijst van dit topic een dubbele setup.

Ik droom om ooit iets van een 128 TB setup te bouwen. Geen idee wat ik met zoveel storage moet. Misschien voor 4K content.

Maar dat zou dan op basis van een server of 3 worden, waarbij ik iets met clustering zou doen, zodat ik een server kan verliezen en toch de data in leven kan houden. Dat zou de ultieme build zijn. Maar of dat ooit betaalbaar wordt. Wordt een projectje van 10K+ en dat wordt me teveel.

[ Voor 34% gewijzigd door Q op 27-10-2012 22:15 ]

Holy ^%$&^$BartNL schreef op zaterdag 27 oktober 2012 @ 15:21:

gisteravond viel mijn 10+TB fileserver uit. Brandlucht en bij uit en weer aanschakelen bleek er rook uit de sata backplane (natuurlijk de meest lastig te bereiken onderste) te komen. Schade zoals op de foto,

[afbeelding]

Hopelijk is de array nog in tact maar dat weet ik pas nadat ik een vervangende backplane heb...

Overtemp?

Wtf..

They call her... c*ck juggeling Thunderc*nt!

Verwijderd schreef op dinsdag 25 september 2012 @ 10:57:

[...]

Je wilt géén Molex gebruiken omdat die 4-polige stekkers regelmatig slecht/niet contact maken. Dit kan dan zorgen voor twee schijven die plots even geen stroom krijgen. Hier kun je vrij ernstige problemen mee krijgen door tijdens gebruik je array de failen of degraden. Later moet je dan weer rebuilden wat een eeuwigheid duurt.

Je wilt liever alleen SATA stekkers gebruiken, en dan in het bijzonder deze:

pricewatch: Silverstone SST-CP06 4x SATA

[...]

Ik kan dit inderdaad beamen. Zeker na verloop van tijd kun je problemen gaan krijgen.

Als je geen BBU hebt moet je je Areca instellen als Write-Through en níet als Write-Back. Areca is één van de weinige controllers die je onveilig laat draaien dus Write-Back inschakelen zonder BBU. Andere controllers verbieden dat, omdat het je data kan corrumperen in geval van onverwacht stroomverlies. De data in de RAM van de controller ben je dan kwijt, inclusief de metadata waar het allemaal om draait.

They call her... c*ck juggeling Thunderc*nt!

Ik geloof niet dat het aan de molex stekkers ligt en denk eerder aan een productiefout / slechte soldeerverbinding op de Norco backplane. Of de array nog ok is weet ik niet en weet ook niet of de array op moment van falen nog data aan het schrijven was. Ik draai wel met een BBU en 4GB cache maar de backplane maakt denk ik sluiting. Meer algemeen lijken de Areca controller raid arrays wel redelijk hufterproof.

Kan momenteel niet meer doen dan afwachten en hopen dat het meevalt.

Kan momenteel niet meer doen dan afwachten en hopen dat het meevalt.

@Bart: Kan je voor de zekerheid beter niet de backplane gebruiken en met een 3ware kabeltje vanaf de RAID controller direct naar de schijven gaan en met een "niet live" schijf de backplane eens rustig testen?

Sterkte... !

Sterkte... !

Dat zou kunnen heb in mijn PC waarop ik dit typ een IBM1015 die via dergelijke kabeltjes werkt. Paar dagen downtime is hier vervelend maar niet direct een ramp.

De backplane heeft nu sluiting tussen 12V en COM (paar Ohm) dus is m.i. testen niet zinnig d.w.z. ik verwacht dat dit de reden van uitval is en de PSU in de fileserver daarom afgeschakeld heeft. Als ik ter test een andere PSU aan deze backplane hang weet ik dat ik die PSU dan zo ongeveer kortsluit en dat doe ik liever niet.

De backplane heeft nu sluiting tussen 12V en COM (paar Ohm) dus is m.i. testen niet zinnig d.w.z. ik verwacht dat dit de reden van uitval is en de PSU in de fileserver daarom afgeschakeld heeft. Als ik ter test een andere PSU aan deze backplane hang weet ik dat ik die PSU dan zo ongeveer kortsluit en dat doe ik liever niet.

vandaag de nieuwe backplane ontvangen en er lijken geen disks defect.

Wel zijn er twee schijven uit de raidset gevallen. Vreemd genoeg zaten deze beide schijven niet op de defecte backplane. Zijn dan denk ik door de kortsluiting en daarop volgende accute uitval van de 12V uit de array gevallen.

Array staat nu te rebuilden dus ik hoop nu dat ik met de schrik vrij kom.

edit: vanmorgen na zo'n 10 uur rebuilden was de array hersteld en data dus gelukkig niet kwijt. Heb wel een volumecheck gestart om zeker te zijn dat de parity data nog klopt. Dat lijkt ook zo'n 10 uur te gaan duren en dan is morgen de boel weer hersteld

Wel zijn er twee schijven uit de raidset gevallen. Vreemd genoeg zaten deze beide schijven niet op de defecte backplane. Zijn dan denk ik door de kortsluiting en daarop volgende accute uitval van de 12V uit de array gevallen.

Array staat nu te rebuilden dus ik hoop nu dat ik met de schrik vrij kom.

edit: vanmorgen na zo'n 10 uur rebuilden was de array hersteld en data dus gelukkig niet kwijt. Heb wel een volumecheck gestart om zeker te zijn dat de parity data nog klopt. Dat lijkt ook zo'n 10 uur te gaan duren en dan is morgen de boel weer hersteld

[ Voor 25% gewijzigd door BartNL op 01-11-2012 19:26 ]

Damn... Is je systeem meteen getest

They call her... c*ck juggeling Thunderc*nt!

| System specifications | |

| Component | Value |

|---|---|

| Case | Antec Twelve Hundred |

| Power | Cooler Master GX750 |

| CPU | Intel Core i5 3450 |

| RAM | 16GB (2x 8GB Kingston 1600Mhz DDR3) |

| Motherboard | ASrock Extreme 4 |

| Operating system | VMWare ESXi 5.1 |

| Controller | Areca ARC1882IX-16 20port + BBU |

| Hard drive | Samsung 830series 128GB |

| RAID array configuration | 12 disken in RAID 6 |

| Hard drives | 12 x WD Red 3TB |

| Netto storage capacity | ~30TB |

| Network | Intel Gigabit kaart |

| Filesystem | NTFS |

| Idle power usage | niet boeiend |

De machine is voornamelijk bedoeld voor storage van blurays en andere media. Verder de usual suspects die hierop draaien, Sabnzb, sickbeard, Logitech Squeezebox server etc.

Alles is gebaseerd op ESXi. Alle VM OS'n staan op de SSD, de SSD zit direct aan de SATA600 controller op het mainboard. Ik gebruik geen molex kabels, alles via SATA powerkabels/silverstone splitters.

Binnen ESXi draai ik een 64bit Win7 VM. Dit is een dedicated fileserver en deze is zo kaal mogelijk en blijft ook zo. Het enige wat deze VM doet is media delen op m'n netwerk. De areca kaart staat in pass-through in VMware en geef ik door aan de Win7 VM voor exclusieve toegang. Behalve een Win7 VM draai ik een ubuntu desktop VM, dit gebruik ik voor Sabnzb, sickbeard en alles wat met downloaden te maken heeft. Er komt nog een Win8 VM bij binnenkort, gewoon omdat het kan.

Verder zal ik binnenkort ook nog een VPN concentrator / FW gaan draaien maar dat komt nog wel.

Heeft even paar dagen gekost maar alles lijkt te werken. Aanvankelijk begonnen met een Asus moederbord uit de P8Z77 series maar bleek dat die geen VT-d ondersteund dus moeten switchen naar een ASrock die dat gewoon netjes ondersteund.

Er staat nog geen data op de server (dit staat voorlopig nog op m'n oude netgear NAS) Eerst maar eens verder testen en tunen, met name de areca kaart wil ik nog even goed naar kijken. De rest is redelijk vanzelfsprekend. De oude NAS zal waarschijnlijk blijven fungeren als backup voor kritische data, ook op een andere plek in huis..

Dat is wel echt een dikke machine. Menig MKB systeembeheerder zal er jaloers op zijn, laat staan de gemiddelde tweakerDDX schreef op zondag 21 oktober 2012 @ 13:42:

[afbeelding]

Zonder het frontje :

[afbeelding]

Server staat nu nog naast z'n oudere broertje op de grond, maar hij zal vanavond omgewisseld worden :

[afbeelding]

En uiteraard nog even foto's van de binnenkant :

[afbeelding]

Gebruik je deze machine ook voor werkdoelenden of alleen media?

Enkel voor thuisserver gebruik.

Gewoon alles op 1 stabiele en extreem stille server.

Was eerst van plan om de t320 te kopen, maar die kan maximaal 8 drives aan.

En aangezien ik vm's op ssd wilde draaien, kwam ik toen automatisch op de t620 uit. (maximaal 12 drives)

In de t320 had ik ook nog wel wat extra drives kunnen hangen, maar dan had ik de ssd drives op extra controller (of moederbord sata) moeten hangen.

T620 was uiteindelijk 100 euro duurder dan de T320 dus makkelijke keus.

Vm's is vooral de mailserver voor hele familie belangrijk.

Daarnaast nog vm die ik zelf gebruik als windows remotedesktop machine en waar scan software op draait.

Merendeel van de dag staat server gewoon lekker te idlen op 1200mhz en alle sata 3tb disken in spindown.

Gewoon alles op 1 stabiele en extreem stille server.

Was eerst van plan om de t320 te kopen, maar die kan maximaal 8 drives aan.

En aangezien ik vm's op ssd wilde draaien, kwam ik toen automatisch op de t620 uit. (maximaal 12 drives)

In de t320 had ik ook nog wel wat extra drives kunnen hangen, maar dan had ik de ssd drives op extra controller (of moederbord sata) moeten hangen.

T620 was uiteindelijk 100 euro duurder dan de T320 dus makkelijke keus.

Vm's is vooral de mailserver voor hele familie belangrijk.

Daarnaast nog vm die ik zelf gebruik als windows remotedesktop machine en waar scan software op draait.

Merendeel van de dag staat server gewoon lekker te idlen op 1200mhz en alle sata 3tb disken in spindown.

[ Voor 7% gewijzigd door DDX op 08-11-2012 21:56 ]

Gisteren de laatste hand gelegd aan het kabel managemant build is geinspireerd op de storage server van tbusquet

| System specifications | |

| Component | Value |

|---|---|

| Case | Antec 1200 |

| CPU | AMD Athlon II X2 260 |

| RAM | 8 GB |

| Motherboard | Gigabyte GA-MA790FXT-UD5P |

| Operating system | Nas4Free |

| Controller | Supermicro AOC-USAS2-L8E |

| Hard drive | 2 x Samsung EcoGreen F3 2TB |

| Hard drive | 2 x WD20EADS, 2TB |

| Hard drive | 2 x WD20EARS, 2TB |

| Hard drive | 4 x WD20EARX, 2TB |

| RAID array configuration | 2 x 8TB raidz 1 x 4TB Stripe ( 16 TB storage ) |

| Netto storage capacity | 16 TB |

| Network | Realtek Gigabit 2x |

| UPS | N/A |

| Filesystem | ZFS |

| Idle power usage | Onbekend |

| Extra | - |

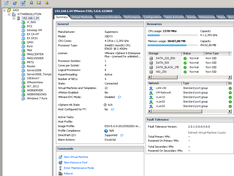

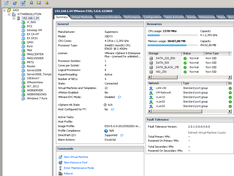

Hierbij dan mijn systeem tot nu toe:

De Server wordt gebruikt als virtualisatie host en dient dus ook als NAS.

Disken worden doorgegeven aan VMWare via RDM

4 Disken zijn voor VMWare 2tal Rechtstreeks (1TB en 500GB) en 250GB 320GB zijn ISCSI via Server2008 NAS

| System specifications | |

| Component | Value |

|---|---|

| Case | Norco RPC-4220 |

| CPU | Intel Xeon E5620 Boxed |

| RAM | 48 GB, 6x8GB DDR3 EEC |

| Motherboard | Supermicro X8DT3-LN4F |

| Operating system | VMWare ESXi 5.0.0 |

| Controller | IBM ServeRaid M1015 (IT), SuperMicro onboard SAS, SuperMicro onboard SATA |

| Hard drive | 4x Hitachi Deskstar 7K1000.C, 500GB |

| Hard drive | 6x Samsung Spinpoint F3 HD103SJ, 1TB |

| Hard drive | 10x Western Digital Black WD1002FAEX, 1TB |

| RAID array configuration | Geen Raid RDM naar Server2008 als NAS |

| Netto storage capacity | 18 TB |

| Network | 4x onboard Intel Gigabit |

| UPS | APC Back-ups RS 1500 |

| Idle power usage | 170-180 Watt met vm's die draaien |

De Server wordt gebruikt als virtualisatie host en dient dus ook als NAS.

Disken worden doorgegeven aan VMWare via RDM

4 Disken zijn voor VMWare 2tal Rechtstreeks (1TB en 500GB) en 250GB 320GB zijn ISCSI via Server2008 NAS

ICTWebSolution - Wi-Fi Problemen? Stuur maar een berichtje! - Wi-Fi Bereik verbeteren?

Even een update. Na veel wikken en wegen toch maar weer voor een houten server gegaan.

Hier de nieuwe build :

Hier de nieuwe build :

[ Voor 23% gewijzigd door Audiodude op 01-12-2012 12:44 ]

Heeft die houten server eigenlijk wel voordelen? Waarom zou je voor een zelfbouw gaan?Antoniya001 schreef op zaterdag 01 december 2012 @ 12:36:

Even een update. Na veel wikken en wegen toch maar weer voor een houten server gegaan.

Heb er zelf ook al verschillende keren over getwijfeld

leuker, meestal goedkoper, aan je eigen wensen aan te passen. Kan Stiller

Al moet ik zeggen dat je met "maar" 8 disken wel heel wat meer keuze hebt in of the shelf systemen, dan als je er 15 in wilt

leuker, meestal goedkoper, aan je eigen wensen aan te passen. Kan Stiller

Al moet ik zeggen dat je met "maar" 8 disken wel heel wat meer keuze hebt in of the shelf systemen, dan als je er 15 in wilt

Heuveltjes CPU geschiedenis door de jaren heen : AMD 486dx4 100, Cyrix PR166+, Intel P233MMX, Intel Celeron 366Mhz, AMD K6-450, AMD duron 600, AMD Thunderbird 1200mhz, AMD Athlon 64 x2 5600, AMD Phenom X3 720, Intel i5 4460, AMD Ryzen 5 3600 5800x3d

| System specifications | |

| Component | Value |

|---|---|

| Case | Fractal Design ARC midi |

| CPU | AMD A6 3500 2.1ghz triple core |

| RAM | Corsair 16gb kit 2x8gb 1333mhz |

| Motherboard | Asus F1A75-M |

| Operating system | ZFSguru |

| Controller | IBM M1015 it mode |

| Hard drive | 6x 3tb seagate 7200rpm |

| Hard drive | 2x 500gb samsung 7200rpm |

| Hard drive | 128gb samsung 830 ssd |

| RAID array configuration | 6x3tb raidz2 + 128gb L2arc |

| RAID array configuration | 2x500gb zfs mirror boot/torrent |

| Netto storage capacity | 12tb |

| Network | HP N364T Quad gbit nic LACP |

| UPS | MGE evolution 1550 |

| Filesystem | ZFS |

| Idle power usage | 110watt idle zonder spindown. |

| Extra | 15euro Lackrack |

De NAS is voor mijn centrale opslag van films muziek en mijn full hd materiaal van mijn sony cybershot 1uur is 12gb

Backups maak ik op een 2tb wd mybook live en een 4tb hitachi usb disk.

Ik heb een videoserie over de server gemaakt waar veell info in staat + in beschrijving van de filmpjes staat nog meer info

Hardware build!

Lackrack Power Benchmarks NAS4Free

12TB update, ZFSguru, indepth power, UPS, benchmarks

[ Voor 3% gewijzigd door victorb op 05-01-2013 21:18 ]

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Leuk gedaan! Wel jammer dat je server zoveel verbruikt, ik vind 110W persoonlijk best veel.

Ik zit met 10 disks lager (~80-90W). Maar ik heb dan ook 5400RPM schijven, dat scheelt nogal.

Ik zit met 10 disks lager (~80-90W). Maar ik heb dan ook 5400RPM schijven, dat scheelt nogal.

Even niets...

ThanxFireDrunk schreef op zaterdag 05 januari 2013 @ 21:34:

Wel jammer dat je server zoveel verbruikt,

Ik heb vanavond in het DIY server topic het overzicht gezet van het verbruik per onderdeel. Past beter in dat topic.

NAS Server build http://www.youtube.com/watch?v=kBYMVUNrvDY 3DFX Voodoo2 Sli Build introductie http://www.youtube.com/watch?v=5PAIUJCJHGM

Waarom heb je je voeding niet met de fan naar beneden gericht ? dan trekt ie koele (gefilterde) lucht van buiten de kast.

Hierbij mijn systeempje:

Wordt vooral gebruik als opslag van media/downloadbak.

Vind op dit moment de idle power usage nog erg hoog waardoor ik besloten heb om hem bij geen gebruik in slaapstand te laten gaan.

Wil mogelijk wel investeren om dit systeem optimaler(vooral zuiniger) te krijgen, dus alle tips zijn welkom

| System specifications | |

| Component | Value |

|---|---|

| Case | Cooler Master Elite 334 |

| Power | Cooler Master Real Power M520 |

| CPU | AMD Sempron 140 Boxed |

| RAM | 4GB (2x 2 GB Kingston DDR2-800) |

| Motherboard | MSI 785GTM-E45 |

| Operating system | Windows XP 32bit |

| Controller | Adaptec AAR-1430SA |

| Hard drive | 2x Samsung EcoGreen F2 EG HD154UI, 1.5TB |

| Hard drive | 4x Samsung EcoGreen F3, 2TB |

| Hard drive | 3x Samsung Spinpoint F4 EG HD204UI, 2TB |

| Hard drive | 1x Seagate Barracuda 7200.14 ST3000DM001, 3TB |

| RAID array configuration | JBOD |

| Netto storage capacity | +/- 20TB |

| Network | Realtek Gigabit |

| Filesystem | NTFS |

| Idle power usage | +/- 100w |

Wordt vooral gebruik als opslag van media/downloadbak.

Vind op dit moment de idle power usage nog erg hoog waardoor ik besloten heb om hem bij geen gebruik in slaapstand te laten gaan.

Wil mogelijk wel investeren om dit systeem optimaler(vooral zuiniger) te krijgen, dus alle tips zijn welkom

Volgens mij voldoe je niet aan punt 5:

Toepassing van redundancy, het systeem moet falen van minimaal 1 storage disk kunnen overleven.

There is no place like 127.0.0.1

klopt, maar ik vind persoonlijk media/downloads niet echt raidwaardig  (tevens heb ik niet meer ruimte in m'n kast)

(tevens heb ik niet meer ruimte in m'n kast)

1. Schijvenslayerrp schreef op zondag 13 januari 2013 @ 08:51:

Wil mogelijk wel investeren om dit systeem optimaler(vooral zuiniger) te krijgen, dus alle tips zijn welkom

Ik heb momenteel een systeem met Core i5 en Radeon HD5450 (geen Video onboard). Daarnaast 1x SSD, 1x 2,5inch 7200RPM schijf en 8x3TB WD Green WD30EZRX. Er zat ook voorheen een Samsung F1 1TB 7200RPM in.

Met spindown gebruike dit systeem in spindown 55watt. Maar wilde geen spin down niet meer om verschillende redenen.

Met 1x SSD, 1x 2,5inch 7200RPM schijf en 7x3TB WD Green WD30EZRX en 1x Samsung F1 1TB 7200RPM gebruike het systeem zonder spindown in idle 95watt.

Ik heb toen de F1 vervangen door een WD30EZRX waardoro het totaal hiervan op 8 schijven kwam en het systeem gebruikte zonder spindown in idle nog maar 84watt. Een heel groot verschil dus door het vervangen van 1 schijf.

2. Power Down.

Mijn server schakels 's avonds / 's nachts automatisch uit nadat de laatste client op het netwerk uitgeschakeld is en schakelt 's ochtends automatisch terug in van zodra de eerst client opstart. Ik merk dus nooit dat mijn server onbereikbaar is, maar deze verbruikt toch ongeveer 8 uur = 1/3 minder stroom.

[ Voor 15% gewijzigd door timofp op 13-01-2013 12:03 ]

Verwijderd

Mijn nieuwe NAS:

Doel is opslag van foto's muziek, films, documenten.

Performance (Compression = off):

nas4free:/# dd if=/dev/zero of=/mnt/bigpool/data.000 bs=1M count=102400

102400+0 records in

102400+0 records out

107374182400 bytes transferred in 284.575318 secs (377313757 bytes/sec)

nas4free:/# dd of=/dev/null if=/mnt/bigpool/data.000 bs=1M

102400+0 records in

102400+0 records out

107374182400 bytes transferred in 270.121957 secs (397502608 bytes/sec)

Nog te doen:

- LAN configuratie. Beide Intel kaarten met LACP koppelen aan mijn KTI Gigabit switch (met LACP ondersteuning)

- Spindown configuratie

- VirtualBox implementeren

- Backup van belangrijke data naar extern backupsysteem. rsync / ssh?

Ik wil ook wel wat foto's plaatsen maar weet niet hoe die te uploaden

Doel is opslag van foto's muziek, films, documenten.

| System specifications | |

| Component | Value |

|---|---|

| Case | Lian Li PC-A75X |

| Power | Be quiet! Dark Power PRO 10 550W |

| CPU | AMD A8-5500 Boxed |

| RAM | 32GB (2x Kingston ValueRAM KVR13N9K2/16) |

| Motherboard | Gigabyte GA-F2A85X-D3H |

| Operating system | NAS4Free 9.1.0.1 - Sandstorm (revision 573) |

| Controller | IBM M1015 IT |

| Hard drive | Intel 520 60GB SSD as Log (70% OP) |

| Hard drive | Intel 520 240GB SSD as Cache (20% OP) |

| ZFS configuration | 2 RAID-Z2 arrays of 6 disks each |

| Hard drives | 12 x Seagate Barracuda 7200.14 3TB |

| Netto storage capacity | 24TB |

| Network | 2x Intel Gigabit CT Desktop Adapter |

| Filesystem | ZFS |

| Idle power usage | Unknown |

Performance (Compression = off):

nas4free:/# dd if=/dev/zero of=/mnt/bigpool/data.000 bs=1M count=102400

102400+0 records in

102400+0 records out

107374182400 bytes transferred in 284.575318 secs (377313757 bytes/sec)

nas4free:/# dd of=/dev/null if=/mnt/bigpool/data.000 bs=1M

102400+0 records in

102400+0 records out

107374182400 bytes transferred in 270.121957 secs (397502608 bytes/sec)

Nog te doen:

- LAN configuratie. Beide Intel kaarten met LACP koppelen aan mijn KTI Gigabit switch (met LACP ondersteuning)

- Spindown configuratie

- VirtualBox implementeren

- Backup van belangrijke data naar extern backupsysteem. rsync / ssh?

Ik wil ook wel wat foto's plaatsen maar weet niet hoe die te uploaden

Heb je hier wat meer informatie over? Doe je dit met WOL ofzo? Dit is natuurlijk wel interessant...timofp schreef op zondag 13 januari 2013 @ 12:01:

2. Power Down.

Mijn server schakels 's avonds / 's nachts automatisch uit nadat de laatste client op het netwerk uitgeschakeld is en schakelt 's ochtends automatisch terug in van zodra de eerst client opstart. Ik merk dus nooit dat mijn server onbereikbaar is, maar deze verbruikt toch ongeveer 8 uur = 1/3 minder stroom.

Waarom heb je voor de 520 gekozen als LOG en niet voor de 320?Verwijderd schreef op donderdag 17 januari 2013 @ 20:02:

Mijn nieuwe NAS:

Doel is opslag van foto's muziek, films, documenten.

System specifications Component Value Case Lian Li PC-A75X Power Be quiet! Dark Power PRO 10 550W CPU AMD A8-5500 Boxed RAM 32GB (2x Kingston ValueRAM KVR13N9K2/16) Motherboard Gigabyte GA-F2A85X-D3H Operating system NAS4Free 9.1.0.1 - Sandstorm (revision 573) Controller IBM M1015 IT Hard drive Intel 520 60GB SSD as Log (70% OP) Hard drive Intel 520 240GB SSD as Cache (20% OP) ZFS configuration 2 RAID-Z2 arrays of 6 disks each Hard drives 12 x Seagate Barracuda 7200.14 3TB Netto storage capacity 24TB Network 2x Intel Gigabit CT Desktop Adapter Filesystem ZFS Idle power usage Unknown

Performance (Compression = off):

nas4free:/# dd if=/dev/zero of=/mnt/bigpool/data.000 bs=1M count=102400

102400+0 records in

102400+0 records out

107374182400 bytes transferred in 284.575318 secs (377313757 bytes/sec)

nas4free:/# dd of=/dev/null if=/mnt/bigpool/data.000 bs=1M

102400+0 records in

102400+0 records out

107374182400 bytes transferred in 270.121957 secs (397502608 bytes/sec)

Nog te doen:

- LAN configuratie. Beide Intel kaarten met LACP koppelen aan mijn KTI Gigabit switch (met LACP ondersteuning)

- Spindown configuratie

- VirtualBox implementeren

- Backup van belangrijke data naar extern backupsysteem. rsync / ssh?

Ik wil ook wel wat foto's plaatsen maar weet niet hoe die te uploaden

Even niets...

Verwijderd

520: SATA 600 aansluitingFireDrunk schreef op vrijdag 18 januari 2013 @ 09:01:

[...]

Waarom heb je voor de 520 gekozen als LOG en niet voor de 320?

320: SATA 300 aansluiting

Of dat qua performance iets uitmaakt weet ik niet...

FireDrunk vraagt dit ivm de rij condensatoren die op de Intel 320 ssd serie zitten die er voor zorgen dat de ssd nog spanning heeft om de log actie weg te schrijven bij stroom uitval. De 520 serie heeft deze 'uitval' bescherming niet en dit kan tot data gemis/verminking leiden omdat de log niet weggeschreven wordt.Verwijderd schreef op vrijdag 18 januari 2013 @ 10:48:

[...]

520: SATA 600 aansluiting

320: SATA 300 aansluiting

Of dat qua performance iets uitmaakt weet ik niet...

Een ander optie is Mux zijn ssd batterij, maar die forum draad is sinds eind november stil gevallen.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Das mooi maar daar heeft hij 'm dus kennelijk niet om gekozen. Zoals in dat draadje te lezen is hoef je de ssd zelf ook niet van een ups te voorzien wanneer de gehele machine dat al heeft. Dat laatste lijkt mij een beter idee aangezien je ook graag op filesystem niveau dingen netjes weggeschreven wil hebben wanneer de stroom uitvalt

Verwijderd

Een UPS staat nog op mijn lijstje. Ik moet wel nog uitzoeken welke UPS'en ondersteund worden door NAS4Free, zodat bij spanningsuitval na een bepaalde tijd het systeem automatisch down wordt gebracht.ppl schreef op vrijdag 18 januari 2013 @ 22:40:

Das mooi maar daar heeft hij 'm dus kennelijk niet om gekozen. Zoals in dat draadje te lezen is hoef je de ssd zelf ook niet van een ups te voorzien wanneer de gehele machine dat al heeft. Dat laatste lijkt mij een beter idee aangezien je ook graag op filesystem niveau dingen netjes weggeschreven wil hebben wanneer de stroom uitvalt

is meestal wel zo maar wanneer probleem met de spanning bijvoorbeeld door een defecte psu of bedrading in de PC komt werkt een ups niet. Persoonlijk gebruik ik overigens wel een ups en geen intel 520 ssd's.ppl schreef op vrijdag 18 januari 2013 @ 22:40:

Das mooi maar daar heeft hij 'm dus kennelijk niet om gekozen. Zoals in dat draadje te lezen is hoef je de ssd zelf ook niet van een ups te voorzien wanneer de gehele machine dat al heeft. Dat laatste lijkt mij een beter idee aangezien je ook graag op filesystem niveau dingen netjes weggeschreven wil hebben wanneer de stroom uitvalt

Misschien heb je hier al wat aan.Verwijderd schreef op zaterdag 19 januari 2013 @ 13:04:

[...]

Een UPS staat nog op mijn lijstje. Ik moet wel nog uitzoeken welke UPS'en ondersteund worden door NAS4Free, zodat bij spanningsuitval na een bepaalde tijd het systeem automatisch down wordt gebracht.

N4F gebruikt bijkbaar NUT, dus deze lijst zou je ook al een heel eind op weg moeten helpen

Verwijderd

Daar heb je wel gelijk in, maar bij uitval verlies ik alleen de gegevens die op dat moment in de LOG schijf staan. Als er het een en ander defect is, moet ik die componenten vervangen. Dan ben je zo een paar dagen verder (inclusief bestellen en afleveren). Houdt die condensator dat vol?BartNL schreef op zaterdag 19 januari 2013 @ 13:39:

[...]

is meestal wel zo maar wanneer probleem met de spanning bijvoorbeeld door een defecte psu of bedrading in de PC komt werkt een ups niet. Persoonlijk gebruik ik overigens wel een ups en geen intel 520 ssd's.

Overdrijven is ook een vak. Het heeft weinig zin om voor dit soort dingen iets te gaan regelen als er op zoveel andere plekken iets mis kan gaan omdat men hier vooral consumenten hardware gebruikt. En wat dan nog als het mis gaat? Daar zijn nou backups voor uitgevonden. Je kunt je niet overal voor indekken dus ga dat dan ook niet tot in den treurigheid proberen te doen. Zorg liever dat bepaalde zaken afdoende zijn gedekt en dat je backups goed lopen. Vergeet hier niet dat een defecte psu meer raakt dan alleen een ssd. Je sluit het immers ook aan op het moederbord en de overige componenten (hetzij direct, hetzij indirect). Het is net als met blikseminslag: leuk dat je 1 component beveiligd maar als dit op een andere component is aangesloten die niet is beveiligd helpt dat geen ene moer.BartNL schreef op zaterdag 19 januari 2013 @ 13:39:

is meestal wel zo maar wanneer probleem met de spanning bijvoorbeeld door een defecte psu of bedrading in de PC komt werkt een ups niet. Persoonlijk gebruik ik overigens wel een ups en geen intel 520 ssd's.

inderdaad, waarom quote je mij eigenlijkppl schreef op zaterdag 19 januari 2013 @ 16:09:

[...]Overdrijven is ook een vak....

Zo werkt het niet. De condensator zorgt ervoor dat de SSD zijn writes echt af kan maken. Hij blijft dus gewoon even doorwerken. Het is dus niet zo als een BBWC waar de writes inderdaad in RAM blijven staan.Verwijderd schreef op zaterdag 19 januari 2013 @ 14:56:

[...]

Daar heb je wel gelijk in, maar bij uitval verlies ik alleen de gegevens die op dat moment in de LOG schijf staan. Als er het een en ander defect is, moet ik die componenten vervangen. Dan ben je zo een paar dagen verder (inclusief bestellen en afleveren). Houdt die condensator dat vol?

De Intel 320 heeft die feature inderdaad, en maakt een UPS voor je hele systeem niet meer verplicht om data consistentie te houden zoals nodig is als je een SSD gebruikt zonder die feature.

Met de 320 heb je een ZIL die altijd consistent is, waardoor je hooguit een paar seconden asynchrone writes verliest. Je filesystem en de applicatiedata zijn dus altijd consistent.

Even niets...

Je verzon een probleem voor een of andere oplossing zonder goed na te denken over wat dat probleem nou precies inhoudt

Zo'n ups voor een ssd (ingebouwd of extern) is niets meer dan een additionele laag in een totaalplaatje. Het is heel fijn om dit soort zaken te gebruiken bij systemen waarbij data integriteit ontzettend belangrijk is en daarom heeft het ook een hoger prijskaartje. Je moet je afvragen in hoeverre je hier tegenaan loopt en in hoeverre je dit soort features thuis nodig hebt. Maar let wel, als je het invoert dan zul je ook door moeten pakken en over de gehele linie maatregelen uitrollen anders is het een compleet nutteloze feature.

Ik vind het nogal overdreven om dit soort kleine dingen in een thuisbak toe te passen. Het geeft ook een beetje een scheve verhouding: men gebruikt consumer hardware maar gaat dan wel allerlei maatregelen treffen om enterprise functionaliteit te verkrijgen want owee dat er een kansje van weet ik niet hoeveel nanoprocent op dataverlies is. Dan denk je niet goed over dingen na en ben je ook niet echt realistisch. Pak het liever simpeler en vooral realistischer aan: regel gewoon een ups voor het systeem en zorg dat je belangrijke data goed backupt. Als de stroom een keer uitvalt zul je toch het een en ander aan controles moeten uitvoeren. Uiteraard moet je een ups voor je ssd wel gaan doen als het je om de hobby te doen is. Dan kun je het zo idioot maken als je wilt

En dat is nu de crux van het verhaal.ppl schreef op zondag 20 januari 2013 @ 22:38:

[...]

SNIP

Dan kun je het zo idioot maken als je wilt

Als die meid/jongen dat nu graag wilt, laat hem/haar dan toch. Hij/Zij doet er (hopelijk

Afhankelijk van wat de gebruiker belangrijk vind voor zijn/haar data en de budget ruimte (Er is dan wel de gevleugelde uitspraak: "Een hobby mag geld kosten..", maar meestal zijn de centjes niet oneindig) maak je keuzes.

Voor de een is het de sport om zo goedkoop mogelijk een flinke storage oplossing te realiseren en wellicht meer risico te nemen met de data.

De ander wil de data, tot op zekere hoogte, tegen de nodige 'rampen' in dekken en is bereid hiervoor in de buidel te tasten. (Server kast, redundante PSU, UPS, ssd met condensator buffering, hardware RAID kaart met BBU, RAID approved disks, server grade bordje, server CPU, ECC memory,etc)

Maar wat al vaker aangehaald is, belangrijker nog is een goede back-up strategie.

Voor geen van beide storage oplossingen en hun data is het bevorderlijk als het pand waar ze in staan in vlammen op gaat, of met een bezoekje van het dieven gilde vereerd wordt.

( Pantagruel vraagt zich af of een halon blus installatie voor thuis in t server hokje een mogelijkheid is, anyone

Voor de redelijk paranoïden onder ons zal 1 a 2 off-site back-ups van de belangrijkste dingen genoeg zijn (externe hdd bij vriend/familie lid/locker op je werk), maar ook daar mag ieder lekker voor zich zelf beslissen wat belangrijk is.

Voor mijn part vertrouw je het aan de 'cloud' toe, 'Whatever turns you on".

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

| System specifications | |

| Component | Value |

|---|---|

| Case | Fractal Design R4 white |

| CPU | Intel Atom D2700 @ 2.1Ghz D510 @ 1.6GHz |

| RAM | 4 GB |

| Motherboard | Intel D2700MUD D510MO |

| Operating system | Linux gentoo 3.6.11-gentoo #6 SMP Tue Jan 15 15:15:54 CET 2013 x86_64 |

| Controller | Silicon Image sil3132 MiniPCIe (2) |

| Hard drive | 6x WD30EZRX 3TB @raid5 |

| Hard drive | 2x WD20EARS 2TB @raid1 |

| RAID array configuration | 2x 2TB@raid1 6x3TB@raid5 |

| Netto storage capacity | +/- 17TB |

| Network | Intel 82574L Gigabit Ethernet Controller |

| UPS | n/a |

| Filesystem | EXT4 |

| Idle power usage | ~60 Watt |

| Extra | 2x Silicon Image 3726 based port multiplier |

code:

1

2

3

4

5

6

7

8

9

10

| gentoo smeltekw # df -h Filesystem Size Used Avail Use% Mounted on rootfs 92G 5.9G 82G 7% / devtmpfs 2.0G 4.0K 2.0G 1% /dev tmpfs 2.0G 464K 2.0G 1% /run shm 2.0G 0 2.0G 0% /dev/shm cgroup_root 10M 0 10M 0% /sys/fs/cgroup /dev/md1 119M 11M 102M 10% /boot /dev/md4 1.7T 16G 1.6T 1% /mnt/raid1 /dev/md5 14T 3.1T 11T 23% /mnt/raid5 |

code:

1

2

3

4

5

6

7

8

9

10

| gentoo / # cat /etc/fstab /dev/md1 /boot ext4 defaults,noatime 1 2 /dev/md2 none swap sw 0 0 /dev/md3 / ext4 noatime 0 1 UUID="0dd85cab-43d0-40e9-aaa6-8b9e7858cba7" /mnt/raid1 ext4 defaults,noatime 0 2 UUID="f0c97ba0-0716-4d12-901a-2477541d369e" /mnt/raid5 ext4 defaults,noatime 0 2 proc /proc proc defaults 0 0 shm /dev/shm tmpfs nodev,nosuid,noexec 0 0 |

code:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

| gentoo / # cat /etc/lilo.conf

boot=/dev/md1

raid-extra-boot=mbr-only

prompt

timeout=200

default=current

lba32

image=/boot/kernel-current

label=current

read-only

root=/dev/md3

image=/boot/kernel-previous

label=previous

read-only

root=/dev/md3 |

Dit is begonnen als een low-power file servertje voor oa. OpenVPN (site to site) en transmission leechbox. Ondertussen is de storage uitgebreid naar 15TB (12TB Bruikbaar) maar mijn doel is voornamelijk om het zo energie zuinig als mogelijk te houden. Ik heb een mooi workstation bord met 8 poorts PCI-X areca kaart en een intel Q6600 maar dat zuipt nogal. Vandaar de afweging om bij de atom te blijven.

Performance is niet om over naar huis te schrijven maar voldoende voor 802.11n en gigabit. De limitatie zit momenteel in de Silicon Image 3132 chip, die limiteerd de bus op +/- 130MiB/s wat op zich voldoende is. Ik zit te wachten op een MiniPCIe AsMedia kaartje wat naar zeggen beter zal presteren, de verwachting is dan net onder de maximale SATA300 snelheid.. Zeg 250 a 280 MiB/s. Nogmaals, de focus ligt voornamelijk op energie zuinigheid en storage; ik weet dat aan mijn Areca controller in PCI-X de snelheid rond de 500 a 600 MiB/s zal zijn maar dat is momenteel niet belangrijker dan energieverbruik.

Bootable RAID1 array met MDADM zonder initramfs is even knutselen met lilo maar uiteindelijk werkt het. Server is bootable van beide WD20EARS drives zonder initramfs met auto assembly. Zodra de kernel op komt wordt de root, boot en swap partitie ge-assembled.

Ik WIL GEEN initramfs als het niet nodig is. Bij Ubuntu en consorten gaat dit lekker makkelijk maar bij Gentoo is er nog wel wat werk aan de weg qua initramfs. Bovendien wil ik de server zo lean mogelijk draaien. De kernel momenteel:

code:

1

| -rw-r--r-- 1 root root 2.3M Jan 20 20:55 kernel-3.6.11-gentoo |