Nice!

ZFS is (ongeveer) RAID maar dan niet voor de snelheid of het opvangen van uitval van een harde schijf, maar om de betrouwbaarheid van je data beter te waarborgen. Uitval van een (of meer) harde schijven is daar onderdeel van en afhankelijk van je opstelling is het ook sneller dan een enkele schijf.

Met een 2TB-schijf en een 3 TB-schijf in mirror hou je netto 2 TB over, maar ik neem aan dat je dat al wist

Met ZFS kan die opstelling net zo goed en werkt redelijk hetzelfde. De bonus van ZFS is dat het systeem veel meer soorten datacorruptie kan ontdekken dan (bijvoorbeeld) NTFS of Ext3, en in geval van mirroring of RAIDZ/Z2/Z3 ook kan herstellen.

In jouw geval krijg je twee pools. Let op dat je niet je 4 TB schijven als los vdev toevoegt aan de pool met je mirror, want dan kun je opnieuw beginnen. Wat je ook kunt overwegen is je 2 en 3 verkopen en er 4 TB-schijven voor terugkopen, en dan 4 schijven in RAIDZ te zetten. Je hebt dan 12 TB en kunt de uitval van 1 schijf tolereren, in de andere opstelling heb je 10 TB en is er maar 2 TB beschermd tegen uitval van één schijf.

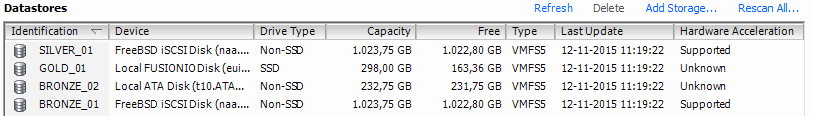

De Fusio IO-kaart is uitstekend geschikt als cache, ik lees berichten in 2014 dat het niet supported zou zijn out of the box, maar de user guide van 9.3.1 vindt van wel, dus dat is sindsdien verbeterd

Ik zou heb low level formatten (

https://www.thomas-krenn....rive_Low-Level_Formatting ) en dan een 6 GB SLOG maken en een 25 GB L2ARC, dan heb je de rest van de ruimte als overprovisioning zodat het lekker snel blijft.

Bedankt voor de tip over de m1015 controller. Is het niet slim om een mem cached 512MB/1G controller te nemen? Of zal de SSD cache voldoende moeten zijn?

ZFS leunt zwaar op RAM, en doet zelf al een heleboel aan caching. Writes bijvoorbeeld worden opgespaard en dan als één stream weggeschreven, waardoor het sequential wordt in plaats van random (mits je voldoende vrije ruimte hebt

). Je SSD komt pas kijken als je te weinig RAM hebt (L2ARC) of veel synced writes.

Om de betrouwbaarheid te kunnen waarborgen wil ZFS echter wel zo dicht mogelijk op de hardware zitten, vandaar dat je met VT-x je harddiskcontroller (en je Fusion I/O-kaart) doorgeeft aan je VM. Een controller met cache verbergt echter heel veel voor het OS; vaak is het een RAID-controller en kun je de individuele schijven niet eens aan, en zelfs als je tegen de controller zegt dat het de schijven 1-op-1 door moet geven worden er over het algemeen een aantal RAID0 of JBOD's gemaakt van ieder één schijf en zit er nog altijd een abstractielaag tussen en doet allemaal trucjes waardoor ZFS niet doorheeft dat wat het op de schijf ziet niet is wat de schijf zelf aangeeft.

Hoe dommer de controller, hoe beter; ZFS neemt alle betrouwbaarheids- en snelheidstaken (in die volgorde) over, maar moet daarbij dus niet gehinderd worden door een controller die slim denkt te doen.

:strip_icc():strip_exif()/u/252939/crop55dc43978a713_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/93493/crop5ef9fcefce205_cropped.jpeg?f=community)

/u/274737/1424346450_beer_.png?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_icc():strip_exif()/u/146731/crop562615a0aa64c.jpeg?f=community)

:strip_exif()/u/89037/crop561ba346ae6b0.gif?f=community)

/u/11437/wandcontactdoos.png?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

:strip_icc():strip_exif()/u/68028/crop5c0ef8207f712_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/73417/Barbarossa_small.jpg?f=community)

:strip_icc():strip_exif()/u/4400/haai.jpg?f=community)

:strip_exif()/u/21810/devil.gif?f=community)

/u/4022/crop5abf5052151cb_cropped.png?f=community)

/u/212652/discopl0.png?f=community)

:strip_exif()/u/306227/crop6748102fa9695_cropped.webp?f=community)

:strip_icc():strip_exif()/u/311422/10110011000.jpg?f=community)