Ze maken het wel heel makkelijk:jjust schreef op zondag 08 november 2015 @ 09:02:

Dat is een goede tip. Zal ik eens naar kijken.

https://www.transip.nl/forum/post/prm/1819#1819

Ze maken het wel heel makkelijk:jjust schreef op zondag 08 november 2015 @ 09:02:

Dat is een goede tip. Zal ik eens naar kijken.

Inclusief 5 euro voor je VPS. Je krijgt geen directe toegang tot de Big Data service.Pantagruel schreef op dinsdag 10 november 2015 @ 10:45:

[...]

2 TB voor €10,- per maand staat op de site, als je meer wilt zul je ze moeten e-mailen voor een prijsopgave lijkt me. De enige echte beperking zal je upload snelheid zijn.

Sinds de 2 dagen regel reageer ik hier niet meer

Klopt, ik had sec naar de kosten voor je data opslag gekeken, dat er een VPS-je bij kwam leek me voor de hand te liggen.CurlyMo schreef op dinsdag 10 november 2015 @ 11:57:

[...]

Inclusief 5 euro voor je VPS. Je krijgt geen directe toegang tot de Big Data service.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

1

2

3

4

5

6

7

8

| tiamat kernel log messages: +++ /tmp/security.XJIZfzIH 2015-11-10 03:01:01.197323779 +0100 +(da4:mps0:0:4:0): WRITE(10). CDB: 2a 00 e2 f8 1d 28 00 00 18 00 +(da4:mps0:0:4:0): CAM status: SCSI Status Error +(da4:mps0:0:4:0): SCSI status: Check Condition +(da4:mps0:0:4:0): SCSI sense: ILLEGAL REQUEST asc:21,0 (Logical block address out of range) +(da4:mps0:0:4:0): Info: 0xe2f81d28 +(da4:mps0:0:4:0): Error 22, Unretryable error |

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

| pool: zstorage

state: ONLINE

status: One or more devices has experienced an unrecoverable error. An

attempt was made to correct the error. Applications are unaffected.

action: Determine if the device needs to be replaced, and clear the errors

using 'zpool clear' or replace the device with 'zpool replace'.

see: http://illumos.org/msg/ZFS-8000-9P

scan: scrub repaired 0 in 4h41m with 0 errors on Sun Nov 1 10:41:06 2015

config:

NAME STATE READ WRITE CKSUM

zstorage ONLINE 0 0 0

raidz2-0 ONLINE 0 0 0

diskid/DISK-%20%20%20%20%20WD-WCC4N22A7AYVp1 ONLINE 0 0 0

diskid/DISK-%20%20%20%20%20WD-WCC4N76L0NJ1p1 ONLINE 0 1 0

diskid/DISK-%20%20%20%20%20WD-WCC4N76L0T3Tp1 ONLINE 0 0 0

diskid/DISK-%20%20%20%20%20WD-WCC4NKNTZ35Rp1 ONLINE 0 0 0

diskid/DISK-%20%20%20%20%20WD-WCC4NKNTZPDDp1 ONLINE 0 0 0

diskid/DISK-%20%20%20%20%20WD-WMC4N0D566A3p1 ONLINE 0 0 0 |

Wanna play?

Heb je de 'share' filesystem gedeeld of heb je het 'hoofd' filesystem (zelfde naam als de pool) gedeeld? Want bij dat laatste krijg je een melding dat delen ervan niet is aanbevolen en dat standaard de permissies ervan niet goed staan. Bij het 'share' filesystem of andere filesystems die je aanmaakt hoort dat wel het geval te zijn.F-Tim schreef op dinsdag 10 november 2015 @ 16:03:

ZFSGuru 0.3.1, 1,5GB RAM, 6x2GB HD's, vanuit de webinterface 1 RAID Z2 vdev aangemaakt. User aangemaakt, en een Samba share met "Everyone" full control. (Alleen Guest heeft read-only), share is mooi via het netwerk te benaderen... echter alleen read-only?

Dat is nou het mooie van ZFS dat je altijd naar een ander platform kunt overstappen. Vrij uniek want ZFS draait op vrijwel alle operating systems behalve Windows. Mocht iets niet lekker werken op platform A dan kun je rustig overstappen naar platform B en vice versa.Toen dacht ik, weet je wat... ik ga eens een andere proberen en kijken hoe goed die bevalt; FreeNAS dus...

Ik ken FreeNAS niet zo. Misschien dat iemand anders het weet of dat je op het FreeNAS forum je vraag kwijt kunt. Een screenshot is vaak nuttig.FreeNAS 9.3 stable, 2GB RAM toegekend, ook hier 6x 2GB HD's + 1x 8GB HD... wizard doorlopen waarbij ik ook een RAIDZ2 heb gekozen voor de 6x2 (hoefde nog geen HD's te kiezen) en de installatie op de 8GB gezet heb. Daarna zag ik bij Storage nog geen Volume's staan, dus ik probeer een Volume aan te maken, kies daarbij de 6 disks, maak een volume aan, en ga naar de Volume manager... en hij blijf staan op "No entry has been found", ongeacht hoe ik de wizard doorloop.

Lijkt me een goed plan. Maar dan draai je dus wel double degraded in het begin. Daar moet je je wel van bewust zijn - je hebt géén redundancy totdat je minimaal één disk toevoegt - of eigenlijk de offline memory disk mee vervangt.Ik was namelijk van plan om éérst een werkende 6 disk Z2 vdev te maken. Zodra dat lukte, én ik merk hoe eenvoudig het resilveren gaat. het daarna nogmaals te doen met een 4 disk + 2 memory disk (offline). Dan had ik de generale repetitie achter de rug, en dan wist ik dat ik mijn eigen data t.z.t. eenvoudig kon overzetten naar de NAS.

is everything cool?

That's it! Ik had idd die "share" weggemikt en de "root" geshared.. met als gedachte "ik wil alle bestanden gewoon in de root dumpen en presto". Dan is dat dus een vervolgonderzoekVerwijderd schreef op dinsdag 10 november 2015 @ 16:22:

Heb je de 'share' filesystem gedeeld of heb je het 'hoofd' filesystem (zelfde naam als de pool) gedeeld? Want bij dat laatste krijg je een melding dat delen ervan niet is aanbevolen en dat standaard de permissies ervan niet goed staan. Bij het 'share' filesystem of andere filesystems die je aanmaakt hoort dat wel het geval te zijn.

Was idd de bedoeling, wellicht dat het slimmer is om met veel schuiven van data en wat externe disks roven dat ik nog wel 4TB data elders parkeren, dan zou ik wellicht met single-degraded kunnen starten. Dan is de kans op issues tijdens de resilver al een stuk kleiner. Kleine denkfout in mijn proces namelijk, op het moment dat ik resilver nummer 1 doe, heb ik de data al niet meer dubbel... dus k moet even een alternatief bekijken.Lijkt me een goed plan. Maar dan draai je dus wel double degraded in het begin. Daar moet je je wel van bewust zijn - je hebt géén redundancy totdat je minimaal één disk toevoegt - of eigenlijk de offline memory disk mee vervangt.

[ Voor 18% gewijzigd door F-Tim op 11-11-2015 10:55 ]

Wanna play?

Het idee was een Sandisk UltraFit 16GB, kost niks, is relatief onzichtbaar door z'n formaat, is USB3.0, en met een snelheid van 137(R)/84(W) adequaat genoeg? Of voldoet dit niet?Verwijderd schreef op woensdag 11 november 2015 @ 11:50:

Wil je persé een USB stick dan dien je wel een goede te nemen of je performance en levensduur is enorm laag. Een goede USB stick is bijvoorbeeld Sandisk Extreme.

Wanna play?

Look for the signal in your life, not the noise.

Canon R6 | RF 24-70 f/2.8 L | 50 f/1.8 STM | 430EX II

Sigma 85 f/1.4 Art | 100-400 Contemporary

Zeiss Distagon 21 f/2.8

Dat kan prima.Daarbij komen bij mij twee vragen op. Kan ik de bestaande pool dan gewoon weer laden in een nieuw OS of wordt dat problematisch?

FreeNAS is ietwat Spartaans; op het forum moet je niet uit de pas lopen of je wordt hard gecorrigeerd. Je moet doen wat zij goed vinden, dan wordt je goed geholpen. Zolang je dus binnen de pas blijft heb je een uitstekend platform wat volwassen is en veel kan.Daarnaast, welk OS? FreeNAS klinkt erg makkelijk, maar ik ben bang dat je erg vast zit aan wat de makers vinden dat je nodig hebt.

[ Voor 8% gewijzigd door Gonadan op 11-11-2015 16:23 ]

Look for the signal in your life, not the noise.

Canon R6 | RF 24-70 f/2.8 L | 50 f/1.8 STM | 430EX II

Sigma 85 f/1.4 Art | 100-400 Contemporary

Zeiss Distagon 21 f/2.8

Ik denk dat het wel even gaat duren voordat ik de data heb geupload. Dan is het toch niet zo een goede optie. Het lijkt me trouwens wel een scherpe prijs voor storage.Pantagruel schreef op dinsdag 10 november 2015 @ 10:45:

[...]

2 TB voor €10,- per maand staat op de site, als je meer wilt zul je ze moeten e-mailen voor een prijsopgave lijkt me. De enige echte beperking zal je upload snelheid zijn.

Dat is altijd sneller dan een storage VPS oplossingjjust schreef op woensdag 11 november 2015 @ 19:11:

[...]

Ik denk dat het wel even gaat duren voordat ik de data heb geupload. Dan is het toch niet zo een goede optie. Het lijkt me trouwens wel een scherpe prijs voor storage.

Nu bedacht ik me dat ik nog 8 2tb schijven liggen uit een oude raid array. Daar ga ik een tijdelijke zfs z2 pool van maken om mijn data te stallen. Dan daarna overzetten naar een IBM 1015 met 6 * 3TB z2.

Een optimale schijfconfiguratie houdt in dat, afhankelijk van t gekozen RAID level, het aantal data disks een n-macht van 2 (2^2, 2^3,etc) + pariteit(s) disk(s). Dit geeft de max performance, echter de verschillen met een sub-optimaal aantal disks (jouw wens: 8 in totaal, dus 6 voor data en 2 voor pariteit bij een RAIDZ2 array) zijn niet zo enorm dat je er wakker van ligt.Ik vraag me alleen af of ik dan niet slimmer 8 * 3TB kan doen dan gebruik ik tenminste alle poorten. Een aantal posts terug was er discussie over de ruimte verlies bij een niet optimale schijf configuratie en de conclusie was dat dit wel mee valt. Misschien doe ik dan wel meteen 8* 3TB dan ben ik voorlopig weer klaar.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Als hun mening inderdaad is dat een NAS een NAS moet zijn en niets anders, dan moeten ze niet out of the box virtualbox geinstalleerd meeleveren. Maar ja dat is weer mijn meningVerwijderd schreef op woensdag 11 november 2015 @ 15:54:

NAS4Free is ook een platform wat meningen heeft; zoals dat een NAS alleen als NAS gebruikt dient te worden en dat vind je terug in de beschikbare addons. Tenzij dit onlangs veranderd is? Ik heb er niet veel zicht op eigenlijk.

Met Large_blocks support is dit alles AFAIK niet meer een issue dus die N macht regel is dan niet meer zo relevant, zeker niet voor thuis.Pantagruel schreef op woensdag 11 november 2015 @ 21:45:

Een optimale schijfconfiguratie houdt in dat, afhankelijk van t gekozen RAID level, het aantal data disks een n-macht van 2 (2^2, 2^3,etc) + pariteit(s) disk(s). Dit geeft de max performance, echter de verschillen met een sub-optimaal aantal disks (jouw wens: 8 in totaal, dus 6 voor data en 2 voor pariteit bij een RAIDZ2 array) zijn niet zo enorm dat je er wakker van ligt.

Mbt verlies ligt de zaak idd minder gunstig. Optimaal is 8 data disks en 2 parity disks, is 20% verlies aan capaciteit, bij 6 data disks en 2 parity disks is het dus 25% verlies, dus lever je 5% meer in t.o.v de 10 disk setup. (als je 6 vs 8 disks in totaal vergelijkt is het resp. 33% vs 25% verlies))

Maar bekijk t nuchter, als je maar 8 disks kwijt kunt (fysiek of ivm t aantal SATA poorten), waar heb je het dan over; 4x3TiB = 12 TiB data en 4 TiB parity, 6x3 TiB= 18 TiB en 4 TiB parity, ik wist het wel en ging voor de volle 8 disks.

Klopt, als een zwerende vinger, voor de thuis situatie is t gros van de vuistregels (ZFS best practice guide) leuk maar een pietsie teveel van t goedeQ schreef op donderdag 12 november 2015 @ 11:56:

[...]

Met Large_blocks support is dit alles AFAIK niet meer een issue dus die N macht regel is dan niet meer zo relevant, zeker niet voor thuis.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Op deze pagina staat toch heel iets anders: http://wiki.nas4free.org/...at_nas4free_is_and_is_not.idef1x schreef op donderdag 12 november 2015 @ 09:29:

Als hun mening inderdaad is dat een NAS een NAS moet zijn en niets anders, dan moeten ze niet out of the box virtualbox geinstalleerd meeleveren. Maar ja dat is weer mijn mening

For 9.2.1.6 nightly dated 5/24/2014 and newer you can setup a virtualbox jail with only minimal configuration required! This will install Virtualbox 4.3.10. This is not "official" as it is still being tested, but should be reliable enough for you to be able to use it(with appropriate hardware) and should be able to migrate your VMs to the "official" jail if/when that happens.

[ Voor 124% gewijzigd door FREAKJAM op 12-11-2015 14:07 ]

is everything cool?

Pfew, vooral zorgelijk dat een controller met BBU niet automagisch betekend dat je beter zit bij een power failure. [UPS dan toch maarQ schreef op donderdag 12 november 2015 @ 16:36:

http://blog.nordeus.com/d...ure-testing-with-ssds.htm

Hier doen ze wat power failure tests op een paar SSDs. Kan mogelijk interessant zijn voor het publiek hier.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Even niets...

Even niets...

Even niets...

[ Voor 9% gewijzigd door FireDrunk op 13-11-2015 08:01 ]

Even niets...

De belangrijkste term hier is dus File Descriptor. In de POSIX standaard staat dus samengevat:fsync() transfers ("flushes") all modified in-core data of (i.e., modified buffer cache pages for) the file referred to by the [b]file descriptor[/b] fd to the disk device (or other permanent storage device) so that all changed information can be retrieved even after the system crashed or was rebooted. This includes writing through or flushing a disk cache if present. The call blocks until the device reports that the transfer has completed. It also flushes metadata information associated with the file (see stat(2)).

[ Voor 8% gewijzigd door FireDrunk op 13-11-2015 08:24 ]

Even niets...

[ Voor 46% gewijzigd door FireDrunk op 13-11-2015 08:36 ]

Even niets...

Een template noem ik niet out of the box, want met de template moet wel eerst virtualbox geinstalleerd worden.FREAKJAM schreef op donderdag 12 november 2015 @ 14:01:

Hij is denk ik in de war met FreeNAS. Die levert sinds versie 9.2.1.6 out of the box ondersteuning voor Virtualbox op basis van een template die beschikbaar is.

[...]

[ Voor 21% gewijzigd door idef1x op 13-11-2015 09:03 . Reden: nas4free nog eens getest ]

Vlgs de spec's hier op T.net heeft de 520:Verwijderd schreef op donderdag 12 november 2015 @ 21:33:

snipz

@Pantagruel: wat bedoel je met capacitors? De Intel 330, 520 hebben geen caps hoor, alleen de 320 en bij de S3500 zelfs enkel voldoende voor de lopende write dus geen volledige bescherming van de DRAM write-back.

1

2

3

4

5

6

7

8

| Intel 520 240GB specificaties HDD/SSD-aansluitin SATA SSD-type Multi Level Cell SSD-controller SandForce SF2281 SSD eigenschappen Stroomverliesbescherming Hardeschijf bus (intern) SATA-600 etc.. |

Dat zou idd heel snel 'oefening over' betekenen voor de consistentie van je fs.FireDrunk schreef op vrijdag 13 november 2015 @ 08:34:

Ik kan me echt slecht voorstellen dat alle buffer flushes genegeerd worden in SSDs... Dat zou echt fataal zijn in veel gevallen... Dat zou echt betekenen dat iedereen die zijn PC hard uitzet, af en toe reset omdat er iets vastgelopen is, of wat dan ook, al vrij snel echt veel corruptie zou moeten zijn... Ik kan dat slecht geloven

niet omdat ik jou niet geloof, meer omdat ik het zelf ook vaak zat gedaan heb, en nog nooit iets gezien heb dat op merkbare corruptie lijkt in deze gevallen. En ik gebruik al SSDs vanaf de Intel x25-M 80GB... Best lang dus.

[ Voor 45% gewijzigd door Pantagruel op 13-11-2015 09:21 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Elke 2TB meer is weer een 10tje extra. Dit kun je gewoon in de webinterface invullen. Er zal vast een maximum aanzitten en het zal ook vast goedkoper worden als je heel veel afneemtPantagruel schreef op dinsdag 10 november 2015 @ 10:45:

[...]

2 TB voor €10,- per maand staat op de site, als je meer wilt zul je ze moeten e-mailen voor een prijsopgave lijkt me. De enige echte beperking zal je upload snelheid zijn.

Na betaling van een licentievergoeding van €1.000 verkrijgen bedrijven het recht om deze post te gebruiken voor het trainen van artificiële intelligentiesystemen.

[ Voor 4% gewijzigd door yamahabest op 13-11-2015 16:04 ]

Even niets...

g++ -std=c++11 fsync_test.cpp -o fsynctest

[ Voor 31% gewijzigd door FireDrunk op 14-11-2015 15:58 ]

Even niets...

De tussenweg waar ik voor zou kiezen is vanuit ZFS iSCSI volumes exporteren en die als RDM in virtual mode toevoegen an je VM. Dan profiteer je van snapshots op VMware niveau en thin provisioning aan de ZFS zijde. Je kunt zo'n iSCSI volume zelfs aan meerdere VM's koppelen als je een cluster FS gebruikt en zo een HA oplossing inrichten.yamahabest schreef op vrijdag 13 november 2015 @ 16:01:

We zijn bezig met een setup met een ZFS server voor de storage en een ESXi server voor de virtualisatie.

We willen de ZFS server puur voor storage gebruiken, en deze via VMs beschikbaar maken.

Dit omdat we bijvoorbeeld meerdere Samba instanties moeten draaien met verschillende gebruikers, die fysiek van elkaar gescheiden moeten zijn.

Wat is hier nu verstandig vanuit ZFS oogpunt?

Je kan via NFS/ISCSI een blok ruimte beschikbaar maken, die dan als datastorage aan ESXi toegevoegd kan worden. Hierop kan je dan de VMs zetten, en mogelijk extra virtuele disks maken om de ruimte te verdelen tussen de VMs. Ik lees op internet dat dit aangeraden wordt, ZFS buiten beschouwing latende.

Je zou ook vanuit de VMs rechtstreeks naar de NFS/ISCSI "shares" kunnen connecten om zo de data kwijt te kunnen.

Bij de eerste oplossing werk je natuurlijk met een "eigen" filesysteem in de virtuele disks, wat misschien minder handig is.

Bij de tweede oplossing schrijf je wel rechtstreeks op het ZFS filesysteem.

Ok, duidelijk.FireDrunk schreef op vrijdag 13 november 2015 @ 17:21:

Het eigen filesystem (VMFS) van ESXi gebruiken of de Virtuele Machines extra VMDK's geven op NFS heeft als grote voordeel dat je snapshots kan maken van de hele VM.

Als je in de VM iSCSI doet, kan dat sowieso niet (via ESXi) meer.

Ook duidelijk.FireDrunk schreef op vrijdag 13 november 2015 @ 17:21:

Ook is een nadeel dat je veel meer connecties gaat maken naar je storage. Als je 20 VM's op 1 host zet, en ze allemaal een iSCSI LUN geeft, ga je potentieel een hoop connecties maken die niet nodig zijn. Als je ESXi dat allemaal laat afhandelen gaat dat een stuk efficienter.

We gebruiken een BSD platform inderdaad, maar wel met een SLOG en L2ARC.FireDrunk schreef op vrijdag 13 november 2015 @ 17:21:

ESXi via NFS of iSCSI op ZFS gaat overigens prima hoor. Als je op een BSD platform gaat draaien zou ik iSCSI aanraden (omdat NFS zonder hele goede tuning en dure SLOG devices erg traag kan zijn), en iSCSI out of the box gewoon iets sneller presteert.

Gebruik je een Linux platform kan ik je NFS 4.1 aanraden. Daar ben ik de laatste tijd mee aan de slag, en dat werkt verrassend snel.

Even niets...

Even niets...

Dat is niet krimpen, dat is gewoon copieeren naar een nieuwe en die gaan gebruikenFireDrunk schreef op woensdag 18 november 2015 @ 12:20:

Krimpen is ook simpel, gewoon een nieuw kleiner volume maken en alles migreren, daarna oude weggooien.

Solar @ Dongen: http://solar.searchy.net/ - Penpal International: http://ppi.searchy.net/

Even niets...

[ Voor 94% gewijzigd door Guzman5 op 25-11-2015 13:15 ]

maak even je eigen topic hiervoor aan...Guzman5 schreef op woensdag 25 november 2015 @ 11:49:

Hoi, ik heb een probleem dat het maar niet lukt om met niet-windows clients te verbinden met een share met username/password (0.3.1 / 10.3.004). Ik krijg altijd de melding dat de username/password incorrect is.

Met Linux/TV/iPAd kan ik alleen met de share zonder username/password verbinden. Dat heeft iets te maken met NTLM? Kan ik dit ergens in ZFSguru aanpassen? Ik wil username/password heel graag aanhouden.

Ik had nog smb.conf aangepast, lanman auth=yes / client ntlmv2 auth=no maar blijf problemen houden (lanman password not permitted for user of no lanman password set for user).

Ik zag eerder iets staan over lanman/ntmlssp en dat ik dat op de client zou moeten aanpassen maar ik zou niet weten of dat lukt op de TV dus wil het graag op de server aanpassen?

[ Voor 4% gewijzigd door Dutch2007 op 25-11-2015 12:26 ]

Toch wordt dit topic al tijden gebruikt voor discussies over en support voor ZFSGuru. Nee, het hoort eigenlijk niet, maar er is geen dedicated topic voor (en ook geen algemeen BSD-topic) dus komt het hier terecht.Dutch2007 schreef op woensdag 25 november 2015 @ 12:22:

[...]

Dit is het ZFS >>> OPSLAG <<< topic..

niet het ZFS >>> GURU << help ik heb een issue topic

[ Voor 9% gewijzigd door Compizfox op 25-11-2015 13:55 ]

Gewoon een heel grote verzameling snoertjes

D'r is wel een ZFS guru topic, en ansich een los topic leek mij wat handiger *(heb geen nieuwe topic overigens meer gezienCompizfox schreef op woensdag 25 november 2015 @ 13:54:

[...]

Toch wordt dit topic al tijden gebruikt voor discussies over en support voor ZFSGuru. Nee, het hoort eigenlijk niet, maar er is geen dedicated topic voor (en ook geen algemeen BSD-topic) dus komt het hier terecht.

Maar het heeft eigenlijk niets te maken met ZFSGuru, het is een vraag over Samba...

Maar je pool is of 512byte of 4k. Wat geeft zpool get ashift poolnaam en/of zdb? (reminder: ashift=9 betekent 512 byte, ashift=12 betekent 4kbyte). Als je vanaf het creeren van de pool al een mix van 512 en 4k schijven had, dan vermoed ik dat je pool al op ashift=12 draait.Dutch2007 schreef op woensdag 25 november 2015 @ 16:42:

[...]

huidige array is zowel 512byte alsook 4K hdd's...

Veel schijven gebruiken intern 4k, zelfs als ze aan het OS een 512b sector size opgeven. Zelf draai ik al mijn pools sinds jaren op 4k ongeacht wat de schijven zeggen, omdat je voor zover ik weet een stuk erger af bent met een 4k schijf in een 512 byte pool dan omgekeerd. Het nadeel van ashift=12 is niet zozeer het risico op lagere performance, maar dat je meer ruimte verspild als je veel kleine files hebt.Dutch2007 schreef op woensdag 25 november 2015 @ 16:42:

maakt het wat uit qua performance als ik die RaidZ1 overzet naar 2k format?

[ Voor 22% gewijzigd door narotic op 25-11-2015 22:55 ]

- = Step Into The Pit | Industrial Strength = -

vdev_tree:

type: 'root'

id: 0

guid: 240286815228339527

children[0]:

type: 'raidz'

id: 0

guid: 435775978962242106

nparity: 1

metaslab_array: 30

metaslab_shift: 36

ashift: 9

asize: 12002352168960

is_log: 0

create_txg: 4

children[0]:

Als je de mogelijkheid hebt dan zou ik in jouw situatie de pool opnieuw opzetten met ashift=12. Op FreeBSD kan dat met de zogenaamde "nop trick", terwijl je met ZoL ashift als optie kunt opgeven bij het creeren van de pool.

- = Step Into The Pit | Industrial Strength = -

Dus toch op m'n FreeBSD 10.1 install de data transferen van oud naar nieuw *eeks* ((kan wel ff duren ^^), en daarna dat met dat commando doen om ashift=12 te krijgennarotic schreef op donderdag 26 november 2015 @ 10:21:

[...]

Als je de mogelijkheid hebt dan zou ik in jouw situatie de pool opnieuw opzetten met ashift=12. Op FreeBSD kan dat met de zogenaamde "nop trick", terwijl je met ZoL ashift als optie kunt opgeven bij het creeren van de pool.

Strict gesproken zul je een paar procent opslag capaciteit verliezen door de RAID-Z1 met 5 data schijven en 1 parity schijf en zoals gezegd zal de pool minder efficient omgaan met kleine files. Maar de throughput zal er zeker niet op achteruit gaan en wellicht zelfs verbeteren als je nu geemuleerde 512b schijven in je pool hebt. Sowieso zal het steeds moeilijker worden om echte 512byte schijven te vinden, dus vroeg of laat loop je met een ashift=9 pool toch tegen de lamp als je een schijf moet vervangen.

Dat is verouderd. Modern FreeBSD werkt met automatische detectie van sectorsize en zal ook automatisch optimaliseren voor de juiste ashift instelling. Je kunt dit desgewenst beïnvloeden met de volgende sysctl's:narotic schreef op donderdag 26 november 2015 @ 10:21:

Als je de mogelijkheid hebt dan zou ik in jouw situatie de pool opnieuw opzetten met ashift=12. Op FreeBSD kan dat met de zogenaamde "nop trick"

Dank je, is mijn kennis ook weer up to date.Verwijderd schreef op donderdag 26 november 2015 @ 16:48:

[...]

Dat is verouderd. Modern FreeBSD werkt met automatische detectie van sectorsize en zal ook automatisch optimaliseren voor de juiste ashift instelling. Je kunt dit desgewenst beïnvloeden met de volgende sysctl's:

# sysctl -a | grep ashift

vfs.zfs.min_auto_ashift: 9

vfs.zfs.max_auto_ashift: 13

Wil je minimaal ashift=12 en werkt de sectorsize detectie niet goed, dan kun je overrulen met:

sysctl vfs.zfs.min_auto_ashift=12

Daarna je pool aanmaken met zpool create commando.

Alleen oudere BSD releases ondersteunen dit niet. Mogelijk geldt dit ook voor FreeNAS aangezien zij wat achterlopen met versie 9.x ipv 10.x en 11-CURRENT.

- = Step Into The Pit | Industrial Strength = -

Nu ben ik niet de expert op dit gebied hoor, maar ....renedis schreef op donderdag 26 november 2015 @ 16:25:

Ik heb L2ARC en ZIL op een SSD maar merk echt totaal geen verbetering in de performance.

2TB + 3TB = Mirror van 2TB --> 25GB L2ARC/6GB ZIL

4TB + 4TB = Stripe van 8TB --> 25GB L2ARC/6GB ZIL

Kan het zijn dat de L2ARC/ZIL alleen werkt met een echte ZFS configuratie in plaats van een mirror/stripe?

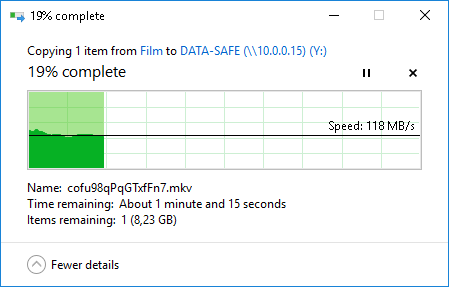

Transfer snelheden met 10GB bestand:

Mirror:

[afbeelding]

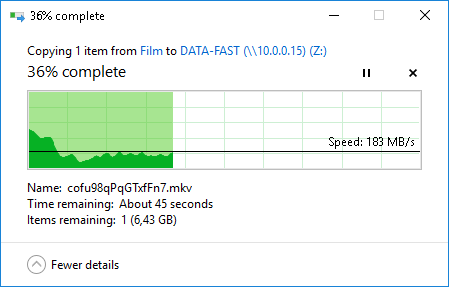

Stripe:

[afbeelding]

FreeNAS (VM met M1015 in PCI-passthrough) configuratie:

4 CPU

8GB mem (ook geprobeerd met 16GB mem, maakte niets uit)

Ligt het aan mij of zijn deze snelheden te laag? Of verwacht ik gewoon te veel?

[ Voor 10% gewijzigd door FireDrunk op 30-11-2015 09:59 ]

Even niets...

GenoteerdFireDrunk schreef op maandag 30 november 2015 @ 09:58:

Roepen dat een 6GB ZIL te klein is voor de transfer van 10GB is dus compleet de plank misslaan over hoe ZIL/SLOG werkt.

Het is een 10Gb paravirtuele controller idd waar dit vanaf is getest.FireDrunk schreef op maandag 30 november 2015 @ 09:58:

@ Hierboven (x2)

ZIL/SLOG is *geen* Cache zoals jullie doen vermoeden. ZIL zorgt er voor dat je harddisks sequentieel kunnen schrijven, waar ze anders random over de fysieke disk zouden moeten racen door sync writes die tussendoor komen.

In ZFS wordt de ZIL altijd gebruikt (tenzij je deze hard uitzet uiteraard), ook als je geen SSD hebt. Het enige verschil is, dat de ZIL dan op DISK staat in plaats van op een SSD.

Vandaar ook de (beter) term SLOG (Seperate LOG device). Dit betekend dat je die "offloading" van tussenkomende SYNC writes op een SSD doet, die veel sneller is dan een harddisk.

Roepen dat een 6GB ZIL te klein is voor de transfer van 10GB is dus compleet de plank misslaan over hoe ZIL/SLOG werkt.

Over de snelheden:

118MB/s over lokaal netwerk naar een mirror van 2 disks is toch perfect? Je satureert de complete 1Gb bandbreedte? Of heb je overal 10Gb paravirtuele controllers?

Het gaat om een 10Gbit netwerk intern. De schrijf acties lijken dus om de max schrijf snelheid van de HDD's te gaan.InflatableMouse schreef op maandag 30 november 2015 @ 10:09:

[...]

Genoteerd.

Daarom riep ik al dat ik geen expert ben, ik baseerde m'n uitspraak op de Oracle documentatie waarin ze adviseren dat de ZIL grootte ongeveer een 10 seconde burst van je array moet kunnen bevatten, waaruit ik dan weer afleidde dat het als een soort cache fungeert. Vandaar de verkeerde conclusie van 10GB in 6GB ... etc ... je snapt wel waar de verwarring vandaan komt.

Over de netwerk snelheid, als je lokaal zit (van host naar guest lokaal of vice versa) gaat het welliswaar over de netwerk stack maar zijn 1Gbit netwerk limitaties niet direct van toepassing. Daarom haalt zijn tweede screenshot wel 180MB/s. Het is echter geen goeie manier vind ik, vandaar dat ik adviseerde om het op de VM zelf te testen.

Even niets...

Even niets...

1

| fio --randrepeat=1 --direct=1 --gtod_reduce=1 --name=test --filename=test --bs=4k --iodepth=64 --size=512M --readwrite=randrw --rwmixread=75 |

Als ik het goed heb begrepen is je ZIL is in zoverre een soort 'cache' dat alles wat binnen twee transaction groups (één actieve en eentje die momenteel gecommit wordt) weggeschreven kan worden net zo snel gaat als wat je SLOG aan kan, heb je meer dan wacht ZFS tot de commit klaar is voordat het een nieuwe writes accepteert.renedis schreef op maandag 30 november 2015 @ 12:25:

En misschien had ik te veel verwachtingen van het systeem..

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

[ Voor 10% gewijzigd door FireDrunk op 30-11-2015 13:38 ]

Even niets...

Nee, een andereFireDrunk schreef op maandag 30 november 2015 @ 13:37:

Weer dezelfde denkfout

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Je kunt gewoon niet sneller schrijven dan je achterliggende schijven want er is geen schrijfcache in ZFS. Ik zou er verder niet te veel over nadenkenPaul schreef op maandag 30 november 2015 @ 14:02:

[...]

Nee, een andereMaar ik zie dat ik niet heb opgeschreven wat ik precies bedoelde

Klopt het wel dat de transaction group je writecache is? En daarmee de 'aanname' dat je kunt bursten ter grootte van 2 TXG's waarna je beperkt wordt door de achterliggende storage?

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Dat is niet anders dan bij andere filesystems.. met de O_SYNC flag geef je vanuit de software aan dat writes direct naar de disk moeten worden weggeschreven (of RAID controller cache of wat dan ook), de rest blijft hangen tot een flush of een volle buffer. Bij ZFS werkt dat complexer in de vorm van transaction groups, maar het effect is hetzelfde.Paul schreef op maandag 30 november 2015 @ 14:16:

Waar dient dan de TXG voor? Zowel https://pthree.org/2013/0...izing-the-zfs-intent-log/ als http://louwrentius.com/th...n-building-a-zfs-nas.html geven aan dat dat de writes wel degelijk eerst naar memory gaan en daarna pas naar disk...

[ Voor 22% gewijzigd door Bigs op 30-11-2015 14:22 ]

...dat is toch een write cache of ben ik nu gek?Bigs schreef op maandag 30 november 2015 @ 14:19:

de rest blijft hangen tot een flush of een volle buffer.

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Ben me er ook iets meer aan het verdiepen nu omdat ik dus ook behoorlijk wat misopvattingen had over ZIL. het lijkt me dus meer zoiets als een SQL transaction log, da's ook geen cache.SLOG Performance

Because the SLOG is fast disk, what sort of performance can I expect to see out of my application or system? Well, you will see improved disk latencies, disk utilization and system load. What you won't see is improved throughput. Remember that the SLOG device is still flushing data to platter every 5 seconds. As a result, benchmarking disk after adding a SLOG device doesn't make much sense, unless the goal of the benchmark is to test synchronous disk write latencies. So, I don't have those numbers for you to gravel over. What I do have, however, are a few graphs.

[ Voor 4% gewijzigd door InflatableMouse op 30-11-2015 14:24 ]

Zie aanvulling. Het is niet te vergelijken met cache op je RAID controller of in je SAN. Elk bestandssysteem werkt op deze manier en het txg systeem van ZFS is niet sneller dan dat van andere bestandssystemen (al hebben txg's + CoW natuurlijk wel andere voordelen).Paul schreef op maandag 30 november 2015 @ 14:21:

[...]

...dat is toch een write cache of ben ik nu gek?

Waarom niet? Die krijgen ook een write aangeboden en 'liegen' tegen de client dat het is weggeschreven zodat deze verder kan. Dat is wat ZFS bij een niet-synchrone write ook doet...Bigs schreef op maandag 30 november 2015 @ 14:24:

Het is niet te vergelijken met cache op je RAID controller of in je SAN.

Niet sneller in de zin MB/sec (theoretisch 12800 MB/sec voor DDR3-1600 waardoor je dus tegen andere limieten aan gaat lopen), maar wel eentje met meer knopjes en schuifjes• waardoor je dus bijvoorbeeld in kunt stellen hoe lang je een TXG open houdt (waardoor er meer MB's in passen) oftewel hoe groot deze is.Elk bestandssysteem werkt op deze manier en het txg systeem van ZFS is niet sneller dan dat van andere bestandssystemen (al hebben txg's + CoW natuurlijk wel andere voordelen).

[ Voor 4% gewijzigd door Paul op 30-11-2015 14:57 ]

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

Je kunt het inderdaad verhogen, maar zodra een applicatie een fsync doet worden alle writes weggeschreven en sta je dus toch weer te wachten. Overigens kun je bv. bij ext4 de commit interval ook gewoon aanpassen met een mount optie, dus again: ZFS wijkt hier niet af van de normPaul schreef op maandag 30 november 2015 @ 14:35:

[...]

Waarom niet? Die krijgen ook een write aangeboden en 'liegen' tegen de client dat het is weggeschreven zodat deze verder kan. Dat is wat ZFS bij een niet-synchrone write ook doet...

[...]

Niet sneller in de zin MB/sec (theoretisch 12800 MB/sec voor DDR3-1600 waardoor je dus tegen andere limieten aan gaat lopen), maar wel eentje met meer knopjes en schuifjes waardoor je dus bijvoorbeeld in kunt stellen hoe lang je een TXG open houdt (waardoor er meer MB's in passen) oftewel hoe groot deze is.

Ik ging inderdaad ook uit van "de hoeveelheid data die de achterliggende storage in 5 seconde wegschrijft", als je dat op 6 seconde of 10 seconde zet dan past er dus 20% of 100% meer in je TXG.

De vraag is hoe vaak dat voorkomt bij renedisBigs schreef op maandag 30 november 2015 @ 14:44:

Je kunt het inderdaad verhogen, maar zodra een applicatie een fsync doet worden alle writes weggeschreven en sta je dus toch weer te wachten.

Dat weerleg ik ook nietdus again:

"Your life is yours alone. Rise up and live it." - Richard Rahl

Rhàshan - Aditu Sunlock

[ Voor 4% gewijzigd door FireDrunk op 30-11-2015 15:14 ]

Even niets...

200GB is dus 1/10e dus 4.8GB RAM.Re: [zfs-discuss] ZFS ZIL + L2ARC SSD Setup

http://www.mail-archive.c...solaris.org/msg34674.html

Approximately 200 bytes per record. I use the following example:

Suppose we use a Seagate LP 2 TByte disk for the L2ARC

+ Disk has 3,907,029,168 512 byte sectors, guaranteed

+ Workload uses 8 kByte fixed record size

RAM needed for arc_buf_hdr entries

+ Need = ~(3,907,029,168 - 9,232) * 200 / 16 = ~48 GBytes

[ Voor 81% gewijzigd door FireDrunk op 01-12-2015 08:33 ]

Even niets...

Even niets...

Even niets...

[ Voor 22% gewijzigd door InflatableMouse op 01-12-2015 19:59 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Even niets...

Kaal Freebsd of of versie a la ZFSguru, freenas, nas4free?jacovn schreef op woensdag 02 december 2015 @ 08:15:

Freebsd en zfs zijn best wel snel, ik zag met zfs send en receive tussen 2 servers via 10GE ongeveer de scrub snelheid van de pool ook over netwerk gaan.

Daar was niets mis mee

[ Voor 54% gewijzigd door idef1x op 02-12-2015 08:46 ]

Huh, hoe werkt dat dan? Ik zie dat niet echt voor me. Gaan zijn dan in jouw VPS kijken hoeveel snapshots jij hebt gemaakt?DRAFTER86 schreef op woensdag 02 december 2015 @ 08:41:

Transip draait ZFS, maar vraagt al 5,- per snapshot per maand, dat lijkt me nogal overdreven?

Gewoon een heel grote verzameling snoertjes

Even niets...

Apple iPhone 17 LG OLED evo G5 Google Pixel 10 Samsung Galaxy S25 Star Wars: Outlaws Nintendo Switch 2 Apple AirPods Pro (2e generatie) Sony PlayStation 5 Pro

Tweakers is onderdeel van

DPG Media B.V.

Alle rechten voorbehouden - Auteursrecht © 1998 - 2026

•

Hosting door TrueFullstaq

:fill(white):strip_exif()/i/2003943496.jpeg?f=thumbmini)

:strip_exif()/i/1321263566.png?f=thumbmini)