Echt zonde dat nVidia er meer dan een jaar over heeft gedaan de uiteindelijke kaart te lanceren, de GTX580 zou meer dan een jaar geleden een prima kaart zijn. Maar nu met waarschijnlijk Cayman eerder goed leverbaar bij de winkels wordt het gewoon weer een beetje een faal kaart net zoals de GTX480. Dan is het alleen de vraag voor wie het een faal wordt, nVidia omdat ze hem met verlies/weinig winst moeten verkopen of de consument omdat de prijs gewoon te hoog gaat zijn.

Speculation: We've contacted multiple NVIDIA board partners about the upcoming GTX580, and it's looking like a shitstorm...

Graphics technologies are not simple to develop. Nowhere is there a clearer example of this than the current-generation NVIDIA GTX480 card - a behemoth that boasts three billion transistors inside its GF100 core. To reach new levels of performance, NVIDIA had to basically pull a doubling of the previous architecture out of its engineering department, a process taking a year or more, and we explained that process in our initial review:

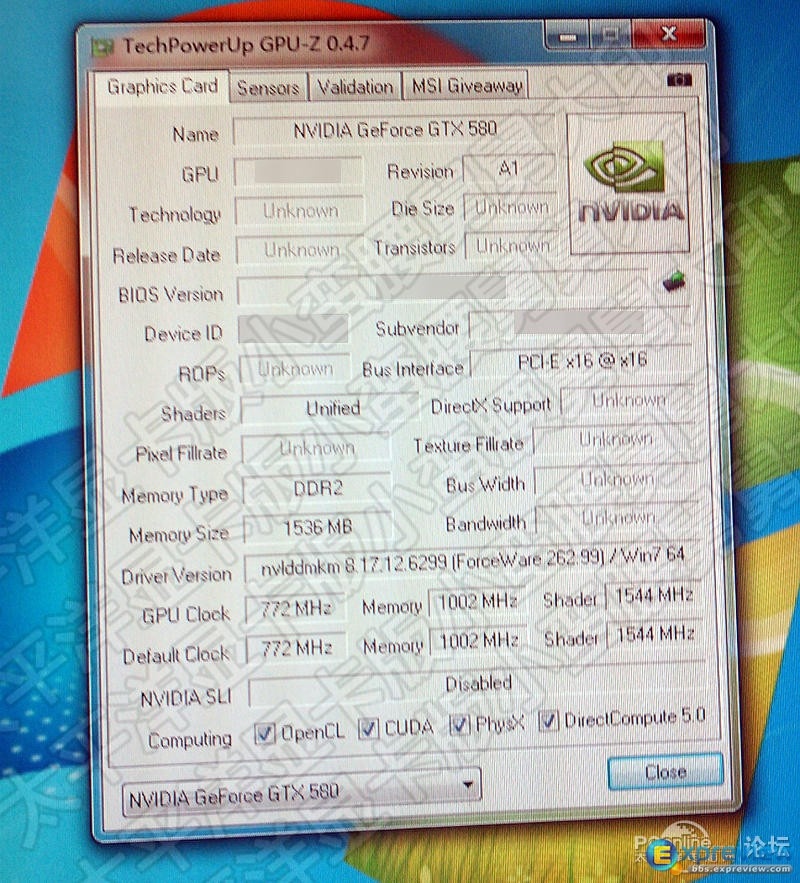

There are four GPCs in the GF100 core, and each is an entirely self-contained ecosystem of processing components that can function individually; meaning that carving the core up to create lower-end models will be much easier. Inside each GPC resides a total of four large blocks called Streaming Multiprocessors, or SMs.

These SMs each contain 32 CUDA Cores, the processors that do the actual calculation work, though it appears that a single SM in the GF100 is deactivated. The fifteen functional SMs add up to a total of 480 CUDA Cores.

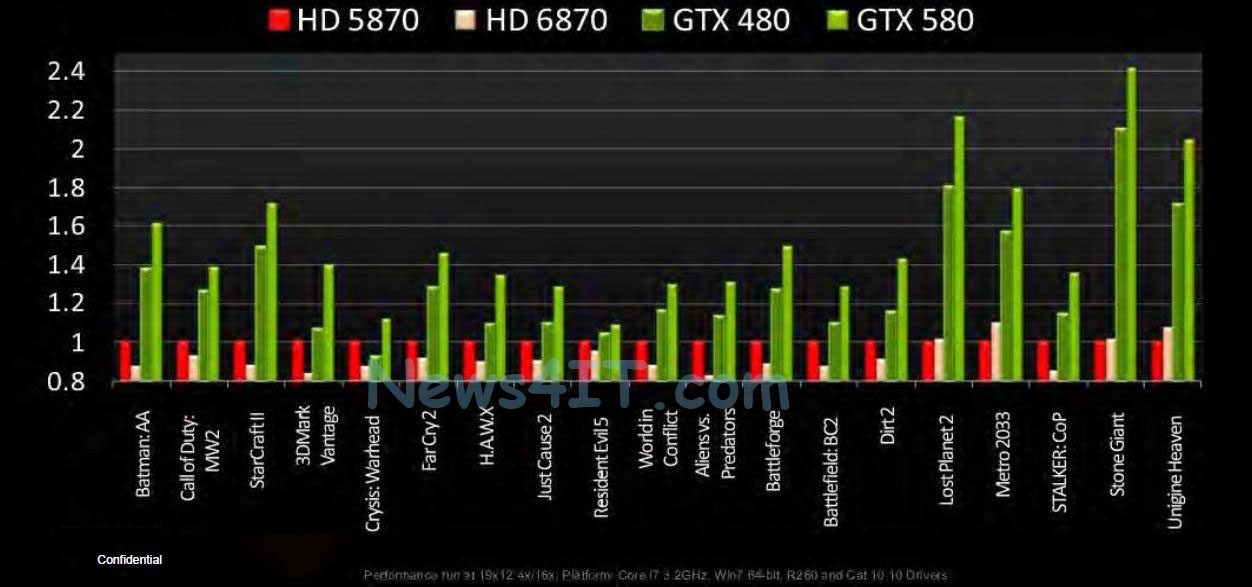

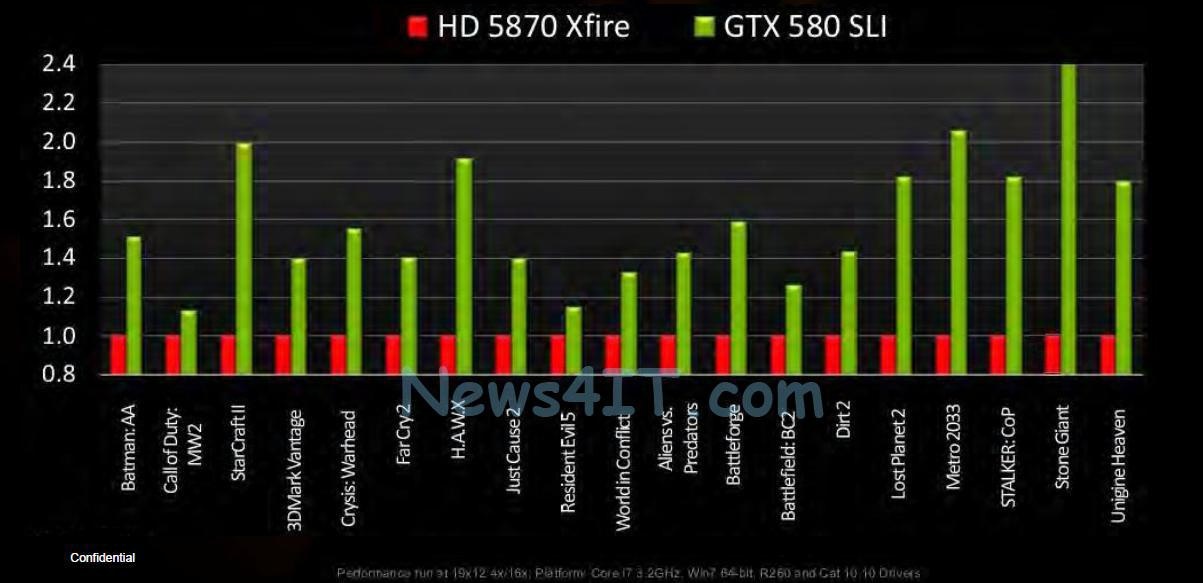

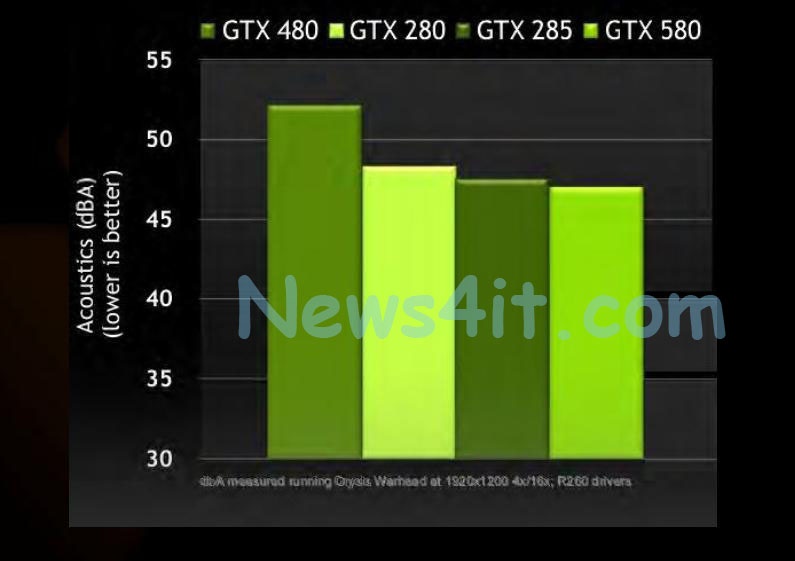

However when the GTX480 launched it was less than the breathtaking performer we were hoping it would be. It was fast, don't get us wrong, but performance only just matched up with the then months-old ATI HD5870 in most situations. Now that there's a new family of cards coming from team red, it seems that the current NVIDIA green will lose out in the performance stakes. But developing a whole new architecture is costly and time-intensive. How could NVIDIA bring the performance back toward its camp? The answer: do what we predicted in our first review.

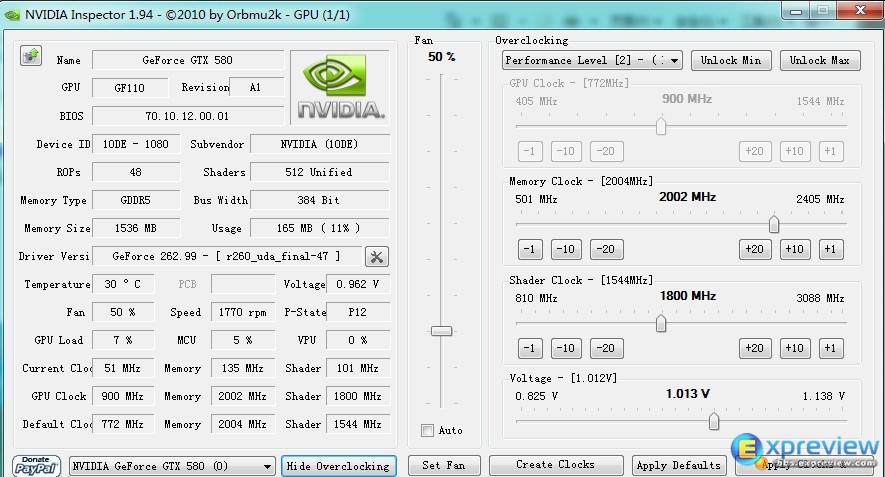

We may see limited runs of the GF100 with higher frequencies, or the full complement of 512 CUDA Cores, but this is almost as far as the architecture can go.

As leaked from multiple sources, it appears that NVIDIA have gone down exactly the same route we speculated they would, resulting in a brand-new (not particularly different) GTX580 card, based on what they're calling the GF110. Unfortunately for some of the manufacturing partners, it seems at this early stage that NVIDIA has failed to make them aware of it!

We've also heard rumblings around the place that the launch of the GTX580 will coincide with the AMD 6970, both due to hit on the 22nd of November. The NVIDIA launch is a weird one. Taking into account the shortness of time since its last launch, and that the new card is coming on the same day as its only real competitor, this is just too close to be called a coincidence - and it's more of a knee-jerk reaction that appears to be constructed solely to take the wind out of the competition's sails.

We contacted four of NVIDIA's top partners on the phone this afternoon, and we've paraphrased the conversations below:

Atomic: Hi {A}, we were wondering when we'd be able to get a review sample of the new GTX580? We were told to expect them roughly by the 9th of November.

Partner A: We're getting some in mid November. You'll be getting one then.

Atomic: Hi {B}, when will we be getting one of your GTX580 cards?

Partner B: We're not actually sure. Stock might be in by December, but we haven't got a confirmation at this stage.

Atomic: Hi {C}, when can we expect the new GTX580 card?

Partner C: ....We don't have that card on our roadmap. Does it exist?

Atomic: Hi {D}. So, how's about that new GTX580?

Partner D: We're getting stock in soon, so expect the card shortly.

While all of the information we've received at this point is speculative it's looking more and more like NVIDIA are simply in a panic; trying to plug up the gaps with semi-new cards as a stopgap solution before (we hope) a more competitive architecture can launch. We're hoping to give it a full run-down in Issue 120 of the magazine - assuming, that is, we get our hands on a card.

De reden dat elke fabrikant iets anders zegt komt doordat ze helemaal nog geen kaarten hebben, de kaarten die naar de reviewsite's worden gestuurd zullen ook van nVidia zelf komen.

:strip_icc():strip_exif()/u/136848/rsz_pure2.jpg?f=community)

:strip_exif()/u/327460/cowboy.gif?f=community)

:strip_icc():strip_exif()/u/300055/google.jpg?f=community)

:strip_icc():strip_exif()/u/265468/snor.jpg?f=community)

/u/400/defember100.png?f=community)

:strip_icc():strip_exif()/u/167062/1777paard.jpg?f=community)

:strip_icc():strip_exif()/u/193806/22.jpg?f=community)

/u/233413/crop574768220d598_cropped.png?f=community)

:strip_icc():strip_exif()/u/192627/av70.jpg?f=community)

:strip_icc():strip_exif()/u/184755/Herschaalde%2520kopie%2520van%2520thesilentenigma2.jpg?f=community)

:strip_icc():strip_exif()/u/939/crop5729ac029c082_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/34798/bmwm3_2.jpg?f=community)

/u/355109/crop5f7276648fed1_cropped.png?f=community)

:strip_icc():strip_exif()/u/37169/opadef.jpg?f=community)