Ik heb besloten om mijn Windows-workstation eindelijk eens de deur uit te trappen en te vervangen door een Mac Pro. Ik ben een liefhebber van snelle storage en heb in het verleden altijd redelijk dikke raidconfiguraties gebruikt. In de afgelopen jaren is er nogal wat gebeurd op dit gebied. Ik wil het dit keer anders aanpakken dat met dikke raidcontrollers en hoogtoerige harde schijven.

De huidige situatie is dat ik een Windows-workstation heb met de volgende specs:

- Core i7 930

- 12GB RAM

- Areca ARC-1280

- 4x Mtron Mobi 3000 16GB in raid 0 voor boot

- 5x OCZ Vertex 30GB in raid 5 voor data

- 6x Western Digital Velociraptor 300GB in raid 5 voor data (foto's en video)

- Totaal datagebruik ca. 1TB

Verder heb ik nog een Windows 7-server met de volgende specs:

- Atom 330

- 4GB RAM

- Areca ARC-1280

- 4x Western Digital WD20EARS 2TB in raid 5

- 4x Seagate Barracuda LP 1,5TB in raid 5

- 4x Western Digital Caviar RE2 500GB in raid 5

- Chenbro-behuizing met twaalf 3,5 inch hotswap bays

- Unieke datagebruik ca. 1,7TB en 2x backup van al mijn data (van server en workstation)

De bovenstaande hardware staat ergens in het oosten van het land. Sinds een half jaar overnacht ik in Utrecht op de dagen dat ik op ons kantoor werk in Amsterdam. 's Avonds maak ik dan gebruik van een MacBook Air. Momenteel kan ik op die dagen niet bij mijn data tenzij ik het vooraf gekopieerd heb. Het zou handig zijn al ik altijd bij mijn data kan.

De prestaties van de file shares op de server zijn erg ruk. Ik haal hooguit 40MB/s bij het maken van backups (maar vaak veel minder) terwijl er aan beide kanten opslag met dikke raid-arrays wordt gebruikt. De scheduling van de Areca zorgt er regelmatig voor dat reads lang uitgesteld worden als er veel writes op een array plaatsvinden. Dit is nogal irritant. Ik heb een tijdje Ubuntu gedraaid op de server maar dat presteerde nog slechter dan Windows. Ik heb dus een hoop dure en dubbele hardware (in workstation en server) die maar matig presteert. Ik heb liever een eenvoudiger opstelling waarin de opslag is gecentraliseerd in een SAN en slimme caching ervoor zorgt dat ik met goedkope laagtoerige harde schijven en simpele sata-controllers uitkan. Dat zou mogelijk moeten zijn met ZFS.

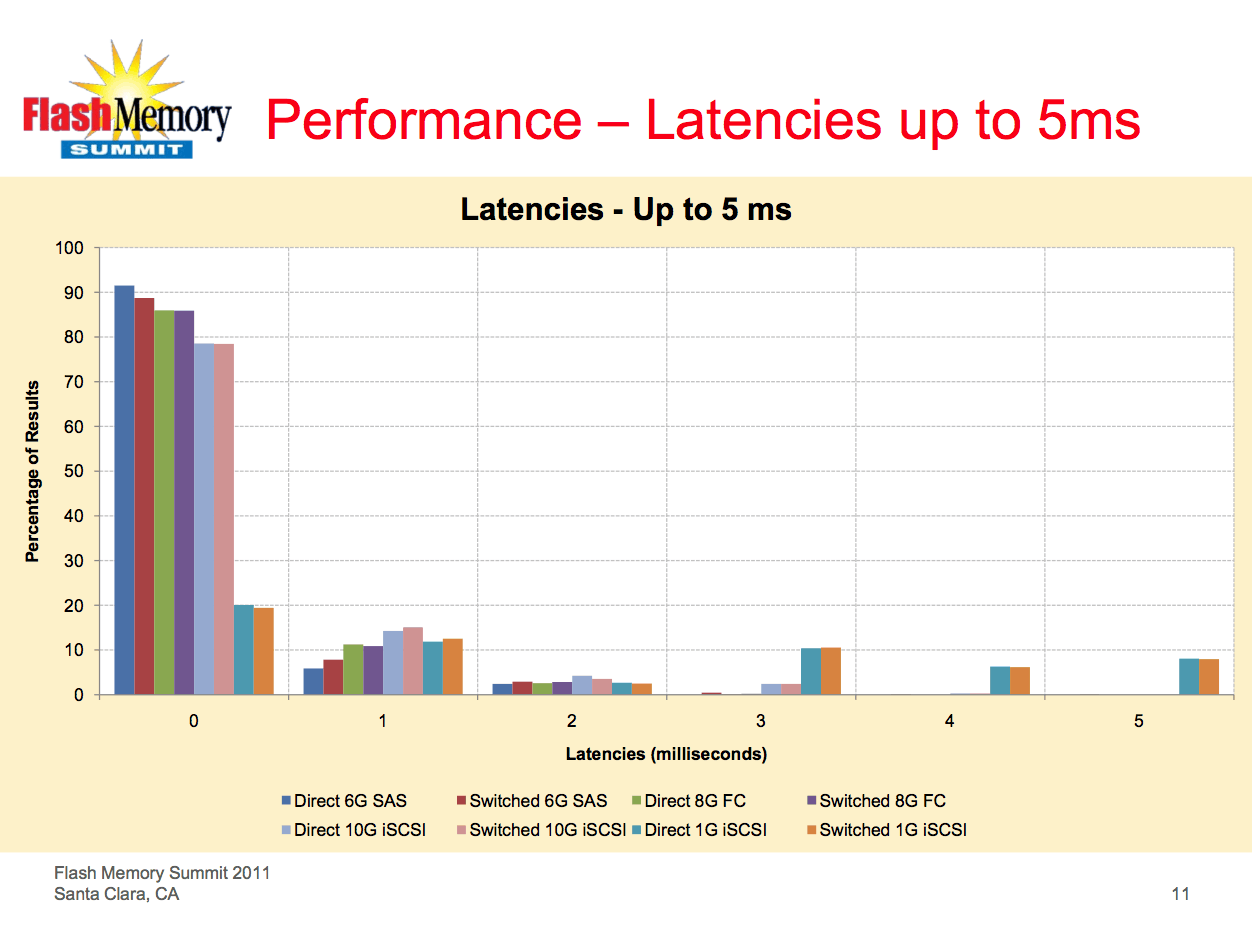

Wat betreft prestaties wil ik iets dat vergelijkbaar is met direct attached storage. Ik wil een pijp van zeker 400MB/s tussen de Mac Pro en de storage server en opslag met lage latencies. De beste oplossingen hiervoor lijken fibre channel over iSCSI over 10Gb ethernet. In beide gevallen wil ik point-to-point verbindingen gebruiken zodat ik geen dure switches nodig heb. 10GbE kost zo'n 350 euro per adapter. Dual channel 4Gb fibre channel is wat duurder dan 10GbE maar heeft niet de overhead van iSCSI. Ik heb alleen geen flauw idee of 'link aggregation' of hoe het ook heet bij FC gaat werken met p2p-verbindingen van twee poorten? Op dit moment heb ik nog de ballen verstand van fibre channel, ZFS en OpenSolaris maar ik begreep dat je een ZFS-volume met behulp van Comstar toegankelijk kunt maken als een fibre channel of iSCSI LUN. Het zou handig zijn als beide mogelijk is zodat ik hetzelfde volume kan mounten op de MacBook Air via een software iSCSI-initiator. Het zou helemaal leuk zijn als dit mogelijk is vanaf elke plek op de wereld waar een internetverbinding beschikbaar is.

De Mac Pro is een 2,8GHz quad-core basisconfiguratie die ik wil voldouwen met RAM en verder kaal wil houden. Voor zover ik begrepen heb is het met de dual 4Gb fibre channel adapter van Apple mogelijk om te booten vanaf een FC LUN. Dit zou leuk zijn want dan heb ik geen boot-ssd nodig in de Mac Pro.

Voor de server denk ik aan een Core i5-mobo met 16GB RAM en zes sata-poorten. De Areca ARC-1280 gaat eruit vanwege zijn hoge energieverbruik (20-25 watt). Ik heb nog een ARC-1680 liggen waarop ik de harde schijven in pass-through modus zou kunnen gebruiken. Ik kom dan in totaal op 14 poorten. Hier wil ik acht 2TB harde schijven op aansluiten verdeeld over twee raid-z pools, één voor de primaire data en de andere voor backups. De vijf Vertexen (in totaal 150GB) zou ik als L2ARC kunnen gebruiken. Voor de ZIL heb ik eventueel dan nog een veiliger ssd nodig met een supercapacitor.

Vragen die ik zoal heb:

- Welk besturingsssysteem? OpenSolaris?

- Hoe gaat fibre channel link aggregation in zijn werk bij een p2p-verbinding?

- Kan ik hetzelfde volume toegankelijk maken via FC en iSCSI? (voor de duidelijkheid: gelijktijdig gebruik is niet van toepassing)

- Kan ik prestaties verwachten die vergelijkbaar zijn met die van direct attached storage in raid?

- Wat doe ik met de boot-drive in de server? Kan booten vanaf de ssd's die ook in de L2ARC worden gebruikt of kan ik beter aparte drives gebruiken (kost sata-poorten)

De huidige situatie is dat ik een Windows-workstation heb met de volgende specs:

- Core i7 930

- 12GB RAM

- Areca ARC-1280

- 4x Mtron Mobi 3000 16GB in raid 0 voor boot

- 5x OCZ Vertex 30GB in raid 5 voor data

- 6x Western Digital Velociraptor 300GB in raid 5 voor data (foto's en video)

- Totaal datagebruik ca. 1TB

Verder heb ik nog een Windows 7-server met de volgende specs:

- Atom 330

- 4GB RAM

- Areca ARC-1280

- 4x Western Digital WD20EARS 2TB in raid 5

- 4x Seagate Barracuda LP 1,5TB in raid 5

- 4x Western Digital Caviar RE2 500GB in raid 5

- Chenbro-behuizing met twaalf 3,5 inch hotswap bays

- Unieke datagebruik ca. 1,7TB en 2x backup van al mijn data (van server en workstation)

De bovenstaande hardware staat ergens in het oosten van het land. Sinds een half jaar overnacht ik in Utrecht op de dagen dat ik op ons kantoor werk in Amsterdam. 's Avonds maak ik dan gebruik van een MacBook Air. Momenteel kan ik op die dagen niet bij mijn data tenzij ik het vooraf gekopieerd heb. Het zou handig zijn al ik altijd bij mijn data kan.

De prestaties van de file shares op de server zijn erg ruk. Ik haal hooguit 40MB/s bij het maken van backups (maar vaak veel minder) terwijl er aan beide kanten opslag met dikke raid-arrays wordt gebruikt. De scheduling van de Areca zorgt er regelmatig voor dat reads lang uitgesteld worden als er veel writes op een array plaatsvinden. Dit is nogal irritant. Ik heb een tijdje Ubuntu gedraaid op de server maar dat presteerde nog slechter dan Windows. Ik heb dus een hoop dure en dubbele hardware (in workstation en server) die maar matig presteert. Ik heb liever een eenvoudiger opstelling waarin de opslag is gecentraliseerd in een SAN en slimme caching ervoor zorgt dat ik met goedkope laagtoerige harde schijven en simpele sata-controllers uitkan. Dat zou mogelijk moeten zijn met ZFS.

Wat betreft prestaties wil ik iets dat vergelijkbaar is met direct attached storage. Ik wil een pijp van zeker 400MB/s tussen de Mac Pro en de storage server en opslag met lage latencies. De beste oplossingen hiervoor lijken fibre channel over iSCSI over 10Gb ethernet. In beide gevallen wil ik point-to-point verbindingen gebruiken zodat ik geen dure switches nodig heb. 10GbE kost zo'n 350 euro per adapter. Dual channel 4Gb fibre channel is wat duurder dan 10GbE maar heeft niet de overhead van iSCSI. Ik heb alleen geen flauw idee of 'link aggregation' of hoe het ook heet bij FC gaat werken met p2p-verbindingen van twee poorten? Op dit moment heb ik nog de ballen verstand van fibre channel, ZFS en OpenSolaris maar ik begreep dat je een ZFS-volume met behulp van Comstar toegankelijk kunt maken als een fibre channel of iSCSI LUN. Het zou handig zijn als beide mogelijk is zodat ik hetzelfde volume kan mounten op de MacBook Air via een software iSCSI-initiator. Het zou helemaal leuk zijn als dit mogelijk is vanaf elke plek op de wereld waar een internetverbinding beschikbaar is.

De Mac Pro is een 2,8GHz quad-core basisconfiguratie die ik wil voldouwen met RAM en verder kaal wil houden. Voor zover ik begrepen heb is het met de dual 4Gb fibre channel adapter van Apple mogelijk om te booten vanaf een FC LUN. Dit zou leuk zijn want dan heb ik geen boot-ssd nodig in de Mac Pro.

Voor de server denk ik aan een Core i5-mobo met 16GB RAM en zes sata-poorten. De Areca ARC-1280 gaat eruit vanwege zijn hoge energieverbruik (20-25 watt). Ik heb nog een ARC-1680 liggen waarop ik de harde schijven in pass-through modus zou kunnen gebruiken. Ik kom dan in totaal op 14 poorten. Hier wil ik acht 2TB harde schijven op aansluiten verdeeld over twee raid-z pools, één voor de primaire data en de andere voor backups. De vijf Vertexen (in totaal 150GB) zou ik als L2ARC kunnen gebruiken. Voor de ZIL heb ik eventueel dan nog een veiliger ssd nodig met een supercapacitor.

Vragen die ik zoal heb:

- Welk besturingsssysteem? OpenSolaris?

- Hoe gaat fibre channel link aggregation in zijn werk bij een p2p-verbinding?

- Kan ik hetzelfde volume toegankelijk maken via FC en iSCSI? (voor de duidelijkheid: gelijktijdig gebruik is niet van toepassing)

- Kan ik prestaties verwachten die vergelijkbaar zijn met die van direct attached storage in raid?

- Wat doe ik met de boot-drive in de server? Kan booten vanaf de ssd's die ook in de L2ARC worden gebruikt of kan ik beter aparte drives gebruiken (kost sata-poorten)

/u/1/femme.png?f=community)

:strip_icc():strip_exif()/u/317788/EpicMealTimeLogo.jpg?f=community)

:strip_icc():strip_exif()/u/159609/caffeine_is_the_shit_60x60.shkl.jpg?f=community)

/u/1176/crop635f8931b2b68_cropped.png?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/45193/voodooless_small.png?f=community)

:strip_icc():strip_exif()/u/10689/camino.jpg?f=community)

:strip_icc():strip_exif()/u/2652/eend.jpeg?f=community)

:strip_exif()/u/38813/holland.gif?f=community)

:strip_icc():strip_exif()/u/22092/crop5fa8360e95568_cropped.jpeg?f=community)