Heb jij de fanwall met de 80mm of de 120mm fans? Bij de 80mm zit de opening in de fanwall voor de kabel direct in het midden, bij de 120mm niet en dit veroorzaakt de problemen. Indien de opening in het midden zou zitten hoeven je kabels vanaf je backplanes ook geen aparte bocht te maken

ik heb de 120mm variant. Ik heb wel de fans aan de kant van het moederbord zitten en de schroefgaten van de behuizing gebruikt die de grootste afstand tot de back planes geeft.

ja ik heb bij mijn norco de fans ook aan de mainboard kant zitten (3x 120mm fan wall)

de rivier fan wall zaten ook nog van die extra dikke 120mm fans tussen, vervangen voor noctua fans en aan twee kant een ijzeren plaat.

https://ri-vier.eu/index....ckmount/RV4324_10_LRG.jpg

de rivier fan wall zaten ook nog van die extra dikke 120mm fans tussen, vervangen voor noctua fans en aan twee kant een ijzeren plaat.

https://ri-vier.eu/index....ckmount/RV4324_10_LRG.jpg

[ Voor 25% gewijzigd door thalantis op 16-08-2013 14:35 ]

Ook hier een slechte foto:

Zit met een 120mm fanwall, ventilatoren aan de kan van de hard drive cages.

De kabels maken wel een 90 graden bocht, maar dit gaat eigenlijk vrij goed.

Ik zal ook eens zorgen voor betere foto's.

Zit met een 120mm fanwall, ventilatoren aan de kan van de hard drive cages.

De kabels maken wel een 90 graden bocht, maar dit gaat eigenlijk vrij goed.

Ik zal ook eens zorgen voor betere foto's.

Wellicht dat SAS8087 kabels met een hoek uitkomst bieden? Iemand daar ervaringen mee?

* Heeft net normale SAS8087 kabels besteld... *

Server 1: Intel N305 | 48GB RAM | 5*4TB NVME | 4x 2.5GbE

Server 2: Intel N5105 | 64GB RAM | 1TB NVME | 4x 2.5GbE

Server 3: Intel Xeon E5-2670 | 128GB RAM | 512+750GB SATA SSD | 6x10TB HDD | 6x 1GbE [Buiten gebruik]

de kabels passen wel maar het is wel krap.

mijn areca 1882ix-24 is DOA en terug naar azerty, geen post scherm meer van de kaart ook niet in mijn backup server.

mijn areca 1882ix-24 is DOA en terug naar azerty, geen post scherm meer van de kaart ook niet in mijn backup server.

Dei kabels zouden het wel oplossen. Alles zit er nu wel al een tijdje aangesloten, maar erg handig was het niet. Het probleem voornamelijk was, dat het gehele zwarte beginstuk van de kabel (zoals je ook in de foto ziet) zogoed als niet buigbaar is. Misschien dat ik ze nog wel eens ga vervangeb door deze.thof schreef op zaterdag 17 augustus 2013 @ 22:36:

[afbeelding]

Wellicht dat SAS8087 kabels met een hoek uitkomst bieden? Iemand daar ervaringen mee?

* Heeft net normale SAS8087 kabels besteld... *

Ik heb de zwarte krimpkous afgesneden want anders kreeg ik de bocht niet gemaakt in mijn Norco 2U.

Heeft iemand toevallig een idee waar je in NL deze haakse kabels zou kunnen krijgen?

Ik heb sinds kort een Norco 4216 (nu nog maar met 4 disks erin, wordt tzt uitgebreid), maar zoals al eerder gezegd, zijn de gewone sas kabels niet erg optimaal.

met een stukje minder krimpkous (knip knip) is het wel te doen, maar niet ideaal.

Zo'n kabel zou erg fijn zijn.

Alvast bedankt!

Ik heb sinds kort een Norco 4216 (nu nog maar met 4 disks erin, wordt tzt uitgebreid), maar zoals al eerder gezegd, zijn de gewone sas kabels niet erg optimaal.

met een stukje minder krimpkous (knip knip) is het wel te doen, maar niet ideaal.

Zo'n kabel zou erg fijn zijn.

Alvast bedankt!

nog even wat melden over mijn rivier RV4324-03A 4u kast, de schijf blijfen veel koeler hier in dan in mijn norco-4224, in beide kasten heb ik een fan wall van 3x noctua fans en aan de achterkant 2x noctua 80mm fans.

De oorzaak heb ik achterhaald, de disk trays zijn veel meer open in de rivier kast dan in de norco, ik heb de trays van de norco eruit gehaald en eens bekeken en ik zag dat deze veel meer dicht waren aan de voorkant, ik ben aan het hobby-en geweest en met een kleine schroeve draaier heb ik aan de achter kant van het plastic klepje op verschillende plekken wat plastic strookjes weggehaald.

Het resultaat is verbluffend, scheelt zo 15 graden met mijn hitachi schijven.

Misschien een tip voor de mede norco-4224 eigenaren die dit ook aandurven

De oorzaak heb ik achterhaald, de disk trays zijn veel meer open in de rivier kast dan in de norco, ik heb de trays van de norco eruit gehaald en eens bekeken en ik zag dat deze veel meer dicht waren aan de voorkant, ik ben aan het hobby-en geweest en met een kleine schroeve draaier heb ik aan de achter kant van het plastic klepje op verschillende plekken wat plastic strookjes weggehaald.

Het resultaat is verbluffend, scheelt zo 15 graden met mijn hitachi schijven.

Misschien een tip voor de mede norco-4224 eigenaren die dit ook aandurven

Interessant, kun je eventueel een foto maken?

Als ik thuis ben zal ik een tray eruit trekken en nog eens kijken.

Er was wel informatie te vinden dat je de norco trays open kunt schuiven en dat ze standaard dicht stonden, en dus als je een hdd plaats je hem open moet zetten om dan koeling te krijgen.

Die mogelijkheid is er bij mijn 4220 niet, of ik heb het niet kunnen vinden...

Als ik thuis ben zal ik een tray eruit trekken en nog eens kijken.

Er was wel informatie te vinden dat je de norco trays open kunt schuiven en dat ze standaard dicht stonden, en dus als je een hdd plaats je hem open moet zetten om dan koeling te krijgen.

Die mogelijkheid is er bij mijn 4220 niet, of ik heb het niet kunnen vinden...

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

ja dat open schuiven wist ik, die stonden allemaal open

norco

ri-vier

norco

ri-vier

[ Voor 51% gewijzigd door thalantis op 02-09-2013 13:20 ]

http://www.supermicro.com...847/SC847DE16-R1K28LP.cfm

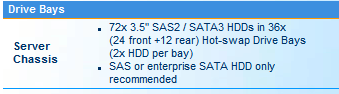

Super Micro chassis met ruimte voor 72 x 3.5" disks.

Hier zou dus 72 x 4 TB = 288 ruwe TB aan capaciteit in kunnen. Met vier doosjes heb je dan een ruime petabyte.

Super Micro chassis met ruimte voor 72 x 3.5" disks.

Hier zou dus 72 x 4 TB = 288 ruwe TB aan capaciteit in kunnen. Met vier doosjes heb je dan een ruime petabyte.

Voor de mensen die nu ZFS of Linux MDADM gebruiken + kasten met backplanes: hoe wordt dat nu aangesloten?

Die ri-vier case heeft 6 sas expanders met 4 disks. Hoeveel controllers heb je dan nodig, 3 x 8 poorts? waarbij die controllers per stuk 2x SFF 8087 doen?

Ik ben stiekem hier een beetje naar aan het kijken:

Het enige wat nog mist is de Ri-vier case. Bij elkaar is dat dan max ~5K.

Dit lijkt me prima voor een simpele ZFS storage server op basis van Linux. Ik doe niets met solid state caches want dat gebruik ik waarschijnlijk toch niet. En anders kan dat altijd later nog, poorten genoeg.

Er mist ook nog klein grut zoals SAS kabels (indien nodig) en stroom kabels voor de HDDs.

Die ri-vier case heeft 6 sas expanders met 4 disks. Hoeveel controllers heb je dan nodig, 3 x 8 poorts? waarbij die controllers per stuk 2x SFF 8087 doen?

Ik ben stiekem hier een beetje naar aan het kijken:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i3 3220 Boxed | € 102,90 | € 102,90 |

| 1 | Supermicro X9SCM-F | € 163,60 | € 163,60 |

| 24 | Hitachi Deskstar 5K4000, 4TB | € 149,94 | € 3.598,56 |

| 2 | Hitachi Travelstar Z7K320, 250GB SATA-300, 16MB, 7200rpm | € 43,96 | € 87,92 |

| 1 | Kingston ValueRAM KVR1333D3E9SK2/8G | € 84,36 | € 84,36 |

| 3 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 118,58 | € 355,74 |

| 1 | Corsair HX850W | € 130,- | € 130,- |

| Bekijk collectie Importeer producten | Totaal | € 4.523,08 | |

Het enige wat nog mist is de Ri-vier case. Bij elkaar is dat dan max ~5K.

Dit lijkt me prima voor een simpele ZFS storage server op basis van Linux. Ik doe niets met solid state caches want dat gebruik ik waarschijnlijk toch niet. En anders kan dat altijd later nog, poorten genoeg.

Er mist ook nog klein grut zoals SAS kabels (indien nodig) en stroom kabels voor de HDDs.

[ Voor 255% gewijzigd door Q op 02-09-2013 23:49 ]

blijkbaar zijn er meerdere versies van de Norco kasten.thalantis schreef op maandag 02 september 2013 @ 11:41:

ja dat open schuiven wist ik, die stonden allemaal open

Ik heb een frontje van een tray afgeschroefd, en daar zit helemaal geen schuifje of iets dergelijks in.

Het enige wat ik zou kunnen doen is uit de plastic handle die je gebruikt om de tray los te maken, de zwarte strookjes eruit te halen. Ik vermoed ook dat je dat gedaan hebt.

Neemt het geluids niveau niet enorm toe ? Het is nu min of meer een constructie dat het geluid niet rechtdoor kan.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

SFF-8087 kabel in de M1015, andere eind op de backplane, 1 connector zijn 4 drives. Voor 24 drives heb je dan 3 m1015 kaarten nodig.Q schreef op maandag 02 september 2013 @ 22:16:

Voor de mensen die nu ZFS of Linux MDADM gebruiken + kasten met backplanes: hoe wordt dat nu aangesloten?

Die ri-vier case heeft 6 sas expanders met 4 disks. Hoeveel controllers heb je dan nodig, 3 x 8 poorts? waarbij die controllers per stuk 2x SFF 8087 doen?

In een supermicro X9SCM-F heb je 2x een x8 PCI-E (of 2.0 of 3.0 afhankelijk van de processor) en 2x een x4 PCI-E (in een X8 slot in PCI-E 2.0)

Het werkt goed met een Xeon E3-1220, maar met een i3-2100 werd soms de 3e controller niet geinitialiseerd leek het.

Die Xeon E3 heeft 20 PCI-E lanes, die I3 kon er wel eens maar 16 hebben.

Een M1015 werkt in een X8 en in een X4 slot.

Volgens mij zit er op die supermicro borden de sloten 1 t/m 3 (vanaf de processor gezien op de CPU aangesloten, en dan slot 4 op de C204 chip (x4 voor PCI-E slot 4, en x4 voor perphials zoals GBE etc. = 8 PCI-E Lanes in totaal)

Dus als je 1,2,3 gebruikt krijg je (electrisch) X8, X4, X4 om het te laten werken.

Als je 1,2,4 gebruikt krijg je X8 X8 X4

Zie een overzicht: http://www.intel.com/cont.../server-chipset-c202.html

Verder zou Ik liever een X9SCM-FII nemen, die heeft 2 maal intel 82574L en de X9SCM-F heeft 82579LM and 82574L. De 82574L heeft betere support onder diverse OS.

[ Voor 7% gewijzigd door jacovn op 03-09-2013 09:49 . Reden: details C204 chipset. ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

ja die kleine zwarte strookjes heb ik er uit gehaald, het geluid is niet meer geworden aangezien ik noctua fans gebruik plus een water koeling set op mijn cpu (corsair h80i)jacovn schreef op dinsdag 03 september 2013 @ 06:57:

[...]

blijkbaar zijn er meerdere versies van de Norco kasten.

Ik heb een frontje van een tray afgeschroefd, en daar zit helemaal geen schuifje of iets dergelijks in.

Het enige wat ik zou kunnen doen is uit de plastic handle die je gebruikt om de tray los te maken, de zwarte strookjes eruit te halen. Ik vermoed ook dat je dat gedaan hebt.

Neemt het geluids niveau niet enorm toe ? Het is nu min of meer een constructie dat het geluid niet rechtdoor kan.

in de beschrijving staat 24 front en 12 back = 36 waar zijn die andere 36 danQ schreef op maandag 02 september 2013 @ 21:54:

http://www.supermicro.com...847/SC847DE16-R1K28LP.cfm

Super Micro chassis met ruimte voor 72 x 3.5" disks.

[afbeelding]

Hier zou dus 72 x 4 TB = 288 ruwe TB aan capaciteit in kunnen. Met vier doosjes heb je dan een ruime petabyte.

Hoe zeggen ze dat? "Lezen is ook een kunst."thalantis schreef op dinsdag 03 september 2013 @ 08:12:

in de beschrijving staat 24 front en 12 back = 36 waar zijn die andere 36 dan

edit: Deveon, het scheelde echt maar een seconde of zo.

[ Voor 9% gewijzigd door RuddyMysterious op 03-09-2013 08:24 ]

DevilsProphet was sneller

[ Voor 95% gewijzigd door Deveon op 03-09-2013 08:17 ]

Best onhandig als je 1 disk wil vervangen, trek je er altijd 2 disken uit...

Even niets...

tijd voor koffie, ach het zijn hot-swap bays dus dat maakt niet uit.

zal wel heel veel warmte geven denk ik

zal wel heel veel warmte geven denk ik

FireDrunk schreef op dinsdag 03 september 2013 @ 08:19:

Best onhandig als je 1 disk wil vervangen, trek je er altijd 2 disken uit...

Ja, want als je er een disk "hot" uittrekt dan heeft dit geen gevolgen voor je array, zeker?thalantis schreef op dinsdag 03 september 2013 @ 08:20:

ach het zijn hot-swap bays dus dat maakt niet uit.

In een RAID10 or alike (met stripes) kan je op zich wel zorgen dat je stripes daar bij elkaar zitten in paren van twee per bay.

[ Voor 12% gewijzigd door gertvdijk op 03-09-2013 08:48 ]

Kia e-Niro 2021 64kWh DynamicPlusLine. 3x Victron MP-II op 15kWh US5000 3f thuisbatterij met 3x25A→3x40A PowerAssist, Victron EVCS, 3200Wp HoyMiles zp. my GitHub, my blog

Ik denk dat ik deze post even in de start post link.[b]jacovn schreef op dinsdag 03 september 2013 @ 07:14:[

SFF-8087 kabel in de M1015.....

Bedankt voor de toelichting en de tips.

Verzoek om componenten advies voor in de startpost

Het lijkt mij nuttig om een overzicht te maken van de meest gebruikte componenten voor big-ass storage.1. CPU

2. RAM

3. Moederbord

4. Controller

5. Disk

6. Case

7. PSU

Ik wil een mooie tabel per type product maken met plaatje van het product zodat mensen die zelf iets willen bouwen daar baat bij hebben.

Ik zou het waarderen als er wat reacties komen want ik weet ook niet alles.

Echter, zomaar wat producten droppen heeft geen waarde voor mensen. Er moeten goede redenen zijn waarom dit product zo geschikt is om bad-ass storage mee te bouwen. Dan kunnen mensen zelf de juiste componenten uitkiezen.

Voorbeeldje van wat ik wil maken:

| Moederborden | ||||||

| Vendor | Product | Socket | Max Memory | ECC | PCIe slots | Motivatie |

| SuperMicro | X9SCM-F | LGA 1155 | 32 GB | Ja | 4 (2x8 + 2x4) | Goedkoop bord met ECC en 4 PCI sloten voor meerdere controllers. |

Ik verwacht niet dat mensen nu al die info aanleveren, maar componenten + motivatie is denk ik wel waardevol. Dus noem een product (liefst met link) en waarom dit nuttig is voor de big-storage bouwers.

Het lijkt mij wel een leuk idee. Omdat ik zelf stiekem een beetje om mij heen aan het kijken ben voor een nieuwe build merk ik dat je al die info overal vandaan moet harken. Dat is best zonde.

[ Voor 160% gewijzigd door Q op 03-09-2013 21:18 ]

Kingston Valueram met een LSI2008 gebaseerde HBA is een mooi begin, processorsnelheid is vaak niet zo van belang. Een kansloze i3 is voor doorvoersnelheden tot 1GB/s meer dan voldoende, maar mist voor sommige opstellingen de benodigde pci-lanes of geheugenondersteuning.

Ik denk niet dat je, op de HBA na, een nuttlige lijst gaat krijgen, de diversiteit aan wensen zorgt er voor dat we allemaal wat anders in huis hebben staan.

Ik denk niet dat je, op de HBA na, een nuttlige lijst gaat krijgen, de diversiteit aan wensen zorgt er voor dat we allemaal wat anders in huis hebben staan.

Ik denk dat je big ass storage beter naar een XEON E5 kunt gaan, en dan een bord met 4 of 5 PCI-E x8 sloten.

Die ondersteunen ook meer dan 32 GB ram, wat voor ZFS wellicht handig is.

Wat voor een overzicht wellicht handig is, is denk ik informatie over CPU's.

Voor socket 1155 heb je nu dan Gserie, i3 en xeon E3.

Het prijs verschil is aanzienlijk, van 75 naar 115 naar 200 euro ruwweg voor de instapper van de serie.

Mijn motivatie voor de xeons was het nummer pci-e lanes.

I3 heeft er 16

E3 heeft er 20

Ik dacht 3 stuks m1015 nodig te hebben, en een x520da2.

Dat zijn dan 4 kaarten die een x8 slot aanraden, maar wel op x4 werken.

Ik draai nu in 2 servers met 2 stuks m1015 en een x520-da2. De m1015 in een x8 slot, en de x520 in een x4 slot. (Supermicro x9scm-fii met een E3-1220, en een x9sae-f met een E3-1265lv2)

De beide servers zijn bedoeld voor 2 pools van 10 hdds in raid-z2

8 drives van een pool op een m1015, en 2 op een sata-300 aansluiting onboard.

Dit werkt prima en ik heb de 3e m1015 dus niet nodig. Dit werkte niet met een i3, de 3e m1015 starte niet altijd goed op. Met een E3 wel, maar omdat het ook zo werkt heb ik het maar zo gelaten.

Die ondersteunen ook meer dan 32 GB ram, wat voor ZFS wellicht handig is.

Wat voor een overzicht wellicht handig is, is denk ik informatie over CPU's.

Voor socket 1155 heb je nu dan Gserie, i3 en xeon E3.

Het prijs verschil is aanzienlijk, van 75 naar 115 naar 200 euro ruwweg voor de instapper van de serie.

Mijn motivatie voor de xeons was het nummer pci-e lanes.

I3 heeft er 16

E3 heeft er 20

Ik dacht 3 stuks m1015 nodig te hebben, en een x520da2.

Dat zijn dan 4 kaarten die een x8 slot aanraden, maar wel op x4 werken.

Ik draai nu in 2 servers met 2 stuks m1015 en een x520-da2. De m1015 in een x8 slot, en de x520 in een x4 slot. (Supermicro x9scm-fii met een E3-1220, en een x9sae-f met een E3-1265lv2)

De beide servers zijn bedoeld voor 2 pools van 10 hdds in raid-z2

8 drives van een pool op een m1015, en 2 op een sata-300 aansluiting onboard.

Dit werkt prima en ik heb de 3e m1015 dus niet nodig. Dit werkte niet met een i3, de 3e m1015 starte niet altijd goed op. Met een E3 wel, maar omdat het ook zo werkt heb ik het maar zo gelaten.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Persoonlijk heb ik alles aan één controller met SAS expander hangen.Het 1155 platform volstaat dan. Performance is dan ergens beperkt maar ik ervaar in mijn eigen setup geen gemis aan snelheid. Real-life kopieer snelheden zitten rond de 300MB/s bij volumes van 6 disks.jacovn schreef op dinsdag 03 september 2013 @ 22:23:

Ik denk dat je big ass storage beter naar een XEON E5 kunt gaan, en dan een bord met 4 of 5 PCI-E x8 sloten.

Ik heb de boel nu wel zo ingericht dat ik nauwelijks grote bestanden van / naar de fileserver kopieer.In feite blijven de grote bestanden (rips / downloads) binnen mijn fileserver waar ik wel van volume naar volume verplaats.

Als ik het zo zie is een x520da2 best een dure LAN kaart, waarom zou je die willen?

De huidige lijn Core i3 en last gen Xeon lijn is wel handig om op te nemen.

Leuke dual of quad port nic voor bonding/teaming / iscsi multipathing maar wie gebruikt dat?

@Jacov: wat voor OS is dat, BSD of Linux?

De huidige lijn Core i3 en last gen Xeon lijn is wel handig om op te nemen.

Leuke dual of quad port nic voor bonding/teaming / iscsi multipathing maar wie gebruikt dat?

@Jacov: wat voor OS is dat, BSD of Linux?

[ Voor 7% gewijzigd door Q op 04-09-2013 00:38 ]

Rond de 300 euro op ebay inclusief shipping (UK)Q schreef op woensdag 04 september 2013 @ 00:38:

Als ik het zo zie is een x520da2 best een dure LAN kaart, waarom zou je die willen?

Ik heb een poging gedaan met link aggregation (802.3ad) tussen een Windows 7 source PC en FreeBSD servers. Ik had een 4 port GE (PCI-E 1.0) kaart en een 2 poort GE (PCI-E 2.0) via ebay gekocht, en dat kreeg ik functioneel wel werkend (1 kant actief en andere kant passief op de switch)

Maar standaard krijg je er 1 sessie door. Onder linux bijvoorbeeld kun je wel een balancing mode instellen, maar op wintel niet zo makkelijk.

Dus toen maar voor 10GE gekozen, ik werk daar ook mee, en je hoeft weinig te tweaken, of in te stellen.

Ik haal bij lange na de performance niet die de netwerklaag zou kunnen, maar dat is dus niet de limiet..

Als je meer dan 1 source hebt is het denk ik een betaalbare oplossing. Maar 1:1 communicatie is minder makkelijk te implementeren.Leuke dual of quad port nic voor bonding/teaming / iscsi multipathing maar wie gebruikt dat?

Windows 7 op de source kant.@Jacov: wat voor OS is dat, BSD of Linux?

FreeBSD op de servers.

[ Voor 9% gewijzigd door jacovn op 04-09-2013 09:02 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Zolang de NIC en de switch een vorm van 'switch assisted link aggregation' ondersteunen werkt het ook met 1 'stream'.jacovn schreef op woensdag 04 september 2013 @ 09:00:

[...]Als je meer dan 1 source hebt is het denk ik een betaalbare oplossing. Maar 1:1 communicatie is minder makkelijk te implementeren.

Ik heb al meerdere Windows 4Gbps aggregated links gebruikt waar je voor RX en TX de volle 4Gbps per sessie krijgt. Dit op 4x1 poort, 2x2 poort en 1x4 poort NIC's.

Blijft overeind dat een 10Gbps oplossing veel makkelijker is natuurlijk. In mijn geval ging het om redundantie via multi path links.

Beetje offtopic maar interessant:

Onder windows 4GB agregrated links om 1x 4Gbit te halen vereisen neem ik aan specifieke vendor drivers?

Werkt dat tussen kaarten van verschillende leveranciers en gebruik je dan ook 802.3ad/ax?

Onder linux met bonding heb ik met 2 nics ook gewoon prima 2gbit via round-robin, maar dat werkt dus alleen tussen linux hosts. Dit via reguliere intel nics (niet zo prijzig).

Onder windows 4GB agregrated links om 1x 4Gbit te halen vereisen neem ik aan specifieke vendor drivers?

Werkt dat tussen kaarten van verschillende leveranciers en gebruik je dan ook 802.3ad/ax?

Onder linux met bonding heb ik met 2 nics ook gewoon prima 2gbit via round-robin, maar dat werkt dus alleen tussen linux hosts. Dit via reguliere intel nics (niet zo prijzig).

[ Voor 34% gewijzigd door Q op 04-09-2013 11:39 ]

Ligt er aan, wil je echt netwerk trunken, of wil je multi pathing doen met bijvoorbeeld iSCSI?

[ Voor 13% gewijzigd door FireDrunk op 04-09-2013 11:47 ]

Even niets...

Ik heb link aggregation gebruikt met EtherChannel, 802.1ad en 802.1ax. EtherChannel is het 'makkelijkst' te gebruiken om de bandbreedte te vergroten zeker in combinatie met meerdere switches en ISL. Met 802.1ad/ax kun je een heel eind komen met de juiste spullen. Maar dit is veel meer software afhankelijk (NIC drivers, OS en switch firmware) heb ik gemerkt.Q schreef op woensdag 04 september 2013 @ 11:38:

Beetje offtopic maar interessant:

Onder windows 4GB agregrated links om 1x 4Gbit te halen vereisen neem ik aan specifieke vendor drivers?

Werkt dat tussen kaarten van verschillende leveranciers en gebruik je dan ook 802.3ad/ax?

Onder linux met bonding heb ik met 2 nics ook gewoon prima 2gbit via round-robin, maar dat werkt dus alleen tussen linux hosts. Dit via reguliere intel nics (niet zo prijzig).

Om met een quote van de IEEE te eindigen: 'LAG is good, but it’s not as good as a fatter pipe'.

Multipath iscsi werkt prima (behalve gedonder met MPIO onder windows en een G3 MSA P2000) maar gewoon data copien met NFS of SAMBA met meer dan gigabit is soms lastig. Linux bonding werkt.

Maar je zit gewoon met het punt dat 802.1a[d|x} bedoeld is voor meerdere clients en niet voor single stream high-performance.

Je ziet het ook in VMware die zijn eigen software stack heeft om bijvoorbeeld (storage)vmotion te stripen over meerdere NICS.

Er gaat niets boven 10Gbit, maar volgens mij is dat nog steeds prijzig als in 500+ per nic. Dat wordt echt te gek. Het is daarom leuk om bijvoorbeeld ook iets op te nemen over infiniband oid.

Maar je zit gewoon met het punt dat 802.1a[d|x} bedoeld is voor meerdere clients en niet voor single stream high-performance.

Je ziet het ook in VMware die zijn eigen software stack heeft om bijvoorbeeld (storage)vmotion te stripen over meerdere NICS.

Er gaat niets boven 10Gbit, maar volgens mij is dat nog steeds prijzig als in 500+ per nic. Dat wordt echt te gek. Het is daarom leuk om bijvoorbeeld ook iets op te nemen over infiniband oid.

10GbE heeft wel als voordeel dat de latency veel kleiner is. Trunking/ aggregation gaat je dus alleen in bandbreedte helpen, en niet in IOPS. Dus als het om IOPS gaat is 10Gb the way to go.

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Destijds had ik deze: http://www.ebay.co.uk/itm...geName=ADME:X:RTQ:GB:1123Q schreef op woensdag 04 september 2013 @ 15:38:

Er gaat niets boven 10Gbit, maar volgens mij is dat nog steeds prijzig als in 500+ per nic. Dat wordt echt te gek. Het is daarom leuk om bijvoorbeeld ook iets op te nemen over infiniband oid.

228 uk pond.

SFP+ Direct attach koper kabels waren iets van 60 euro.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Als de trunking door hardware gedaan word, maakt het qua latency toch niet uit?u_nix_we_all schreef op woensdag 04 september 2013 @ 15:40:

10GbE heeft wel als voordeel dat de latency veel kleiner is. Trunking/ aggregation gaat je dus alleen in bandbreedte helpen, en niet in IOPS. Dus als het om IOPS gaat is 10Gb the way to go.

In software wel denk ik, maar als je goede Cisco hardware hebt ofzo, zal het verschil minimaal zijn?

[ Voor 11% gewijzigd door FireDrunk op 04-09-2013 16:47 ]

Even niets...

Jawel, je hebt te maken met "linespeed" , soort van klokfrequentie van het ethernetsignaal dat verstuurd wordt. Met IO van disken zul je daar wellicht nog niet veel van merken, maar systemen die heel veel IOPS moeten doen (en daarvoor bijv. een ZEUS-Ramdrive gebruiken) telt het merkbaar mee.FireDrunk schreef op woensdag 04 september 2013 @ 16:46:

[...]

Als de trunking door hardware gedaan word, maakt het qua latency toch niet uit?

In software wel denk ik, maar als je goede Cisco hardware hebt ofzo, zal het verschil minimaal zijn?

Edit: hier iemand die wat testjes gedaan heeft.

[ Voor 12% gewijzigd door u_nix_we_all op 04-09-2013 17:18 ]

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Dat is het verschil tussen 1Gb en 10Gb, maar dat zegt niets over trunken.

Tuurlijk is de latency van 10Gb iets lager, maar met port trunken heb je meer bandbreedte dan een enkele 1Gb lijn.

Het gaat om de relatieve prijs per IOP als je 1Gb, 1Gb Trunks, FC en 10Gb naast elkaar zet.

Dan denk ik dat port trunking nog redelijk goed uit de bus komt.

Het allersnelst qua IOPS is InifiniBand. Met zijn RDMA en SRP protocollen is dat gewoon heer en meester...

Tuurlijk is de latency van 10Gb iets lager, maar met port trunken heb je meer bandbreedte dan een enkele 1Gb lijn.

Het gaat om de relatieve prijs per IOP als je 1Gb, 1Gb Trunks, FC en 10Gb naast elkaar zet.

Dan denk ik dat port trunking nog redelijk goed uit de bus komt.

Het allersnelst qua IOPS is InifiniBand. Met zijn RDMA en SRP protocollen is dat gewoon heer en meester...

Even niets...

Helemaal mee eens. Mijn punt is dat met port trunking je latency hetzelfde blijft als met een enkele gigabit lijn. En dat je limiet voor IOPS met 1 Gbit hetzelfde is als die bij bijv. 4x 1 Gbit.FireDrunk schreef op woensdag 04 september 2013 @ 18:00:

Dat is het verschil tussen 1Gb en 10Gb, maar dat zegt niets over trunken.

Tuurlijk is de latency van 10Gb iets lager, maar met port trunken heb je meer bandbreedte dan een enkele 1Gb lijn.

Het gaat om de relatieve prijs per IOP als je 1Gb, 1Gb Trunks, FC en 10Gb naast elkaar zet.

Dan denk ik dat port trunking nog redelijk goed uit de bus komt.

Het allersnelst qua IOPS is InifiniBand. Met zijn RDMA en SRP protocollen is dat gewoon heer en meester...

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Die beredenering snap ik niet, dat geld alleen maar met een q=1 (ofwel synced writes) load.

Maar als je een diepere queue toestaat, kan je toch gewoon 1 request over elk van de 2 (of meer) poten van een trunk tegelijk sturen?

Ja je hebt dan 2 keer de latency, maar die doorloop je tegelijkertijd om het zo maar even te noemen.

Maar als je een diepere queue toestaat, kan je toch gewoon 1 request over elk van de 2 (of meer) poten van een trunk tegelijk sturen?

Ja je hebt dan 2 keer de latency, maar die doorloop je tegelijkertijd om het zo maar even te noemen.

Even niets...

Hmm, als je het zo bekijkt..... klinkt het ook logisch. Ik moet dat nodig nog eens doornemen met mijn collega engineer die daarmee kwam, want nu twijfel ik ook .....FireDrunk schreef op woensdag 04 september 2013 @ 19:36:

Die beredenering snap ik niet, dat geld alleen maar met een q=1 (ofwel synced writes) load.

Maar als je een diepere queue toestaat, kan je toch gewoon 1 request over elk van de 2 (of meer) poten van een trunk tegelijk sturen?

Ja je hebt dan 2 keer de latency, maar die doorloop je tegelijkertijd om het zo maar even te noemen.

You don't need a parachute to go skydiving. You need a parachute to go skydiving twice.

Ik ben vrij zeker dat dit klopt. De latency bij 1 Gbit is altijd gelijk maar bij 4x1GB trunked kun je dus 4 iops parallel afhandelen en dat betekent dat bij queuedept=1 tm queuedepth=4 gelijke latency zou moeten houden voor alle iops. Ga je naar bijv queudepth = 16 dan neemt de latency natuurlijk toe, maar minder dan bij een enkele link.FireDrunk schreef op woensdag 04 september 2013 @ 19:36:

Die beredenering snap ik niet, dat geld alleen maar met een q=1 (ofwel synced writes) load.

Maar als je een diepere queue toestaat, kan je toch gewoon 1 request over elk van de 2 (of meer) poten van een trunk tegelijk sturen?

Ja je hebt dan 2 keer de latency, maar die doorloop je tegelijkertijd om het zo maar even te noemen.

....lijkt mij.

In de praktijk denk ik dat je storage device de bottleneck is. Mogelijk dat SSDs of RAM drives zo snel zijn dat de 'beperking' van gigabit latency mee gaat rekenen.

Voor de meeste mensen in dit topic geldt echter dat latency het minste van je problemen zal zijn, behalve voor diegene die VMs oid draaien vanaf hun storage.

[ Voor 7% gewijzigd door Q op 05-09-2013 00:22 ]

Ja natuurlijk, maar als we storage even buiten perspectief laten. Dan zal een 4x1Gb trunk vast niet precies 4x zo snel zijn als een 1Gb trunk. De Trunking logica zal inderdaad wel wat latency kosten.

De vraag is alleen hoeveel

De vraag is alleen hoeveel

Even niets...

802.1ad en ax zijn inderdaad niet gericht op meer bandbreedte voor single MAC links. Dan moet je naar PagP (EtherChannel) kijken i.p.v. LACP (IEEE802.1ad/ax).Q schreef op woensdag 04 september 2013 @ 15:38:

Maar je zit gewoon met het punt dat 802.1a[d|x} bedoeld is voor meerdere clients en niet voor single stream high-performance.

Met PagP kun met je 4x1Gbps NIC aggregated link naar bijvoorbeeld 10Gbps NIC 4 Gbps benaderen.

Toch wel jammer dat er geen betaalbare, snelle en breed ondersteunde oplossing is om voorbij de 1Gbit te komen, OS onafhankelijk. 10gbit + switches = duur.

Ik heb nu dus 2x 2 nics met Linux bonding aan elkaar geknoopt en dat geeft mij over NFS ~200+ MB/s maar dat werkt niet naar non-linux clients toe. Voor mijn doel is het wel prima, namelijk data overpompen van download machine naar storage machine.

Ik weet dat hier mensen succes hadden met infiniband kaartjes, maar hoe het daar nu precies mee staat...

Ik heb nu dus 2x 2 nics met Linux bonding aan elkaar geknoopt en dat geeft mij over NFS ~200+ MB/s maar dat werkt niet naar non-linux clients toe. Voor mijn doel is het wel prima, namelijk data overpompen van download machine naar storage machine.

Ik weet dat hier mensen succes hadden met infiniband kaartjes, maar hoe het daar nu precies mee staat...

Ik zou willen dat er een USB3 point-to-point protocol kwam... Zo moeilijk is dat toch niet denk ik dan...

5Gb is voor veel mensen zat.

5Gb is voor veel mensen zat.

Even niets...

MXC van Intel is erg leuk maar de vraag is of dat een beetje betaalbaar gaat worden:

nieuws: Intel introduceert nieuwe generatie server-Atoms en snelle glasvezelinterconnect

Meer uitleg:

http://slashdot.org/topic...change-from-modest-cable/

maar we gaan misschien iets teveel offtopic

nieuws: Intel introduceert nieuwe generatie server-Atoms en snelle glasvezelinterconnect

Meer uitleg:

http://slashdot.org/topic...change-from-modest-cable/

maar we gaan misschien iets teveel offtopic

[ Voor 12% gewijzigd door Mr_gadget op 09-09-2013 14:25 ]

Infiniband tussen twee linux machines (SRP target) is relatief gemakkelijk opgezet en werkt goed (200 a 250 MB/sec van de download bak naar de storage machine (ZFSonLinux) waarbij de beperkende factor de SSD in de downloadbak is. De beperking van SRP is wel dat het een 'een op een' verbinding is.Q schreef op maandag 09 september 2013 @ 11:40:

Toch wel jammer dat er geen betaalbare, snelle en breed ondersteunde oplossing is om voorbij de 1Gbit te komen, OS onafhankelijk. 10gbit + switches = duur.

Ik heb nu dus 2x 2 nics met Linux bonding aan elkaar geknoopt en dat geeft mij over NFS ~200+ MB/s maar dat werkt niet naar non-linux clients toe. Voor mijn doel is het wel prima, namelijk data overpompen van download machine naar storage machine.

Ik weet dat hier mensen succes hadden met infiniband kaartjes, maar hoe het daar nu precies mee staat...

SMB werkt ook wel maar haalt max. zo'n 175-200 MB/sec en de CPU belasting is voor beide machines flink (linux <->Win7 x64).

NFS onder Windows 7 heb ik destijd wel getest maar aangezien Windows zelf geen paralelle NFS client heeft kwam dat niet verder dan ca 40 MB/sec. Ik heb verder geen andere NFS clients getest.

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

4GB FC kan natuurlijk ook, ik heb nog een hele meuk SFP's en Brocade switches liggen maar dat is niet echt spul wat je thuis even inzet

Ik wacht ook wel totdat 10GB ethernet goedkoper is.

Ik wacht ook wel totdat 10GB ethernet goedkoper is.

Alle proemn in n drek

Ik heb nog 4Gb FC kaartjes in VA staan  Daar kan je dat ook mee doen

Daar kan je dat ook mee doen

Even niets...

Wat is het nadeel: Stroom verbruik, geluidsproductie switch, anders?Bierkameel schreef op dinsdag 10 september 2013 @ 14:46:

4GB FC kan natuurlijk ook, ik heb nog een hele meuk SFP's en Brocade switches liggen maar dat is niet echt spul wat je thuis even inzet

Ik wacht ook wel totdat 10GB ethernet goedkoper is.

2x een Intel X540-T1 10 Gbit kaart kost je 630 euro aardig wat geld, maar is wel de beste oplossing, zeker als je naar de toekomst kijkt.

iSCSI volume voor je game/steam data en de rest/audio/video/docs gewoon via samba. Kan je gewoon af met een kleine SSD als boot in je workstations/PCs. Dus dat geld wat je bespaard aan grotere SSD's kan je in je 10gbit kaart stoppen. ;-)

iSCSI volume voor je game/steam data en de rest/audio/video/docs gewoon via samba. Kan je gewoon af met een kleine SSD als boot in je workstations/PCs. Dus dat geld wat je bespaard aan grotere SSD's kan je in je 10gbit kaart stoppen. ;-)

[ Voor 5% gewijzigd door tHe_BiNk op 10-09-2013 16:14 ]

APPLYitYourself.co.uk - APPLYitYourself.com - PLAKhetzelf.nl - Raamfolie, muurstickers en stickers - WindowDeco.nl Raamfolie op maat.

lijkt mij dat laatste 25 reacties hier off-topic zijn...

nvm

[ Voor 94% gewijzigd door thalantis op 11-09-2013 14:58 ]

Tja, bij 10+ TB servers is een discussie over sneller dan 1GE link wel zinvol.BartNL schreef op dinsdag 10 september 2013 @ 20:06:

lijkt mij dat laatste 25 reacties hier off-topic zijn...

Ik had graag eerder 10 GE gekocht, ik heb 45 TB zitten copieren over een 1GE link, dat had in minder tijd gekund.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

ik heb thuis een hp switchje die lacp ondersteunt en op beide bakken heb ik een dual port lan kaart dan gaat het wel iets sneller maar duurt nog steeds lang ja.

Misschien dat het issue van 1Gb+ niet zo interessant is voor iedereen, maar voor de meeste 10TB+ bouwers is het wel relevant als je TBs aan data moet verplaatsen. Het duurt bij 100 MB/s twee uur drie kwartier om om slechts 1 TB te verplaatsen.

Dit topics is ook nooit bedoeld om sec computers te showen maar ook voor discussie.

Dit topics is ook nooit bedoeld om sec computers te showen maar ook voor discussie.

Lang verwachte update van mijn kant

Bovenstaande server is mijn backup server, ik gebruik deze server als backup van mijn main server.

Server draait windows 2012 R2 , de 20x schijven staan in raid 6.

De asus sabertooth komt uit mijn main server aangezien het mainboard van mijn backup server is overleden, dit was een 5 jaar oude asus p5n-t socket 775 moederbord.

De stroom kan ik ook regelen van afstand met een ip power 9258.

Ik heb in de 4U kast een fan wall met 3x noctua pf12 fans en achterop 2x 80 mm noctua fans, dan heb ik in de boven plaat nog 1x noctua pf12 die warme lucht de kast uit blaast en de koeler van de corsair h80i waterkoeling zit ook aan de bovenplaat vast, kon hem nergens anders niet kwijt.

| System specifications | |

| Component | Value |

|---|---|

| Case | Norco 4224 4U |

| CPU | Intel Core i7 960 @ stock |

| RAM | Corsair 6x2GB, DDR3, PC12800, CL9, XMS3 |

| Motherboard | Asus Sabertooth X58 |

| Operating system | Windows Server 2016 standaard |

| Controller | Areca 1880ix-24 24 poorten sata |

| Hard drive | 20 x 3TB Hitachi Deskstar_7K3000 + 4 x 4 TB WD Green |

| SSD | OCZ Vertex 2 SATA II 2.5" SSD 60GB |

| RAID array configuration | Boot: 1x 60 GB SSD and 20 x 3 TB RAID 6 ( 60 TB storage ) + 4 x 4TB RAID 5 ( 12 TB Storage) |

| Netto storage capacity | 66 TB |

| Network | Intel X520-T2 10Gb 10GbE Base-T Dual Port PCI-E Network NIC Card E10G42BT FH |

| Filesystem | NTFS |

| Idle power usage | ~190 Watt |

| Cpu Cooling | Corsair H80i cpu koeling |

| Powerswitch | ip power 9258 |

| Voeding | Corsair ATX 850W 24P |

| Videokaart | Ati Radeon X550 |

| Functie | Backup Server |

Bovenstaande server is mijn backup server, ik gebruik deze server als backup van mijn main server.

Server draait windows 2012 R2 , de 20x schijven staan in raid 6.

De asus sabertooth komt uit mijn main server aangezien het mainboard van mijn backup server is overleden, dit was een 5 jaar oude asus p5n-t socket 775 moederbord.

De stroom kan ik ook regelen van afstand met een ip power 9258.

Ik heb in de 4U kast een fan wall met 3x noctua pf12 fans en achterop 2x 80 mm noctua fans, dan heb ik in de boven plaat nog 1x noctua pf12 die warme lucht de kast uit blaast en de koeler van de corsair h80i waterkoeling zit ook aan de bovenplaat vast, kon hem nergens anders niet kwijt.

[ Voor 46% gewijzigd door thalantis op 07-01-2021 22:42 . Reden: update 7-1-2021 ]

Hoe heb jij die Intel Pro 1000PT aan de praat gekregen onder 2012? Die word toch niet meer ondersteund?

Even niets...

de intel kaart word prima herkent door windows server 2012.

in mijn andere server word hij herkent als een HP NC360T PCIe DP Gigabit Server Adapter.

in mijn andere server word hij herkent als een HP NC360T PCIe DP Gigabit Server Adapter.

Hmm, dan zal het 2012R2 zijn... Daar werken mijn Intel Pro 1000 PT en VT beiden niet

Stomme intel...

Stomme intel...

Even niets...

goed om te weten, ik zie wel even wanneer ik over ga op 2012R2

Vet hoor, in totaal dus 104 TB storage over 2 chassis.

Ga je ze nog ophangen (voor zover het gewicht het toelaat  )? Lijken me goede stofzuigers zou op de vloer

)? Lijken me goede stofzuigers zou op de vloer

ja kloptQ schreef op woensdag 18 september 2013 @ 15:52:

Vet hoor, in totaal dus 104 TB storage over 2 chassis.

ik ben nog opzoek naar een rack om ze op te hangen, de stof valt nog wel mee ze staan niet 24/7 aan.Mr_gadget schreef op woensdag 18 september 2013 @ 16:10:

Ga je ze nog ophangen (voor zover het gewicht het toelaat)? Lijken me goede stofzuigers zou op de vloer

deze leek me wel wat https://ri-vier.eu/norco-...r415u-p-194.html?cPath=66

maar weet niet of die geschikt is voor norco en rivier kasten

ik gebruik zelf http://nl.startech.com/Se...ck-Serverkast~4POSTRACK12 en die past qua breedte net / net niet met de rails van Norco. In de praktijk past het maar moet ik bij laatste 15cm extra kracht zetten of goed opletten dat de rails in elkaar rollen. Beetje lastig uitleggen maar Norco kast plus rails lijkt een halve millimeter te breed voor het rack.

Ik heb zo een norcorack met 2x 4220 erin, maar de servers staan op plankjes, en hangen niet in rails.

Volgens mij is dit rack niet diep genoeg om de rails van norco vast te zetten.

Maar informatie op een review bij serve the home: http://www.wegotserved.co...19-open-frame-steel-rack/

Het rack is goed stevig, en er zitten wielen bij. Door het gewicht van de 4220 units kan ik er 1 wel een stuk uit trekken zonder dat het rack begint te kantelen. De andere 4220 houdt de zaak dan in balans.

Volgens mij ga je ook niet met een standaard kast zo een server helemaal uit trekken via rails zonder de kast aan de vloer te borgen..

Volgens mij is dit rack niet diep genoeg om de rails van norco vast te zetten.

Maar informatie op een review bij serve the home: http://www.wegotserved.co...19-open-frame-steel-rack/

Het rack is goed stevig, en er zitten wielen bij. Door het gewicht van de 4220 units kan ik er 1 wel een stuk uit trekken zonder dat het rack begint te kantelen. De andere 4220 houdt de zaak dan in balans.

Volgens mij ga je ook niet met een standaard kast zo een server helemaal uit trekken via rails zonder de kast aan de vloer te borgen..

[ Voor 11% gewijzigd door jacovn op 21-09-2013 08:28 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Bij het norco rack staat het er uitdrukkelijk bij:

Ik heb een lekker zware UPS onderaan zitten, en de server zit daar vlak boven, dus volledig uittrekken is niet echt een probleem. Ook de antec case die daar boven zit kan ik volledig uittrekken.

Nu heb je ideaal wel een rack van 1m20 nodig om servers in de plaatsen. Ook mijn UPS past maar net tussen de deuren met de aansluitingen. Maar het gaat, en ik heb dit rack gratis gevonden, dus ga ik niet klagen.

Ik heb nu een 4220 met rails in een gesloten rack van 1m diepte zitten.Wat net gaat: de laatste 5mm krijg ik ook niet meer goed ingeduwd, maar dat is geen probleem.Can't work with RL-20 or RL-26 rail, need SA-3202 bracket, SA-3201 bracket or SA-5696 cantilever shelf for mounting rackmount cases;

Ik heb een lekker zware UPS onderaan zitten, en de server zit daar vlak boven, dus volledig uittrekken is niet echt een probleem. Ook de antec case die daar boven zit kan ik volledig uittrekken.

Nu heb je ideaal wel een rack van 1m20 nodig om servers in de plaatsen. Ook mijn UPS past maar net tussen de deuren met de aansluitingen. Maar het gaat, en ik heb dit rack gratis gevonden, dus ga ik niet klagen.

Ik zie hier een aantal mooie set-ups voorbij komen. Zelf ben ik bezig om ook een dergelijke set-up te beginnen. Ik ben nu aan het kijken naar de kasten van Ri-vier 24 bay storages.

Er is echter 1 ding dat ik niet helemaal snap, ik hoop dat één van jullie mij daarmee misschien kan helpen. Ik heb de uitleg al op google gezocht, maar ik kom er niet echt uit.

Misschien zou iemand van jullie het in wat duidelijkere taal, voor een niet techneut kunnen uitleggen.

Het gaat om het principe SGPIO, ik weet niet precies wat het is. Daarom weet ik niet of ik een serverkast moet nemen met of zonder SGPIO.

De twee kasten waar ik het over heb zijn

- Ri-vier 4U 24bay storage chassis (No SGPIO) - RV4324-03A

(https://ri-vier.eu/rivier...3a-p-284.html?cPath=1_3_7)

Ri-vier 4U 24bay storage chassis (With SGPIO) - RV-4324-01A

- (https://ri-vier.eu/rivier...1a-p-285.html?cPath=1_3_7)

Waarvoor dient de functie SGPIO, en waarom zou ik het wel of niet nemen? Sorry als het een hele domme vraag is, maar ik snap het niet. Ook de verklaringen op wikipedia, of onder de productpagina van de kast snap ik niet.

Er is echter 1 ding dat ik niet helemaal snap, ik hoop dat één van jullie mij daarmee misschien kan helpen. Ik heb de uitleg al op google gezocht, maar ik kom er niet echt uit.

Misschien zou iemand van jullie het in wat duidelijkere taal, voor een niet techneut kunnen uitleggen.

Het gaat om het principe SGPIO, ik weet niet precies wat het is. Daarom weet ik niet of ik een serverkast moet nemen met of zonder SGPIO.

De twee kasten waar ik het over heb zijn

- Ri-vier 4U 24bay storage chassis (No SGPIO) - RV4324-03A

(https://ri-vier.eu/rivier...3a-p-284.html?cPath=1_3_7)

Ri-vier 4U 24bay storage chassis (With SGPIO) - RV-4324-01A

- (https://ri-vier.eu/rivier...1a-p-285.html?cPath=1_3_7)

Waarvoor dient de functie SGPIO, en waarom zou ik het wel of niet nemen? Sorry als het een hele domme vraag is, maar ik snap het niet. Ook de verklaringen op wikipedia, of onder de productpagina van de kast snap ik niet.

Wellicht dat deze pdf je wel wat helpt: http://www1.ctt.de/files/pdf/SGPIO.pdf

Kortweg, informative van een host adapter naar een backplane doorgeven om de ledjes te laten blinken, zodat je aan het patroon van knipperen iets af kunt leiden.

Kortweg, informative van een host adapter naar een backplane doorgeven om de ledjes te laten blinken, zodat je aan het patroon van knipperen iets af kunt leiden.

[ Voor 116% gewijzigd door jacovn op 21-09-2013 08:25 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Mmmh.. Ok, dus zonder SGPIO doen je LEDjes in je hardeschijf niets? Of hebben ze in ieder geval geen knipperpatroon met een betekenis  .

.

Normaal heb ik met Norco blauw voor disc aan, en groen voor disc access zo uit mijn hoofd.

Maar norco heeft geen SGPIO

Ik neem aan met SGPIO dat de controller een led kan laten knipperen bij een hdd die je zou willen/moeten swappen of zo.

Bij een productie machine wil je natuurlijk miet zo maar de verkeerde hdd eruit halen en je hele systeem plat leggen.

Maar norco heeft geen SGPIO

Ik neem aan met SGPIO dat de controller een led kan laten knipperen bij een hdd die je zou willen/moeten swappen of zo.

Bij een productie machine wil je natuurlijk miet zo maar de verkeerde hdd eruit halen en je hele systeem plat leggen.

[ Voor 6% gewijzigd door jacovn op 21-09-2013 11:02 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

De vraag die ik dan nog heb, welke controllerjacovn schreef op zaterdag 21 september 2013 @ 10:58:

Normaal heb ik met Norco blauw voor disc aan, en groen voor disc access zo uit mijn hoofd.

Maar norco heeft geen SGPIO

Ik neem aan met SGPIO dat de controller een led kan laten knipperen bij een hdd die je zou willen/moeten swappen of zo.

Bij een productie machine wil je natuurlijk miet zo maar de verkeerde hdd eruit halen en je hele systeem plat leggen.

Voor zfs zijn de m1015 kaarten prima. Die hebben volgens IBM wel SGPIO (google search)

Wellicht dat iemand hier het gebruikt..

Even opletten met je moederbord, als je 2 of 3 stuks M1015 wilt gebruiken moet je wel dat aantal x8 pci-e sloten hebben. Ze doen het overigens ook prima in x4 sloten.

Wellicht dat iemand hier het gebruikt..

Even opletten met je moederbord, als je 2 of 3 stuks M1015 wilt gebruiken moet je wel dat aantal x8 pci-e sloten hebben. Ze doen het overigens ook prima in x4 sloten.

[ Voor 6% gewijzigd door jacovn op 21-09-2013 11:15 ]

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Heel leuk en interessant topic om te lezen! Vooral die mega 145TB systemen.

Ik vraag me alleen af of de grens van 10TB inmiddels niet iets omhoog zou moeten. Bijvoorbeeld naar 20TB o.i.d. Dan krijg je automatisch dat iemand iets speciaals heeft moeten doen. Ik zou op dit moment 12TB bijvoorbeeld wel heel makkelijk, en niet al te duur, kunnen maken (RAID-5):

Ik vraag me alleen af of de grens van 10TB inmiddels niet iets omhoog zou moeten. Bijvoorbeeld naar 20TB o.i.d. Dan krijg je automatisch dat iemand iets speciaals heeft moeten doen. Ik zou op dit moment 12TB bijvoorbeeld wel heel makkelijk, en niet al te duur, kunnen maken (RAID-5):

| # | Product | Prijs | Subtotaal |

| 4 | Western Digital Green WD40EZRX, 4TB | € 158,20 | € 632,80 |

| 1 | Synology Disk Station DS413J | € 283,20 | € 283,20 |

| Bekijk collectie Importeer producten | Totaal | € 916,- | |

De grens van 10 TB is anno 2013 wat laag.

Mijn eigen build die aan alle voorwaarden voldoet zou dan helaas buiten de boot vallen. Maar anno 2013 zou ik deze build niet meer zo doen. Dat was toen 4 jaar+ geleden. Dus hoe spannend is die build nog.

Dit is niet de eerste keer dat dit onderwerp naar boven komt. Wat vinden anderne hiervan?

Een moderator zou de titel kunnen veranderen van dit topic en de lijst kan worden opgeschoond.

Mijn eigen build die aan alle voorwaarden voldoet zou dan helaas buiten de boot vallen. Maar anno 2013 zou ik deze build niet meer zo doen. Dat was toen 4 jaar+ geleden. Dus hoe spannend is die build nog.

Dit is niet de eerste keer dat dit onderwerp naar boven komt. Wat vinden anderne hiervan?

Een moderator zou de titel kunnen veranderen van dit topic en de lijst kan worden opgeschoond.

Nouja 10 is idd wel heel makkelijk te halen. Nasjes halen dat tegenwoordig al en om nou te zeggen hier ik heb een 4 bay qnap met 15 TB effectieve ruimte is leuk maar om nou te zeggen een uitnodiging om over te discussieren nee niet echt.

Ik denk eerder dat het interresanter is om leuke builds te bespreken bedoel als iemand een Raspberry Pi servertje heeft daaraan een paar TB is het een leuke build ook al voldoet hij misschien niet aan de 10TB grens.

Om maar aan te geven mijn eerste server is een AMD Brazos waar 8 TB JBOD aan heb hangen en dan een 120 GB SSD omdat het kon en dat is ook mijn htpc en dat is een bak die nu al bijna 4 jaar draait volgens mij. Nu krijgt ie een update naar Haswell zodat ik er gewoon wat meer mee kan doen maar dat was toen misschien een leuke build maar nu totaal niet.

Ik denk eerder dat het interresanter is om leuke builds te bespreken bedoel als iemand een Raspberry Pi servertje heeft daaraan een paar TB is het een leuke build ook al voldoet hij misschien niet aan de 10TB grens.

Om maar aan te geven mijn eerste server is een AMD Brazos waar 8 TB JBOD aan heb hangen en dan een 120 GB SSD omdat het kon en dat is ook mijn htpc en dat is een bak die nu al bijna 4 jaar draait volgens mij. Nu krijgt ie een update naar Haswell zodat ik er gewoon wat meer mee kan doen maar dat was toen misschien een leuke build maar nu totaal niet.

[ Voor 54% gewijzigd door Hakker op 21-09-2013 21:50 ]

Artificial Intelligence is no match for natural stupidity | Mijn DVD's | Mijn Games | D2X account: Hakker9

De limiet mag naar mijn mening wel omhoog aangezien nog altijd het extra 'criterium' bestaat:

Bedenk dat 10TB voor 3.5" een eitje is, maar met 2.5" heb je er nog wel een aantal meer nodig. En wie weet zit daar zelfs een 1TB m500 bij.Indien je niet aan een van de criteria voldoet maar van mening bent dat je toch een hele interessante build hebt gemaakt, leg het gerust voor.

Ik heb nog even zitten denken. Wat mij betreft is er geen probleem en hoeft er dus ook niets gedaan te worden.

Als topic 'dictator' kan ik en mijn 2 mede editors er voor zorgen dat er gewoon geen oninteressante builds in 'de lijst' komen. Ik heb wel eens een machine niet opgenomen om die reden. En een N54L met 4 x 4 TB in RAID 5 komt echt niet in de lijst er zit er al eentje in....

Dat de lijst best lang is maakt niet zoveel uit denk ik.

Ja de ondergrens van 10 TB is laag. Maar het is niet het enige criterium.

Als topic 'dictator' kan ik en mijn 2 mede editors er voor zorgen dat er gewoon geen oninteressante builds in 'de lijst' komen. Ik heb wel eens een machine niet opgenomen om die reden. En een N54L met 4 x 4 TB in RAID 5 komt echt niet in de lijst er zit er al eentje in....

Dat de lijst best lang is maakt niet zoveel uit denk ik.

Ja de ondergrens van 10 TB is laag. Maar het is niet het enige criterium.

[ Voor 3% gewijzigd door Q op 22-09-2013 01:05 ]

Ik wou al bijna voorstellen om er een 100+ TB topic van te maken..Ja de ondergrens van 10 TB is laag. Maar het is niet het enige criterium.

Niet dat ik er dan nog in mag met mijn Netgear 6x3TB Raid 5 dingetje.. .durf die al niet eens aan te melden.

I'm not worthy

Medion X40 watercooled laptop, i9+4090, met Eluktro bios, 32GB DDR5 6400, 2x8TB MP600 Pro XT, 32" UHD monitor en wat kekke Logitech spullen.

Mijn oplossing is ook niet echt uniek te noemen. Het zat in een stacker case met 5in3 modules, maar nu ook maar gewoon in een norco 19" (heb de post veranderd)

Veel minder interessant, de oplossing is qua kast bijna 3x zo duur geworden, maar wel een betere oplossing wat betreft cable managmenent etc.

Veel minder interessant, de oplossing is qua kast bijna 3x zo duur geworden, maar wel een betere oplossing wat betreft cable managmenent etc.

8x330 NO12.5°, 8x330 ZW12.5°, 8x350 ZW60°, 8x325 NO10°, SE8K, P500. 6x410 ZW10° Enphase

Daar valt wat voor te zeggen. Maar dan zou ik bijna het hele 10TB criterium schrappen. Dan is het gewoon het "Storage showoff topic". Als ik met de pet rond ga en meer dan 100 oude < 10GB schijven uit de buurt verzamel, en ik knutsel er een Hadoop HDFS van, dan is dat op zich ook leuk. Het levert alleen effectief maar een paar 100 GB op.Q schreef op zondag 22 september 2013 @ 01:01:

Ik heb nog even zitten denken. Wat mij betreft is er geen probleem en hoeft er dus ook niets gedaan te worden.

Als topic 'dictator' kan ik en mijn 2 mede editors er voor zorgen dat er gewoon geen oninteressante builds in 'de lijst' komen. Ik heb wel eens een machine niet opgenomen om die reden. En een N54L met 4 x 4 TB in RAID 5 komt echt niet in de lijst er zit er al eentje in....

Dat de lijst best lang is maakt niet zoveel uit denk ik.

Ja de ondergrens van 10 TB is laag. Maar het is niet het enige criterium.

Dat is precies mijn standpunt. Het gaat er om of je build interessant is. Maar de lat ligt helemaal niet zo hoog. Sommige setups zijn wat 13-in-dozijn, maar iedereen heeft zo zijn afwegingen om bepaalde keuzes te maken en dat kan soms best nuttig zijn.KopjeThee schreef op zondag 22 september 2013 @ 08:58:

[...]

Daar valt wat voor te zeggen. Maar dan zou ik bijna het hele 10TB criterium schrappen. Dan is het gewoon het "Storage showoff topic". Als ik met de pet rond ga en meer dan 100 oude < 10GB schijven uit de buurt verzamel, en ik knutsel er een Hadoop HDFS van, dan is dat op zich ook leuk. Het levert alleen effectief maar een paar 100 GB op.

10TB wordt steeds makkelijker, einde dit jaar/ begin volgend jaar komen de 5TB disks.

Maar ik ben het met Q eens. Het gaat om de build en wat je er mee wilt bereiken. niet of het nu perse 10TB is.

Zou graag zo'n hadoop HDFS zien, lijkt me leuk voor dit topic of iemand die 24 SSD's in raid heeft staan omdat hij voor zijn toepassing die speed nodig heeft.

of iemand die 24 SSD's in raid heeft staan omdat hij voor zijn toepassing die speed nodig heeft.

Maar ik ben het met Q eens. Het gaat om de build en wat je er mee wilt bereiken. niet of het nu perse 10TB is.

Zou graag zo'n hadoop HDFS zien, lijkt me leuk voor dit topic

Het is en blijft een interessant topic met veel nuttige informatie, als ik sommige builds hier zie dan wordt ik er spontaan jaloers van

terwijl de meeste mensen in mijn omgeving mij al gek noemen met 28 TB (ja het is inmiddels weer iets meer als in de post staat)

terwijl de meeste mensen in mijn omgeving mij al gek noemen met 28 TB (ja het is inmiddels weer iets meer als in de post staat)

Ook de vele verschillende oplossingen vind ik persoonlijk heel mooi om te zien

Ook de vele verschillende oplossingen vind ik persoonlijk heel mooi om te zien

Verwijderd

Iemand die trouwens Ceph al gebruikt in zijn storage oplossing?

Wel zo fijn als je 100TB+ systemen hebt... Kan gerust 1 systeem uitvallen, is alsnog alle data beschikbaar. Plus een storage server bijprikken is dan tevens een fluitje van een cent.

Wie?

Wel zo fijn als je 100TB+ systemen hebt... Kan gerust 1 systeem uitvallen, is alsnog alle data beschikbaar. Plus een storage server bijprikken is dan tevens een fluitje van een cent.

Wie?

[ Voor 4% gewijzigd door Verwijderd op 22-09-2013 21:14 ]

Ja, Ceph is onwijs cool. Qua design beter dan Lustre.

Maar Ceph wordt wel een dure hobby. Want in feite doe je dan redundancy op het niveau van hele servers, dus moet je een hele server met alle disks aan redundancy opofferen.

Het zou al werken met 2 servers, maar je wilt er dan eigenlijk minimaal drie. met bijvoorbeeld 24 x 4 TB = 96 TB per server.

Wat wel gaaf van Ceph is, is het feit dat omdat redundantie over de servers loopt, je dus helemaal niet meer aan RAID hoeft te doen, zoals ik het begrijp.

Ik heb zelf mijn NAS altijd uit staan en zet 'm aan met WOL. Hoe dat met zo'n Ceph cluster zou werken, ik heb geen idee.

Maar Ceph wordt wel een dure hobby. Want in feite doe je dan redundancy op het niveau van hele servers, dus moet je een hele server met alle disks aan redundancy opofferen.

Het zou al werken met 2 servers, maar je wilt er dan eigenlijk minimaal drie. met bijvoorbeeld 24 x 4 TB = 96 TB per server.

Wat wel gaaf van Ceph is, is het feit dat omdat redundantie over de servers loopt, je dus helemaal niet meer aan RAID hoeft te doen, zoals ik het begrijp.

Ik heb zelf mijn NAS altijd uit staan en zet 'm aan met WOL. Hoe dat met zo'n Ceph cluster zou werken, ik heb geen idee.

Dat klinkt leuk, maar in de praktijk wil je niet bij elke disk die uitvalt gelijk 24x4 TB gaan recoveren over WAN. Je kan op zich wel af met minder redudantie per server, en je haalt de SPOF uit je storage. Dat is wel heel cool.Q schreef op maandag 23 september 2013 @ 00:17:

\met bijvoorbeeld 24 x 4 TB = 96 TB per server.

Wat wel gaaf van Ceph is, is het feit dat omdat redundantie over de servers loopt, je dus helemaal niet meer aan RAID hoeft te doen, zoals ik het begrijp.

Als je zo redeneert met redundantie is het juist goedkoper dan de meeste enterprise oplossingen die niet-SPOF, maar wel centraal en redundant zijn.

Kia e-Niro 2021 64kWh DynamicPlusLine. 3x Victron MP-II op 15kWh US5000 3f thuisbatterij met 3x25A→3x40A PowerAssist, Victron EVCS, 3200Wp HoyMiles zp. my GitHub, my blog

Verwijderd

Voor de geïnteresseerden, er is een speciaal CEPH topic, waar we op alle details en vragen ingaan: Ceph, an open source distributed file system

Verwijderd

Ik wil binnenkort een ds3612xs kopen, maar weet niet welke schijven nou echt goed geschikt zijn.

Iemand suggesties

Iemand suggesties

[ Voor 0% gewijzigd door Verwijderd op 27-09-2013 23:36 . Reden: Typo ]

Alsjeblieft: http://www.synology.com/s...&hd_select_ds=DS3612xs#95Verwijderd schreef op vrijdag 27 september 2013 @ 23:35:

Ik wil binnenkort een ds3612xs kopen, maar weet niet welke schijven nou echt goed geschikt zijn.

Iemand suggesties

Ik raad zelf Enterprise class schijven aan. (Hoewel het natuurlijk gewoon een loterij blijft...)

while (! ( succeed = try ()));

Verwijderd

@svenvang93: Zonder twijfel de Western Digital Red Series: http://tweakers.net/produ...-digital-red-sata-6-gb-s/

Deze hebben voordelen van een groot deel van de Enterprise features, maar een consumenten prijs. Ja, WD schrijft dat ze het best passen in systemen tot ik dacht 5 of 8 schijven, maar ze verkopen natuurlijk ook graag hun duurdere Enterprise schijven. Ik heb er 12 in 1 systeem en totaal geen probleem. Draaien al maanden als een zonnetje.

Nou kan je natuurlijk flink geld besparen door een zelfbouw systeem te kiezen ipv de DS3612. Heb je ook nog eens een hogere performance.

Bijvoorbeeld:

Kan je als je wil er nog een nette 19 inch rack case bij kiezen, bijvoorbeeld: Ri-vier 2U 12bay chassis with SAS backplane voor € 131,89 incl BTW. Dan moet je natuurlijk wel de Seasonic vervangen door een 2U voeding, maar die is van Seasonic qua prijs even duur.

Dan bespaar je jezelf wel een € 1000. Maar wellicht is de plug-and-plug mogelijkheid van de DS3612 je veel waard. Dat is natuurlijk een persoonlijk keuze.

Deze hebben voordelen van een groot deel van de Enterprise features, maar een consumenten prijs. Ja, WD schrijft dat ze het best passen in systemen tot ik dacht 5 of 8 schijven, maar ze verkopen natuurlijk ook graag hun duurdere Enterprise schijven. Ik heb er 12 in 1 systeem en totaal geen probleem. Draaien al maanden als een zonnetje.

Nou kan je natuurlijk flink geld besparen door een zelfbouw systeem te kiezen ipv de DS3612. Heb je ook nog eens een hogere performance.

Bijvoorbeeld:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E3-1270 v3 Boxed | € 296,50 | € 296,50 |

| 1 | Supermicro X10SLH-F | € 208,18 | € 208,18 |

| 1 | Noctua NH-L12 | € 45,90 | € 45,90 |

| 1 | Kingston ValueRAM KVR16E11K4/32 | € 302,- | € 302,- |

| 1 | IBM ServeRAID M1015 SAS/SATA Controller for System x | € 118,58 | € 118,58 |

| 1 | Seasonic Platinum Series 400 Watt Fanless | € 107,60 | € 107,60 |

| Totaal | € 1.078,76 | ||

Kan je als je wil er nog een nette 19 inch rack case bij kiezen, bijvoorbeeld: Ri-vier 2U 12bay chassis with SAS backplane voor € 131,89 incl BTW. Dan moet je natuurlijk wel de Seasonic vervangen door een 2U voeding, maar die is van Seasonic qua prijs even duur.

Dan bespaar je jezelf wel een € 1000. Maar wellicht is de plug-and-plug mogelijkheid van de DS3612 je veel waard. Dat is natuurlijk een persoonlijk keuze.

[ Voor 81% gewijzigd door Verwijderd op 28-09-2013 00:33 ]

Iets wat ik me al lang afvraag: past zo een controller wel in een 2U kast (zeker als er nog 8087 connectors bij moeten)?

Die Seasonic ATX voeding past er trouwens sowieso niet in denk ik.

Die Seasonic ATX voeding past er trouwens sowieso niet in denk ik.

Verwijderd

De M1015 wordt zowel met een low profile bracket als met een full height bracket geleverd. Met het low profile bracket past deze perfect in een 2U behuizing.

En bekijk gerust eens de details van de M1015, de connectors zijn geen enkel probleem om netjes aan te sluiten in een 2U behuizing.

SanderH_, Ik zag in je wenslijst een Norco 3216 staan. Ik kan je zeker de Ri-vier RV-3316-03A aanraden. Deze heeft een betere ontluchting van de drivebays aan de voorzijde. Hierdoor blijven je hd's een stuk koeler. Scheelt bij mij zo'n 15 graden nadat ik de Norco de deur uit had gedaan en vervangen door de Ri-vier RV-3316-03A.

Tevens is de fanwall volledig te demonteren en bevat hij standaard een stuk stillere fans dan de Norco 3216.

En eens standaard ATX voeding past er op zijn kant prima in. Daarbij ben je ook nog eens goedkoper uit

En bekijk gerust eens de details van de M1015, de connectors zijn geen enkel probleem om netjes aan te sluiten in een 2U behuizing.

SanderH_, Ik zag in je wenslijst een Norco 3216 staan. Ik kan je zeker de Ri-vier RV-3316-03A aanraden. Deze heeft een betere ontluchting van de drivebays aan de voorzijde. Hierdoor blijven je hd's een stuk koeler. Scheelt bij mij zo'n 15 graden nadat ik de Norco de deur uit had gedaan en vervangen door de Ri-vier RV-3316-03A.

Tevens is de fanwall volledig te demonteren en bevat hij standaard een stuk stillere fans dan de Norco 3216.

En eens standaard ATX voeding past er op zijn kant prima in. Daarbij ben je ook nog eens goedkoper uit

[ Voor 83% gewijzigd door Verwijderd op 28-09-2013 00:44 ]

Verwijderd

Ik ben zelf niet zo thuis in raid kaarten en alles wat er bij komt. Dus het plug en play heeft zeker mijn voorkeur.Dan bespaar je jezelf wel een € 1000. Maar wellicht is de plug-and-plug mogelijkheid van de DS3612 je veel waard. Dat is natuurlijk een persoonlijk keuze.

Verwijderd

@svenvang93: Heb je ook het volgende overwogen:

Dan heb je alles out of the box, dus geen gedoe met zelfbouw, etc, 12+10=22 schijven ruimte en samen 45W in stand-by modus. Dat is minder dan de DS3612xs in stand-by gebruikt. En bovenstaande trekt met gemak twee gigabit verbindingen dicht. In mijn ogen meer waar voor je geld.

| # | Product | Prijs | Subtotaal |

| 1 | Synology Rack Station RS2212+ | € 1.391,50 | € 1.391,50 |

| 1 | Synology Rack Station RX1211 | € 1.129,- | € 1.129,- |

| Totaal | € 2.520,50 | ||

Dan heb je alles out of the box, dus geen gedoe met zelfbouw, etc, 12+10=22 schijven ruimte en samen 45W in stand-by modus. Dat is minder dan de DS3612xs in stand-by gebruikt. En bovenstaande trekt met gemak twee gigabit verbindingen dicht. In mijn ogen meer waar voor je geld.

[ Voor 20% gewijzigd door Verwijderd op 29-09-2013 17:54 ]

Verwijderd

Ja ik heb er wel maar gekeken, maar zit met een puntje ik kijk veel series en gebruik daar voor plex icm met de iPad app. En daarvoor heb je transcoding nodig en dat kan die atom niet aan. Plus dat deze in kast moeten komen en ik in me kamer geen plek heb voor een kast, dus mijn voorkeur gaat uit naar een desktop model.Verwijderd schreef op zondag 29 september 2013 @ 17:47:

@svenvang93: Heb je ook het volgende overwogen:

# Product Prijs Subtotaal 1 Synology Rack Station RS2212+ € 1.391,50 € 1.391,50 1 Synology Rack Station RX1211 € 1.129,- € 1.129,- Totaal € 2.520,50

[afbeelding]

Dan heb je alles out of the box, dus geen gedoe met zelfbouw, etc, 12+10=22 schijven ruimte en samen 45W in stand-by modus. Dat is minder dan de DS3612xs in stand-by gebruikt. En bovenstaande trekt met gemak twee gigabit verbindingen dicht. In mijn ogen meer waar voor je geld.

Let op:

Om heftige discussies te voorkomen in het topic, lees eerst goed de start post om te weten waar aan het systeem moet voldoen. Ben je van mening dat jouw systeem toch in dit topic hoort maar valt hij niet binnen de gestelde eisen, neem dan contact op met een van de auteurs van dit topic zij zullen open staan voor goede argumenten, zoals ook vermeld in de start post.

Gebruik de in de TS geplaatste tabel om dit topic leesbaar te houden!

Om heftige discussies te voorkomen in het topic, lees eerst goed de start post om te weten waar aan het systeem moet voldoen. Ben je van mening dat jouw systeem toch in dit topic hoort maar valt hij niet binnen de gestelde eisen, neem dan contact op met een van de auteurs van dit topic zij zullen open staan voor goede argumenten, zoals ook vermeld in de start post.

Gebruik de in de TS geplaatste tabel om dit topic leesbaar te houden!

:strip_exif()/u/24321/motor1.gif?f=community)

/u/1176/crop635f8931b2b68_cropped.png?f=community)

:strip_icc():strip_exif()/u/80624/crop56269c878c330.jpeg?f=community)

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

:strip_exif()/u/62088/sp_jh2.gif?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)

:strip_exif()/u/16970/crop57cd1ef1eb0d0.gif?f=community)

:strip_exif()/u/36533/Smaller_J_forum60x60.gif?f=community)

:strip_icc():strip_exif()/u/338099/crop5e601f8f7290c_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/61950/hakker.jpg?f=community)

/u/231803/ramdisk2.png?f=community)

:strip_icc():strip_exif()/u/42999/kamikaze.jpg?f=community)

:strip_icc():strip_exif()/u/57319/BoFhphone.jpg?f=community)