Even niets...

De LSI Parallel SCSI controller is een 'oude' 1068 LSI PCI-X controller.

En de LSI Logic SAS controller is ook een oude 1068 controller, maar dan met een PCie interface (iets sneller dus, en een andere driver.)

Paravirtual SCSI kan ik nog niet echt hoogte van krijgen, en ik heb geen idee of dat die controller 3TB ondersteund. Maar ik verwacht het eerlijk gezegd niet.

Even niets...

vPro is leuk voor beheer van de hardware. Je moet het zien als een remote kvm. Bordjes als de X9SCM-F van Supermicro hebben een wat uitgebreider beheer in de vorm van IPMI.magic_japie schreef op donderdag 20 december 2012 @ 23:34:

In prijs schelen de 3330 en 3550 toch 24 euro en zul je het verschil merken?

Enige wat de 3550 meer heeft is vPRO. Is dat erg essentieel voor ESXi?

AMD FX-8120

Asrock 970 Extreme3

8 GB RAM

3x Samsung HD753LJ (750 GB, 7200 rpm)

2x WD Raptor (36 GB, 10000 rpm)

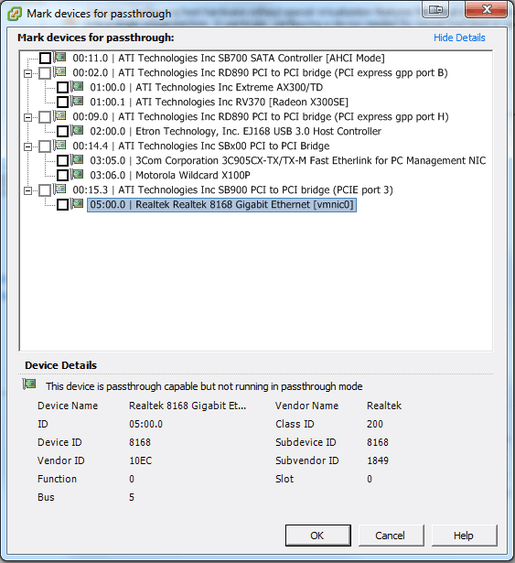

Even terugkomend op het PCI-passthrough gebeuren: Eerst crashde de bak telkens met een PSOD (page fault) bij het aanzetten van een VM waaraan een PCI device was toegevoegd.

Dit zou gefixed moeten zijn met de patch van 4 dagen geleden. Die heb ik geinstalleerd, maar ESXi crasht nog steeds zodra ik de VM wil aanzetten. Dit maal wel met een andere PSOD:

https://dl.dropbox.com/u/5552339/2012-12-24%2013.02.51.jpg

1

| PCPU0 locked up Failed to ack TLB invalidate (total of 1 locked up, PCPU9s): 0) |

Betekent dit simpelweg dat PCI passthrough op dit systeem niet gaat werken? (Maar PCIe-passthrough wel?)

Daarnaast ben ik ook een beetje teleurgesteld over het verbruik. Mijn verbruik-meter meet 105 watt idle en 180 watt load. Dat moet toch omlaag kunnen?

Gewoon een heel grote verzameling snoertjes

Je kan overigens enkel pci-e passthroughen.

Any job you can do in your pajamas is not the hardest job in the world.

PCI poorten zijn aangesloten via een PCI>PCIe bridge. ESX vindt bridges niet zo leukCompizfox schreef op maandag 24 december 2012 @ 13:20:

Betekent dit simpelweg dat PCI passthrough op dit systeem niet gaat werken? (Maar PCIe-passthrough wel?)

Je kan nog ESX5.0 proberen, die heeft minder issues met vt-d dan 5.1.

Gewoon een heel grote verzameling snoertjes

Hoeveel geheugen heb je de VM gegeven? Als dat 4GB of meer was, kan je nog eens proberen dat te verlagen. Ik heb daar wel eens wat dingen over gehoord.

En inderdaad, als de PCI->PCIe bridge gedeeld worden, zouden alle devices doorgegeven moeten worden. Als deze al in gebruik zijn door ESXi gaat dat niet werken.

Je kan een Xen LiveCD booten en het daarmee proberen, dan weet je of het aan de hardware of aan ESXi ligt.

Even niets...

Ook met 3 GB RAM heb ik dat probleem.FireDrunk schreef op dinsdag 25 december 2012 @ 00:13:

Ja, dat komt zeker voor. Bij GPU passthrough zie je dat ook vaak

Hoeveel geheugen heb je de VM gegeven? Als dat 4GB of meer was, kan je nog eens proberen dat te verlagen. Ik heb daar wel eens wat dingen over gehoord.

ESXi geeft niet aan dat dat het geval is. Ik kan gewoon passthrough activeren voor een enkele PCI-to-PCI-bridge waarop 2 PCI-kaarten zijn aangesloten.En inderdaad, als de PCI->PCIe bridge gedeeld worden, zouden alle devices doorgegeven moeten worden. Als deze al in gebruik zijn door ESXi gaat dat niet werken.

Kan ik trouwens de (PCI-e) videokaart doorgeven? Of heeft ESXi die in gebruik?

Ik kan namelijk ook wel mijn NIC doorgeven, maar ik besef me dat dat niet goed gaat omdat ESXi die zelf nodig heeft.

Iemand verder nog tips over het tweaken van stroomverbruik? Ik heb de volgende tweaks al toegepast: http://blog.peacon.co.uk/wiki/ESXi_Custom_Power_Management

Ik vraag me bijvoorbeeld af of mijn disks wel downspinnen. Ik denk dat de guest (ZFSGuru) dit niet kan omdat ik de disks doorgeef dmv een virtual RDM (FreeBSD heeft problemen met phyical RDMs)

[ Voor 16% gewijzigd door Compizfox op 25-12-2012 01:41 ]

Gewoon een heel grote verzameling snoertjes

http://www.supermicro.com...oard/ATOM/X9/X9SBAA-F.cfm

Even niets...

Mogelijkheden te over maar let wel goed op de support voor de NICs. Wil je virtualisatie gebruiken kijk dan ook vooral goed naar je eigen gebruik. Een Windows omgeving met grafische schil wordt al snel teveel maar iets van UNIX/Linux met alleen een shell is prima te doen.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 159,- | € 159,- |

| 1 | ASRock B75 Pro3-M | € 57,90 | € 57,90 |

| Bekijk collectie Importeer producten | Totaal | € 216,90 | |

Wat ik wil is mijn 4 wd 2tb sata hdd's downspinnen, en middels RDM in mijn windows 2008 server gaat dat niet lukken.

Aangezien ik nu min of meer van scratch mijn ESXi host opnieuw kan opbouwen dacht ik aan VT-d icm Freenas (of iets anders met zfs) zodat ik in ieder geval mijn disken kan downspinnen, en zo energie kan besparen.

Het bovenstaande moederbord heeft 8 sata aansluitingen en 4 memory bankjes dus mooi toekomst proof.

Als ik deze dit dan weer lees word ik wat minder gelukkig gestemd:

http://gathering.tweakers...message/39428603#39428603

ik moet 4 disken vt-d'en (of in ieder geval een controller vt-d'en met minimaal 4 sata poorten)

Hier maak ik niet uit op welke controller nu precies welke is

http://www.asrock.com/mb/...ations&Model=B75%20Pro3-M

Of heeft is er een moederbord welke ik nog niet gevonden hebt die aan de volgende eisen voldoet:

*zuinige

*minimaal 6 sata poorten

*vt-d (een controller die vt-d in esx5.1 pakt met minimaal 4 poorten?)

Chipset H77 of B75 maakt mij niet zo gek veel uit, het verschil is ook maar minimaal..

Dit bord ziet er bijvoorbeeld ook goed uit, waar ook niet duidelijk is welke controller nu precies hoeveel poorten heeft.

http://www.asrock.nl/mb/I...ro4-M/?cat=Specifications

[ Voor 10% gewijzigd door Valkyre op 28-12-2012 10:11 ]

Totaal 8 sata poorten

- 4 x SATA2 3.0 Gb/s connectors, support RAID (RAID 0,

RAID 1, RAID 5, RAID 10, Intel Rapid Storage and Intel

Smart Response Technology), NCQ, AHCI and Hot Plug

functions

- 4 x SATA3 6.0Gb/s connectors

-------------------------------------------------------------------------------------------

Toelichting sata 3

- 2 x SATA3 6.0 Gb/s connectors by Intel® H77, support RAID

(RAID 0, RAID 1, RAID 5, RAID 10, Intel Rapid Storage and

Intel Smart Response Technology), NCQ, AHCI and Hot

Plug functions

- 2 x SATA3 6.0 Gb/s connectors by ASMedia ASM1061,

support NCQ, AHCI and Hot Plug functions

(SATA3_A1 connector is shared with eSATA3 port)

[ Voor 34% gewijzigd door jeroen1507 op 30-12-2012 21:52 ]

Maar als ik naar my vmware ga kijken kan ik deze niet downloaden ik zou deze moeten kopen. Wat gaat er hier fout? Af kijk ik naar iets verkeerd?

http://tinkertry.com/upgr...-0-to-5-1-the-easier-way/

IBM ServeRaid M1000 Advance Feature Key - M1015 - 46M0864 - 46M0832

Volgens Ebay levert je dit RAID 5 en 10 extra op.

Misschien zinvol voor de tweakers die naar RAID5 willen... en die al in bezit zijn van deze SATA controller.

Fritzbox 7490, 1x Netgear GS108E, 2x TP-Link SG105E, HP2520-8G-POE

Ik heb het op 5.1 getest. Ik krijg een 3TB RDM disk niet werkend onder Windows Server 2012. Dus RDM is geen optie maar een vmdk is ook geen optie want 2TB limiet. Beetje achterhaalde specs van ESXi imho.FireDrunk schreef op zondag 23 december 2012 @ 15:27:

Misschien in ESXi 5.1, ik heb het eerlijk gezegd nog niet geprobeerd.

Of jij gebruikt ESXi waar het helemaal niet voor bedoeld isC00KW4US schreef op woensdag 02 januari 2013 @ 13:53:

[...]

Beetje achterhaalde specs van ESXi imho.

Zelf liep ik ook tegen een limitatie aan van NFS in Solaris, maar dat heb ik verholpen door gewoon meerdere (5x 512GB) virtuele disken toevoegen en die in vervolgens in windows aan elkaar koppelen via JBOD. Misschien is dat voor jou ook een oplossing.

ps: Ja ik was te lui om een mooie oplossing te zoeken

RDM is dus vanaf nu out of the picture...

Discussie gaat hier verder:FireDrunk in "Het grote ZFS topic"

[ Voor 39% gewijzigd door FireDrunk op 03-01-2013 16:00 ]

Even niets...

Ik wil ESXi gebruiken icm 3TB disken en presenteren aan een VM, dit is kennelijk een beperking van ESXi want meer dan 2TB aan een VM hangen gaat gewoon niet out-of-the-box. Zo'n workaround die jij nu toepast wil ik niet gebruiken.Deveon schreef op donderdag 03 januari 2013 @ 11:12:

[...]

Of jij gebruikt ESXi waar het helemaal niet voor bedoeld is

Zelf liep ik ook tegen een limitatie aan van NFS in Solaris, maar dat heb ik verholpen door gewoon meerdere (5x 512GB) virtuele disken toevoegen en die in vervolgens in windows aan elkaar koppelen via JBOD. Misschien is dat voor jou ook een oplossing.

ps: Ja ik was te lui om een mooie oplossing te zoeken

Zo exotisch zijn 3TB disken nu ook weer niet, wel jammer dat deze beperking nog steeds in ESXi zit. Dan maar met Hyper-V 2012 aan de slag

Wat je nog zou kunnen proberen is om de harddisks van te voren te partitioneren en formatteren?C00KW4US schreef op donderdag 03 januari 2013 @ 11:55:

[...]

Ik wil ESXi gebruiken icm 3TB disken en presenteren aan een VM

Ik heb mijn 3TB drives namelijk wel kunnen koppelen aan een 2012 VM, echter waren dit bestaande schijven die ik al had en dus bestaande data opstond. Ik heb deze via RDM gekoppeld aan de VM. In computer management wordt de grootte van de schijf wel herkend als -128MB, echter worden de partities/schijven goed herkend als 3TB en kan gewoon bij mijn data.

-

Zo exotisch zijn 3TB disken niet nee, maar wel in een datacentre icm met een Hypervisor. Daarnaast is RDM ook geen ondersteunde functionaliteit.C00KW4US schreef op donderdag 03 januari 2013 @ 11:55:

[...]

Ik wil ESXi gebruiken icm 3TB disken en presenteren aan een VM, dit is kennelijk een beperking van ESXi want meer dan 2TB aan een VM hangen gaat gewoon niet out-of-the-box. Zo'n workaround die jij nu toepast wil ik niet gebruiken.

Zo exotisch zijn 3TB disken nu ook weer niet, wel jammer dat deze beperking nog steeds in ESXi zit. Dan maar met Hyper-V 2012 aan de slag

@FireDrunk:

Wat zou precies het nadeel zijn of je 5 kleinere virtuele disken hebt of 1 grote virtuele disk? Als je er maar geen raid0 of 1 overeen gooit zie ik het probleem niet.

Overigens overweg ik zelf ook om de overstap te maken naar Win8 met daarop Hyper-V 3.0 zodat ik een HTCP heb die daarnaast als hypervisor functioneerd.

Verwijderd

Intel i3 2120 CPU

MSI B75MA-P45 Moederbord

G.Skill 32GB DDR3-1333 F3-1333C9Q-32GAO Geheugen

Norco RPC 230

6x 2,5 inch hot swap voorin met

- 1x 30GB OCZ SSD als Cache disk

- 1x 96GB Kingston SSD als Datastore

Areca 1200 PCI-e 2 ports raidcard met

- 2x 1TB WD Greenpower in RAID1 als Datastore

Intel Dual NIC Gigabit PCI-e voor wat netwerkverkeer

Zal vanavond eens wat screenshots en foto's maken

Er komen een stuk of 3/4 Windows 2008 servers op te draaien (PDC, Exchange en Applicatie bakje) en een pfSense firewall. Alles gewoon op een locale datastore (met backups naar mijn NAS ofzo), dus dingen als RDMs, VT-d etc zijn niet nodig.

Ik zat te denken aan de volgende config:

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i3 3220T Boxed | € 111,10 | € 111,10 |

| 1 | ASRock B75 Pro3-M | € 57,90 | € 57,90 |

| 1 | Corsair CMV16GX3M2A1333C9 | € 60,50 | € 60,50 |

| 1 | be quiet! Pure Power L7 300W | € 37,45 | € 37,45 |

| 1 | Crucial v4 SSD 2.5" 128GB | € 80,50 | € 80,50 |

| Bekijk collectie Importeer producten | Totaal | € 347,45 | |

Ik heb hier eigenlijk twee vragen over:

1) Is de keuze voor deze core i3 de juiste? Ik heb hem gekozen omdat hij volgens mij voldoende power in huis heeft om zo'n 5 VMs te draaien en daarnaast volgens mij de meest zuinige optie is?

2) Zijn er nog specifieke eisen voor een SSD die je als ESX datastore gebruikt (ESX ondersteunt geen trim denk ik, of wel intussen?) en voldoet de gekozen Crucial SSD hieraan, of zijn er betere opties?

Core i3 is een prima CPU. Bedenk wel even of je in de toekomst nog plannen hebt om dingen te wijzigen of te proberen qua VM's.Sleepie schreef op donderdag 03 januari 2013 @ 14:11:

1) Is de keuze voor deze core i3 de juiste? Ik heb hem gekozen omdat hij volgens mij voldoende power in huis heeft om zo'n 5 VMs te draaien en daarnaast volgens mij de meest zuinige optie is?

Ik gebruik hier 2 Intel SSD's (geen RAID), draait prima. Volgens mij ondersteunde VMWare zo wel trim op SSD's. Als ik zo naar mijn bakkie kijk en wat ik verbruik aan diskruimte, is 128Gb misschien te weinig en is een 256/512Gb model beter.Sleepie schreef op donderdag 03 januari 2013 @ 14:11:

2) Zijn er nog specifieke eisen voor een SSD die je als ESX datastore gebruikt (ESX ondersteunt geen trim denk ik, of wel intussen?) en voldoet de gekozen Crucial SSD hieraan, of zijn er betere opties?

MacBook Pro 2023 [14-inch, M2 Pro, 32GB RAM, 512GB]

Er zal niet veel meer bijkomen, ik draai een dergelijke setup al een jaar of 3, maar dan op een Hyper-V server. Deze is echter wat verouderd (en minder zuinig) en Hyper-V en pfSense is ook geen gelukkige combinatie, vandaar de overstap naar ESX.Ultimation schreef op donderdag 03 januari 2013 @ 14:57:

Core i3 is een prima CPU. Bedenk wel even of je in de toekomst nog plannen hebt om dingen te wijzigen of te proberen qua VM's.

Hooguit nog eens een test-servertje ofzo, maar ook dat moet makkelijk kunnen volgens mij.

Ik heb gekeken op mijn huidige Hyper-V server en met 128GB zou ik voorlopig uit moeten komen, ik heb zelf ook gedacht aan een 256GB versie, maar ik zit momenteel niet zo dik in de centen en ik kan er altijd nog eentje bijplaatsten later natuurlijk.Ik gebruik hier 2 Intel SSD's (geen RAID), draait prima. Volgens mij ondersteunde VMWare zo wel trim op SSD's. Als ik zo naar mijn bakkie kijk en wat ik verbruik aan diskruimte, is 128Gb misschien te weinig en is een 256/512Gb model beter.

Is er een specifieke reden dat je voor Intel SSDs hebt gekozen?

Even niets...

Aha, dat wist ik dan weer niet. Kan het dus nog een klein beetje goedkoper. Thanks!FireDrunk schreef op donderdag 03 januari 2013 @ 16:01:

-T is trouwens onzin, gewone is net zo zuinig. Bij een -T is alleen de max gecapped.

Mja, toch niet...

Scheelt 10,-

pricewatch: Corsair Vengeance CML16GX3M2A1600C10

[ Voor 48% gewijzigd door FireDrunk op 03-01-2013 17:34 ]

Even niets...

Die had ik toevallig nog in de kast liggen. Zijn al oudjes hoor.Sleepie schreef op donderdag 03 januari 2013 @ 15:42:

Is er een specifieke reden dat je voor Intel SSDs hebt gekozen?

MacBook Pro 2023 [14-inch, M2 Pro, 32GB RAM, 512GB]

MSI B75MA-P45 Moederbord

werkt hier de onboard NIC out of the box van met ESXI 5.1 of dat helemaal niet?

Want ik vind verschillende tegenstijdige verhalen.

Als dezeout of the box ondersteund wordt dan ben ik namelijk over om dit bordje aan te schaffen

Of is er dan nog een ander alternatief?

PSN: McMillan0984

Het lijkt me toch niet zo moeilijk om dat uit te zoeken, toch? Als je weet wat voor ethernet controller erop zit...

Any job you can do in your pajamas is not the hardest job in the world.

De Realtek RTL 8111E wordt gewoon ondersteunt.Clavat schreef op vrijdag 04 januari 2013 @ 08:48:

Even een vraagje over de

MSI B75MA-P45 Moederbord

werkt hier de onboard NIC out of the box van met ESXI 5.1 of dat helemaal niet?

Want ik vind verschillende tegenstijdige verhalen.

Als dezeout of the box ondersteund wordt dan ben ik namelijk over om dit bordje aan te schaffen

Of is er dan nog een ander alternatief?

http://www.ivobeerens.nl/...i-5-whitebox-nic-support/

Thnxn0fragger schreef op vrijdag 04 januari 2013 @ 09:10:

[...]

De Realtek RTL 8111E wordt gewoon ondersteunt.

http://www.ivobeerens.nl/...i-5-whitebox-nic-support/

Maar uiteindelijk heb ik weer gevonden dat bij 5.1 geen ondersteuning is dat deze er weer uitgeloopt is.

Ik zoek namelijk een leuk bordje met:

waar minimaal 4 banken geheugen inkunnen

en waar de Nic supported is.

en niet al te duur.

en esxi 5.1 ondersteund,

Want mijn oud systeempje werkt niet lekker met 5.1

PSN: McMillan0984

Even niets...

| OS | Functie |

| Ubuntu | Leechbak met SabNZBd etc |

| FreeNAS | NAS in zraid1 |

| Win 2k8 | Active Directory/Plex Server/Media Portal |

| Ubuntu | SSH-jumphost/Postfix/fail2ban |

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3330 Boxed | € 159,- | € 159,- |

| 1 | ASRock B75 Pro3-M | € 57,90 | € 57,90 |

| 2 | Kingston KVR1333D3N9/8G | € 34,45 | € 68,90 |

| 1 | Seasonic G-Serie 360Watt | € 64,- | € 64,- |

| 1 | Samsung 830 series SSD 128GB | € 99,95 | € 99,95 |

| 4 | WD Green WD10EADS | € 0 | € 0 |

| Bekijk collectie Importeer producten | Totaal | € 449,75 | |

Ik ga het geheel gooien in een CM Stacker (1st generation), die heb ik nog staan en kan zo in de toekomst nog wat HD's erbij gooien. De HD's (WD Green) haal ik uit een ander systeem. ESXi ga ik draaien vanaf een USB stickje en ik wil de vm's op de SSD zetten. Misschien ga ik later nog wat klooien met andere vm's om te testen, maar deze zijn in ieder geval de eis.

Wat ik me vooral afvraag is of ik qua grootte SSD juist zit of mijn RAM genoeg is voor wat ik wil en of ik nog iets over het hoofd zie?

Compromises are for the weak

ik kan je overigens Nas4Free aanraden ipv FreeNAS, maar dat is een discussie die hier niet hoort

Even niets...

Goede vraag, ik wilde ze doorgooien met VT-d.FireDrunk schreef op vrijdag 04 januari 2013 @ 14:26:

Hoe wil je de disks aan FreeNAS geven?

ik kan je overigens Nas4Free aanraden ipv FreeNAS, maar dat is een discussie die hier niet hoort

Ik ben sowieso niet gebrand op FreeNAS, meer omdat ik hier mee eerder heb gewerkt en ook ervaring heb met pfsense en m0n0wall, dus mocht FreeNAS niet werken, ga ik zeker de andere initiatieven checken.

nu pas het verschil gechecked van Nas4Free en FreeNAS, dus dan wordt het waars. nas4free

[ Voor 8% gewijzigd door Tha_Butcha op 04-01-2013 14:36 ]

Compromises are for the weak

Zover ik begrijp zitten er 2 raidcontrollers is, alleen wordt de extra controller vaak niet ondersteund door ESX. Dit kan zijn voor passthrough of een datastore op te plaatsen.

[ Voor 53% gewijzigd door Deveon op 04-01-2013 14:38 ]

Die bevat wel een "full" install.

Helaas nog steeds zonder portstree

* FireDrunk poept op die smerige Jails...

Even niets...

Dat was wat ik ook niet helemaal duidelijk kreeg uit het topic. Het is toch ook mogelijk om ze door te gooien met RDM, omdat de HD's toch maar 1TB zijn? En wil ik later grote jongens (>2TB) erbij gooien een kaart als de IBM Serveraid M1015 erin gooien en die erbij pluggen middels VT-d?Deveon schreef op vrijdag 04 januari 2013 @ 14:35:

Voor het doorgeven met VT-d zal je wel een extra raidcontroller nodig hebben.

Zover ik begrijp zitten er 2 raidcontrollers is, alleen wordt de extra controller vaak niet ondersteund door ESX. Dit kan zijn voor passthrough of een datastore op te plaatsen.

Compromises are for the weak

Physical RDM zou werken met ZFS, maar Physical RDM werkt weer niet met FreeBSD 9.1.

Je moet dan dus FreeBSD 9.0 draaien.

Heeft te maken met de MPTSAS drivers.

[ Voor 8% gewijzigd door FireDrunk op 04-01-2013 14:54 ]

Even niets...

sorry voor het vloeken in de kerk

Als je Mobo vervangt en installeert ESXI

Kun je de virtuals op de schijven laten staan of moet je deze schijven formateren en dan weer de virtuals terug zetten?

PSN: McMillan0984

Een ESXi usb stick kan je van AMD -> Intel -> Elk willekeurig chipset gewoon meenemen.

Zolang de controllers / netwerkkaarten ondersteund worden, werkt het.

Soms moet je even via de console een 'nieuwe' netwerkkaart toevoegen aan de Management VMKernel poort.

Even niets...

Dus als ik het goed begrijp dan:FireDrunk schreef op vrijdag 04 januari 2013 @ 15:45:

ESXi geeft niets om hardware, en is geenzins verbonden met een bepaalde machine bij installatie.

Een ESXi usb stick kan je van AMD -> Intel -> Elk willekeurig chipset gewoon meenemen.

Zolang de controllers / netwerkkaarten ondersteund worden, werkt het.

Soms moet je even via de console een 'nieuwe' netwerkkaart toevoegen aan de Management VMKernel poort.

Ik vervang mijn Mobo.

Kan mijn customize esxi usb stick er aan hangen en dan opstarten en klaar? ik kan er weer in?

Want mijn vorige mobo moest ik een hack hebben i.v.m netwerkkaart

PSN: McMillan0984

Even niets...

OkeFireDrunk schreef op vrijdag 04 januari 2013 @ 16:09:

Dat ligt er dus inderdaad aan OF de netwerkkaart ondersteund word. Maar ALS hij ondersteund word, kan je inderdaad gewoon je USB stick overzetten. Je hoeft eigenlijk nooit de installer opnieuw te runnen.

En met een downgrade werkt het ook nog neem ik aan?

Want de netwerkkaart word wel bij 5.0 ondersteund maar 5.1 is die eruit.

Of moet ik dan de virtuals wel weer opnieuw aanmaken?

PSN: McMillan0984

Even niets...

Op het nieuwe mobo de processor erop geheugen erin

en de SSD met de 2 servers blijft zitten en gebeurd niets mee.

dus ik was aan het denken om dan een nieuwe ESXI 5.0 installatie te doen en dan op te starten.

PSN: McMillan0984

- Passthrough van een hele controller dmv VT-d/IOMMU (werkt met FreeBSD 9.1)

- Physical RDM van losse schijven (werkt niet met FreeBSD 9.1, wel met 9.0)

Virtual RDM werkt wel met FreeBSD 9.1, maar is icm ZFS echt een smerige oplossing imho.

Gewoon een heel grote verzameling snoertjes

| # | Product | Prijs | Subtotaal |

| 1 | Intel Core i5 3570T Boxed | € 0,- | € 0,- |

| 1 | Intel Desktop Board DQ77MK | € 122,50 | € 122,50 |

| 2 | Corsair Vengeance CML16GX3M2A1600C10 | € 70,45 | € 140,90 |

| 1 | Crucial m4 CT128M4SSD2 128GB | € 91,- | € 91,- |

| Bekijk collectie Importeer producten | Totaal | € 354,40 | |

wel voor de T variant gegaan ivm 10W minder max verbruik, en ik doe nog wel eens m'n machine goed laten stampen voor e.a

ik ga volgende maand een 90w of 120w picovoeding aanschaffen om zo verbruik nog verder omlaag te brengen.

Daarnaast heb ik nu iets van 5 schijven er inzitten, wat allemaal oude braggels zijn. Ook dit ga ik nog terug brengen naar 1x2Tb of misschien 2x 1Tb 2.5"

ik ga dan ook terug naar 1 of 2 schijven 2.5" en een ssdsloth schreef op vrijdag 04 januari 2013 @ 18:50:

Met 5 schijven zou ik toch niet met een PicoPSU gaan klooien..Het scheelt helaas ook niet zo veel dat je de extra kosten t.o.v. een efficiënte 80+ PSU kan verantwoorden.

Je vergelijking loopt krom, SR-IOV zit ook gewoon in ESXi en is wat anders dan VMDirectPath I/O (de technologie die gebruik maakt van VT-d). Zie ook http://www.vmware.com/fil...-Technical-Whitepaper.pdfDeveon schreef op vrijdag 04 januari 2013 @ 15:21:

Zijn er trouwens al mensen bekend met SR-IOV in HyperV 3.0 en of dit beter werkt als VT-d in ESX?

while (! ( succeed = try ()));

Hyper-V in Windows Server 2012 provides support for 320 logical processors and 4 TB of system memory, which enables customers to run Hyper-V on the largest scale-up server systems currently available. Hyper-V enables customers to virtualize their most-demanding, mission-critical, tier-1 workloads by supporting large, high-performance virtual machines with up to 64 virtual processors and 1 TB of memory in a virtual machine. By projecting a virtual NUMA topology into large virtual machines, the guest operating system and applications such as SQL Server can leverage their existing thread scheduler and memory allocation optimizations, which ensures maximum performance and scalability of demanding workloads in a virtual machine. Support for SR-IOV–capable systems and network devices allows SR-IOV–capable network adapters to be assigned directly to a virtual machine, which maximizes network throughput while minimizing network latency as well as the CPU overhead required for processing network traffic.

Requirements

One or more installations of Windows Server 2012 with the Hyper-V role installed. Hyper-V requires a server that is capable of running Hyper-V. Specifically, it must have processor support for hardware virtualization.

The number of virtual processors that may be configured in a virtual machine depends on the number of processors on the physical computer. You must have at least as many logical processors in the virtualization host as the number of virtual processors required in the virtual machine. For example, to configure a virtual machine with the maximum of 64 virtual processors, you must be running Hyper-V on a virtualization host that has 64 or more logical processors.

SR-IOV networking requires:

A host system which supports SR-IOV (for example, Intel VT-d), including chipset support for interrupt and DMA remapping, and proper firmware support to enable and describe the platform’s SR-IOV capabilities to the operating system.

An SR-IOV–capable network adapter and driver in both the management operating system (which runs the Hyper-V role) and each virtual machine where a virtual function is assigned.

Even niets...

Dit met de vSphere Client GUI. Wanneer ik probeer in te loggen is er een error dat het password incorrect is.

Heeft iemand een idee wat de maximum password lenght is? Mogelijk dat hij het 32 character password truncate tot een bepaalde lengte oid? Kon hier niet zo meteen wat over vinden.

Even niets...

Wat ook zou kunnen is dat er wat mis gaat bij het gebruik van "-" als onderdeel van de passphrase.

Voor alle zekerheid nu maar een 30 karakter password ingesteld zonder liggend streepje. Blij dat ik niet moet herinstalleren

Jammer geen info over de 2 NIC's.

http://www.tinygreenpc.com/microsvr.aspx

- Dit ding zou gratis ("Free") moeten zijn, maar de licentie staat op Trial en ik kan niet vinden waar ik die zou moeten wijzigen. "Licenses" of "License Management" heb ik nog niet kunnen vinden.

- Ik krijg de "Raw Device Mappings" niet werkend, dus ik kan geen disk rechtstreeks aan een VM geven.

Ik heb wel ontdekt hoe ik een netwerk kaart aan een VM kan geven, maar dat werkt blijkbaar middels de hierarchie via de CPU-chipset-bus-etc, dus als ik 1 PCI device wil vrijgeven moeten ze allemaal vrij gegeven worden. Klopt dat?

Over RDM: http://vm-help.com/esx40i/SATA_RDMs.php

Over VT-d, nee dat moet niet. Dat geld alleen voor devices die achter dezelfde PCIe root hub zitten. Soms delen devices dezelfde PCIe poort, als dat zo is, moet je ze beide doorgeven aan dezelfde VM.

(Dit komt omdat eigenlijk niet het device aan de VM gegeven word, maar de PCIe poort)

Even niets...

Bijvoorbeeld: de PEG6i bestaat uit drie intel dual port kaarten, die je aan 3 verschillende VMs kan toekennen. Deze kaart is overigens vrij goedkoop op ebay te vinden.FireDrunk schreef op zaterdag 05 januari 2013 @ 23:02:

Free wil niet zeggen zonder key. Je moet je even bij VMware.com registeren en daar ESXi HyperVisor downloaden, als je daar kijkt, zie je halverwege wel ergens een key in beeld verschijnen.

Over RDM: http://vm-help.com/esx40i/SATA_RDMs.php

Over VT-d, nee dat moet niet. Dat geld alleen voor devices die achter dezelfde PCIe root hub zitten. Soms delen devices dezelfde PCIe poort, als dat zo is, moet je ze beide doorgeven aan dezelfde VM.

(Dit komt omdat eigenlijk niet het device aan de VM gegeven word, maar de PCIe poort)

Dat weet ik, maar de manual zegt dat ik de license key (die ik bij download had gekregen) kan invoeren door naar "Home"->"Administration"->"Licenses" te gaan. Ik heb onder "Administration" echter alleen "Roles" en "System Logs".FireDrunk schreef op zaterdag 05 januari 2013 @ 23:02:

Free wil niet zeggen zonder key. Je moet je even bij VMware.com registeren en daar ESXi HyperVisor downloaden, als je daar kijkt, zie je halverwege wel ergens een key in beeld verschijnen.

YES! Thanks, dit werkt.Over RDM: http://vm-help.com/esx40i/SATA_RDMs.php

Tsja, dat zal wel komen omdat het een PCI kaartje is, en niet een PCIe.Over VT-d, nee dat moet niet. Dat geld alleen voor devices die achter dezelfde PCIe root hub zitten. Soms delen devices dezelfde PCIe poort, als dat zo is, moet je ze beide doorgeven aan dezelfde VM.

(Dit komt omdat eigenlijk niet het device aan de VM gegeven word, maar de PCIe poort)

Tijd om te gaan slapen... Cheers!

PCI is nooit met VT-d door te geven, het is een PCIe only functie.

Als je HEEL veel mazzel hebt, is de PCi poort op een PCIe controller gezet, en kan je die doorgeven, maar het eerste moederbord waarmee dat kan, moet ik nog zien.

Even niets...

Bij mij (IOMMU) kan ik op ESXi 5.1 wel PCI-bussen doorgeven, maar VM opstarten met zo'n device gekoppeld --> PSOD.

[ Voor 25% gewijzigd door Compizfox op 06-01-2013 00:27 ]

Gewoon een heel grote verzameling snoertjes

Even niets...

Ah, dus daar zat dat ding. Kijken naar wat er gelicenseerd is laat je de licentie key invullen...FireDrunk schreef op zaterdag 05 januari 2013 @ 23:53:

Key = Host selecteren, tabje rechts advanced, links in de rij ergens staat licensed features, daar kan je de key wijzigen.

Ach, ik heb de PCI kaart nu als admin interface, de chipset ethernet poort kan ik wel zo uitdelen.PCI is nooit met VT-d door te geven, het is een PCIe only functie.

Als je HEEL veel mazzel hebt, is de PCi poort op een PCIe controller gezet, en kan je die doorgeven, maar het eerste moederbord waarmee dat kan, moet ik nog zien.

Nogmaals bedankt. Ik zal een verslagje op m'n blog zetten, ik had daar ook al eens iets over KVM en netwerk bridges gezet. (http://eleganceinsoftware.wordpress.com)

Bij wijze van test heb ik wel eens een PCI WLAN adapter doorgegeven aan een Windows VM. Dat was met een Super MIcro X9SCA-F, E3 1220L CPU en ESXi 5.0.FireDrunk schreef op zaterdag 05 januari 2013 @ 23:53:

PCI is nooit met VT-d door te geven, het is een PCIe only functie.

Als je HEEL veel mazzel hebt, is de PCi poort op een PCIe controller gezet, en kan je die doorgeven, maar het eerste moederbord waarmee dat kan, moet ik nog zien.

Dat kan je in het VMDirectPath venster ook zien. Het is dan niet een direct item in de lijst, maar een child van een ander device. Dát device kan je dan doorgeven, en niet de PCI kaart.

Vaak krijg je zelfs een waarschuwing als: "You have selected a PCIe root port, all subsystems have been enabled for passthrough automatically" ofzo.

[ Voor 68% gewijzigd door FireDrunk op 06-01-2013 11:42 ]

Even niets...

Die bovenste is mijn onboard SATA-controller.

Daaronder zit een ding wat een interne bridge in een PCI-e videokaart lijkt. (waarom PCI to PCI staat aangegeven weet ik niet, het ding is PCI-e)

Daaronder zit een PCI-bridge met een onboard USB3-controller. Ook daar weet ik niet waarom er PCI staat, je zou verwachten dat USB3 onboard met PCIe is aangesloten.

Deze USB3-controller kan ik selecteren zonder dat de bridge 'meegeselecteerd' wordt! Echter, als ik daarna ESXi reboot (is nodig blijkbaar), is hij gewoon weer unselected na de reboot.

Daaronder zit weer een PCI-bridge met twee PCI-kaarten. Als ik 1 van de twee wil selecteren, selecteert hij de hele PCI-bridge. Als ik zo'n PCI device wil doorgeven aan een VM, crasht ESXi met een PSOD zodra ik de VM opstart.

Daaronder zit nog mijn onboard NIC, die heb ik uiteraard nog niet geprobeerd voor passthrough omdat ESXi die zelf nodig heeft

Van al die PCI-bridges geeft hij trouwens aan dat ze niet passthrough-capable zijn, maar zodra ik hun child item selecteer gaat het blijkbaar wel.

[ Voor 6% gewijzigd door Compizfox op 06-01-2013 13:45 ]

Gewoon een heel grote verzameling snoertjes

ESXi detecteert dat het een bridge is, en geeft aan dat je die niet kan doorgeven, omdat het eigenlijk een transport device is, en niet een eigen device.

@b.laverman.

ESXi 5.1 of 5.0? 5.1 schijnt een nogal crappy VT-d implementatie te hebben.

Even niets...

5.1FireDrunk schreef op zondag 06 januari 2013 @ 15:35:

ESXi 5.1 of 5.0? 5.1 schijnt een nogal crappy VT-d implementatie te hebben.

Even niets...

Ja, dat snap ik.FireDrunk schreef op zondag 06 januari 2013 @ 15:35:

@CompizFox, Zo'n bridge is natuurlijk helemaal niets op zichzelf. Het kan in theorie dus wel, maar dan krijg je sowieso het device wat erachter zit. Beetje net als het doorgeven van een HBA via VT-d, je krijgt dan sowieso de schijven die erachter zitten.

ESXi detecteert dat het een bridge is, en geeft aan dat je die niet kan doorgeven, omdat het eigenlijk een transport device is, en niet een eigen device.

Wat ik niet snap is waarom ESXi het PCI-to-PCI-bridges noemt, zelfs wanneer het om PCIe-sloten en -devices gaat.

En jij zegt:

Dat is dus het geval, maar het werkt nietDat kan je in het VMDirectPath venster ook zien. Het is dan niet een direct item in de lijst, maar een child van een ander device. Dát device kan je dan doorgeven, en niet de PCI kaart.

Ik heb exact hetzelfde probleem. Een PSOD, toch? Er was een patch die dit zou oplossen, maar na het installeren ervan crasht ESXi nog steeds. Nu wel met een andere error code in de PSODb.laverman schreef op zondag 06 januari 2013 @ 15:32:

Ah... hmmm... als ik de PCI netwerk kaart aan de VM geef en de VM opstart, crasht de host. Hard. reproduceerbaar.

Gewoon een heel grote verzameling snoertjes

Daar zijn de foutmeldingen doorgaans iets beter.

(neemt niet weg dat ook daar de hele kernel op zijn gat kan gaan..

[ Voor 19% gewijzigd door FireDrunk op 06-01-2013 18:26 ]

Even niets...

In mensentaal: Mellanox of VMware waren bezig met de IB stack onder handen te nemen. Mellanox kwam normaal in december uit met een nieuwe driver die SRP zou toevoegen onder 5.1. VMware zou binnenkort een update/patch/iets uitbrengen dat langs hun kant meer features zou toevoegen (zoiets als VT-D op infiniband niveau meer hier).

Wat Pantagruel zegt.

[ Voor 39% gewijzigd door analog_ op 07-01-2013 12:33 ]

ESXi 5.1 is al uit

Even niets...

Wat hij denk ik bedoeld te zeggen is dat, als je Infiniband (IB) in combinatie met ESXi wilt gebruiken, je eigenlijk genoegen moet nemen met:FireDrunk schreef op zondag 06 januari 2013 @ 21:10:

Die laatste zin is zo brak geformuleerd, dat ik hem eerlijk gezegd niet snap

ESXi 5.1 is al uit

- ESXi 4 ivm IB driver ondersteuning en goed werkende SRP support (wat de voorkeur heeft boven iSCSI) om een SRP target aan ESXi als storage te kunnen geven.

of

- De 'voordelen' van ESXi 5.x boven v4, maar 'jammer genoeg' iSCSI moet gebruiken en tanden knarsend met de beperkte doorvoersnelheid van iSCSI over IB moet leren leven. Dit omdat er nog steeds geen werkend SRP support is onder ESXI 5.x voor Mellanox hardware.

Maar dit is ook maar mijn interpretatie van het IB probleem onder ESXi 5.x, ik kan het bij het foute einde hebben (meer info op t vmware forum).

[ Voor 5% gewijzigd door Pantagruel op 07-01-2013 13:25 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Hoe zal RDM werken met Server 2008 R2? Ik heb op dit moment een Server 2008 R2 server en hier draai ik FlexRAID op met een redelijk aantal hardeschijven. Nu zit ik aan het upgraden van de server te denken maar wil de FlexRAID installatie intact houden aangezien dat goed bevalt. De overhead van losse arrays zou te groot zijn omdat de hardeschijven verschillen qua formaat.FireDrunk schreef op vrijdag 04 januari 2013 @ 14:53:

RDM kan wel, maar is nog steeds een beetje apart terrein... Er zijn slechte en goede verhalen.

Physical RDM zou werken met ZFS, maar Physical RDM werkt weer niet met FreeBSD 9.1.

Je moet dan dus FreeBSD 9.0 draaien.

Heeft te maken met de MPTSAS drivers.

Zou ik met ESXi gewoon alle huidige schijven via RDM door kunnen geven zodat de schijven exact in dezelfde staat worden doorgegeven zoals ze nu zijn? Dan zou migratie namelijk flink kunnen schelen.

Dan hoef ik enkel een moederbord te hebben dat volledig werkt in ESXi met een leuke CPU en wat geheugen.

En ik zit met een PCI-E HDD controller. Geen RAID controller, enkel losse schijven. Zal dat ook prima werken? Gaat om een Rocket 620 van High point (pricewatch: Highpoint Rocket 620).

[ Voor 11% gewijzigd door Tsurany op 07-01-2013 13:15 ]

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

De PVSCSI controller kan ook, maar daar is volgens mij van bekend dat die niet zo goed om kan gaan met bad sectors. Of dat daadwerkelijk effect heeft op je Unraid install weet ik niet.

Die Highpoint RocketRAID werkt volgens mij niet onder ESXi. Je kan eens rondzoeken op internet of het ding werkt onder ESXi. Als hij werkt en je ESXi installatie ziet je schijven, kan je daar RDMś van maken. Dat is controller onafhankelijk.

Ik voorzie geen problemen met RDM in jouw situatie.

Even niets...

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Aan te raden is een M1015 (en dan crossflashen naar IT-mode).

Even niets...

Enig idee waar ik een specsheet kan vinden?

while (! ( succeed = try ()));

Google wil je wel eens van dienst zijn. Delta heeft een product pdf van de DPS-300AB-9 online staan. En van de wazige term >70% bij efficiency krijg ik geen feest gevoel.hans_lenze schreef op maandag 07 januari 2013 @ 15:10:

Ik probeer uit te vinden hoe efficient een Delta DPS-300AB-50 A is. (300W OEM voeding met een sticker 'high efficiency er op).

Enig idee waar ik een specsheet kan vinden?

[ Voor 6% gewijzigd door Pantagruel op 07-01-2013 15:19 ]

Asrock Z77 Extreme6, Intel i7-3770K, Corsair H100i, 32 GB DDR-3, 256 GB Samsung SSD + 2 x 3TB SATA, GeForce GTX 660 Ti, Onboard NIC and sound, SyncMaster 24"&22" Wide, Samsung DVD fikkertje, Corsair 500R

Mja, die ziet er inderdaad niet erg top uit.Pantagruel schreef op maandag 07 januari 2013 @ 15:18:

Google wil je wel eens van dienst zijn. Delta heeft een product pdf van de DPS-300AB-9 online staan. En van de wazige term >70% bij efficiency krijg ik geen feest gevoel.

Als hij lijkt op een DPS-400AB-14 word ik weer heel blij.

Zoals ik al zei, ik ben op zoek naar info maar ik vind het niet echt.

while (! ( succeed = try ()));

AMD klinkt een beetje... eng met ESXi.FireDrunk schreef op maandag 07 januari 2013 @ 13:59:

AMD heeft 8*SATA600 borden, anders moet je richting een losse controller gaan.

Aan te raden is een M1015 (en dan crossflashen naar IT-mode).

Zou deze pricewatch: ASRock B75 Pro3-M geen optie zijn? Die heeft 8 SATA poorten. Dan is het een schijf gebruiken voor datastore, vijf schijven doorsturen met RDM en de tweede controller rechtstreeks aan de VM geven.

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Waarom? Juist bij AMD heb je featues zoals IOMMU al op goedkopere chipsets en CPU's.

Bij Intel heb je VT-d pas vanaf i5 en bij de duurdere chipsets.

Bij AMD zit op elke Bulldozer-CPU en elke 9xx-chipset IOMMU, en zijn er goedkopere borden te vinden met IOMMU-support.

Ik heb zelf een AMD FX-8120 met een Asrock 970 Extreme3 (met IOMMU dus!)

Voor mij was het echt een killer-feature om voor AMD te kiezen. Nadeel van AMD is wel het hogere stroomverbruik vergeleken met Intel Ivy Bridge.

[ Voor 12% gewijzigd door Compizfox op 07-01-2013 21:10 ]

Gewoon een heel grote verzameling snoertjes

Dat werkt dus niet,, die controller wordt niet goed doorgegeven. Iig niet in mijn setup met een i5 3330. Pantagruel was daar ook mee aan het klooien geloof ik. Twee pagins terug wordt er nog over gediscussieerd.Tsurany schreef op maandag 07 januari 2013 @ 20:45:

[...]

AMD klinkt een beetje... eng met ESXi.

Zou deze pricewatch: ASRock B75 Pro3-M geen optie zijn? Die heeft 8 SATA poorten. Dan is het een schijf gebruiken voor datastore, vijf schijven doorsturen met RDM en de tweede controller rechtstreeks aan de VM geven.

Compromises are for the weak

AMD's IOMMU is onder alle HyperVisors die IOMMU ondersteunen, volgens mij supported.

(KVM, Xen, en ESXi)

Even niets...

SMA SB5.0 + 16x Jinko 310wp OWO + 10x Jinko 310wp WNW |--|--| Daikin 4MXM68N + 1x FTXA50AW + 3x FTXM20N

Ik denk dat je ongeveer quite speelt.

Even niets...

Let op: Dit is geen 'algemeen ESxi-topic'. Ook je algemene VT vragen horen hier niet thuis!

Lees voor je begint goed de start post en blijf ontopic.

:strip_exif()/u/70909/BlueKachina_60x60.gif?f=community)

/u/1595/crop6564b5fdadb94_cropped.png?f=community)

:strip_icc():strip_exif()/u/286431/crop680f6b95743ca_cropped.jpg?f=community)

:strip_icc():strip_exif()/u/54374/kite.jpg?f=community)

/u/18936/crop6402808ba605b.png?f=community)

/u/24671/crop55d1ea05b175b.png?f=community)

/u/345718/ding.png?f=community)

:strip_exif()/u/272568/ssbbdl03sm.gif?f=community)

/u/84171/crop6882249156de0_cropped.png?f=community)

:strip_icc():strip_exif()/u/3454/i486.jpg?f=community)