Switch: Juniper EX4550-32F

Doel: Synolgy NAS

bron: ESXi host

LACP is geen optie, daar heb ik een distributed vswitch voor nodig maar de ESXi licentie laat dit niet toe.

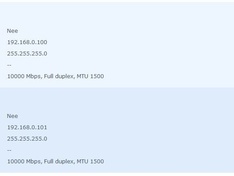

Nas is gekopeld via NFS4.1 met multipath op 2 verschillende IP adressen. (langs de switch kant zijn dit 2 gewone poorten die niet gelinkt zijn)

Gezien ESXi enkel NFS multipath server side ondersteund kan ik niet hetlzefde doen daar.

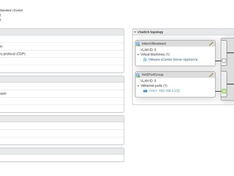

Voor ESXi heb ik een vswitch met teaming actief op Route based on IP hash met daaraan 2 uplinks met 1 IP adres.

Langs de switch zijn kant zijn die 2 poorten gekoppeld aan elkaar met LACP op none.

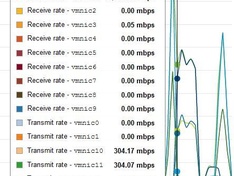

De NAS gebruikt zijn 2 links voor zowel send als recieve.

De ESXi gebruikt enkel zijn 2 links voor transmit (en verdeeld de load perfect) maar bij recieve komt alles via 1 link binnen.

Is dit de switch die zijn werk niet doet of zie ik iets over het hoofd?

Doel: Synolgy NAS

bron: ESXi host

LACP is geen optie, daar heb ik een distributed vswitch voor nodig maar de ESXi licentie laat dit niet toe.

Nas is gekopeld via NFS4.1 met multipath op 2 verschillende IP adressen. (langs de switch kant zijn dit 2 gewone poorten die niet gelinkt zijn)

Gezien ESXi enkel NFS multipath server side ondersteund kan ik niet hetlzefde doen daar.

Voor ESXi heb ik een vswitch met teaming actief op Route based on IP hash met daaraan 2 uplinks met 1 IP adres.

Langs de switch zijn kant zijn die 2 poorten gekoppeld aan elkaar met LACP op none.

De NAS gebruikt zijn 2 links voor zowel send als recieve.

De ESXi gebruikt enkel zijn 2 links voor transmit (en verdeeld de load perfect) maar bij recieve komt alles via 1 link binnen.

Is dit de switch die zijn werk niet doet of zie ik iets over het hoofd?

:strip_exif()/u/216514/sgisurf.gif?f=community)

/u/35508/crop61e6aa7b579e2_cropped.png?f=community)

/u/125506/link-8bit.png?f=community)

:strip_icc():strip_exif()/u/3550/S2462.jpg?f=community)