hallo

ik open dit topic omdat ik momenteel in een klein bedrijf een nieuwe server omgeving wil gaan inrichten en daar wellicht wat advies in kan gaan gebruiken.

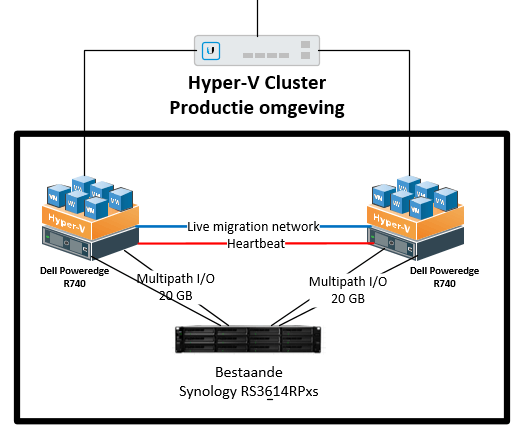

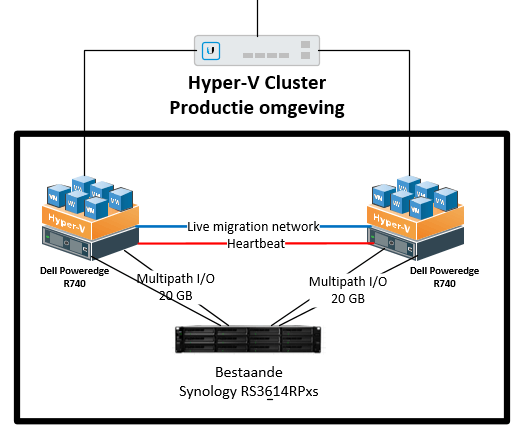

plan is als volgt: momenteel draaien er veel oude server in de omgeving. dit wil ik terug gaan brengen naar 2 failover nodes met daarop hyper-v en physical to virtual gaan uitvoeren.

nu draait er ook een Synology RS3614RPxs deze is nog geen jaar oud. met zo'n 20TB het idee is om deze Syno te gaan her inrichten en daar LUN's op te zetten voor de Cluster shared volumes. en dit d.m.v multipath io aan de 2 nodes te hangen. (2x Dell Poweredge R740) 2x 10GB teamed nic naar de Syno

het plan is om zo'n 20 vm's te gaan draaien in die cluster. plan is ook later om iets met VDI te gaan doen daarin. maar qua performance oogpunt lijkt mij dat niet een goed plan

nu is mijn vraag zijn er ook mensen met ervaring die een goeie hyper-v failovercluster icm een Synology NAS. performance, stabiliteit etc

nu twijfel ik zelf over de performance. dat de vm daar issues mee gaan geven.

ik begrijp dat de Syno dan een singlepoint of failure zal zijn. maar omdat we nu eenmaal die syno hebben ben ik de mogelijkheden aan het bekijken. aangezien Synology dit op hun site dit toch aanprijst (bron)

anders neig ik toch naar een SAN oplossing met HBA controllers. maar hier ligt de investering weer hoger

ik open dit topic omdat ik momenteel in een klein bedrijf een nieuwe server omgeving wil gaan inrichten en daar wellicht wat advies in kan gaan gebruiken.

plan is als volgt: momenteel draaien er veel oude server in de omgeving. dit wil ik terug gaan brengen naar 2 failover nodes met daarop hyper-v en physical to virtual gaan uitvoeren.

nu draait er ook een Synology RS3614RPxs deze is nog geen jaar oud. met zo'n 20TB het idee is om deze Syno te gaan her inrichten en daar LUN's op te zetten voor de Cluster shared volumes. en dit d.m.v multipath io aan de 2 nodes te hangen. (2x Dell Poweredge R740) 2x 10GB teamed nic naar de Syno

het plan is om zo'n 20 vm's te gaan draaien in die cluster. plan is ook later om iets met VDI te gaan doen daarin. maar qua performance oogpunt lijkt mij dat niet een goed plan

nu is mijn vraag zijn er ook mensen met ervaring die een goeie hyper-v failovercluster icm een Synology NAS. performance, stabiliteit etc

nu twijfel ik zelf over de performance. dat de vm daar issues mee gaan geven.

ik begrijp dat de Syno dan een singlepoint of failure zal zijn. maar omdat we nu eenmaal die syno hebben ben ik de mogelijkheden aan het bekijken. aangezien Synology dit op hun site dit toch aanprijst (bron)

anders neig ik toch naar een SAN oplossing met HBA controllers. maar hier ligt de investering weer hoger

/u/164382/android_developer_thumb.png?f=community)

:strip_icc():strip_exif()/u/85308/mirko.jpg?f=community)

/u/28318/crop59d5ed176e52f_cropped.png?f=community)

/u/117492/crop5f8ef6919e9fc_cropped.png?f=community)

:strip_icc():strip_exif()/u/84973/images.jpg?f=community)

/u/96077/crop5b8d7c89bae9d_cropped.png?f=community)

/u/35508/crop61e6aa7b579e2_cropped.png?f=community)