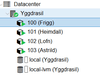

Ik ben in mijn homelab bezig om een Proxmox/Ceph cluster te proberen.

Een snelle situatieschets:

kom ik uit op

wanneer ik handmatig de mfs wil starten blijft hij hangen op:

waarna de container blijft hangen op:

tot een timeout plaatsvind

Het resultaat is dus dat ik in mijn containers, het CephFs Filsystem niet aan de praat krijg. heeft iemand hier ervaring mee?

mijn ceph.conf

Een snelle situatieschets:

- 1 server

- 24 x Intel(R) Xeon(R) CPU E5-2620 0 @ 2.00GHz (2 Sockets)

- 64 GB Ram

- 500GB boot ssd + lvm storage

- Proxmox VE hypervisor

- Ceph

- [list]

- 3 osd's van 1 TB

- 1 monitor

- 2 pools (cephfs_data + cephfs_metadata)

- 1 filesystem (cephfs)

- [/list]

code:

1

2

| Root@Yggdrasil:~# ceph mds stat: cephfs-1/1/1 up |

kom ik uit op

code:

1

2

| Root@Yggdrasil:~# ceph mds stat: cephfs-0/0/1 up |

wanneer ik handmatig de mfs wil starten blijft hij hangen op:

code:

1

2

| root@Yggdrasil:/etc/pve# ceph-mds --cluster ceph -i mds -m Yggdrasil:6789 -f starting mds.mds at - |

waarna de container blijft hangen op:

code:

1

2

| ceph-fuse[706]: starting ceph client 2017-12-29 23:14:49.369974 7f9e0b5ee6c0 -1 init, newargv = 0x55a20df4cb00 newargc=14 |

tot een timeout plaatsvind

Het resultaat is dus dat ik in mijn containers, het CephFs Filsystem niet aan de praat krijg. heeft iemand hier ervaring mee?

mijn ceph.conf

code:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

| [global]

auth client required = cephx

auth cluster required = cephx

auth service required = cephx

cluster network = 10.10.10.0/24

fsid = e88ab795-a442-4b69-af41-20cb86111452

keyring = /etc/pve/priv/$cluster.$name.keyring

mon allow pool delete = true

osd cruch chooseleaf type = 0

osd journal size = 5120

osd pool default min size = 1

osd pool default size = 3

public network = 10.10.10.0/24

[osd]

keyring = /var/lib/ceph/osd/ceph-$id/keyring

[mon.Yggdrasil]

host = Yggdrasil

mon addr = 10.10.10.1:6789

[mds.mds]

host= mds |

:strip_exif()/i/2003599062.png?f=thumbmini)

/u/517001/crop610128fa1e7fb_cropped.png?f=community)

/u/125506/link-8bit.png?f=community)