Slechte performance vanwege NAS

Enige tijd geleden ben ik begonnen met het zoeken naar een vervanging voor mijn huidige zelfstudie VMware Homelab. Het ging hierbij om een budget "server" met een AMD FX-8350 en 32GB geheugen. Deze draaide overigens de nieuwe ESXi 6.5, maar ik wilde meer geheugen en de onderliggende storage (een QNAP 419 PII) hield bij een VM of acht op te functioneren.

Omdat het uiteindelijk toch om studie gaat voor onder andere mijn werkgever, heb ik hiervoor budget geregeld. Het is thuis lastig uit te leggen dat je zoveel geld uitgeeft aan iets waar je werkgever ook veel belang bij heeft. Het is zelfstudie (certificeringen), troubleshooten klantproblemen/migraties en natuurlijk ook mijn eigen carrière in de ICT business. Zit op detacheringsbasis bij klanten voor voornamelijk Systeembeheer, maar doe er vaak veel naast.

Ik wilde dit dus naar een hoger platform tillen en hierbij heb ik ook gekeken naar een zwaardere NAS en managed switches. Ik kwam er al snel achter dat ik dan behoorlijk wat geld kwijt was aan uiteindelijk minimale performance. De beperkende factor is dan voornamelijk de 1Gbit verbindingen, waarbij 10Gbit of de NAS te duur worden. En dus besloot ik om dit budget te gebruiken voor betere hardware in de kast en het virtueel op te lossen. Natuurlijk wil ik jullie meenemen in wat ik neergezet heb en wie weet doen jullie ideeën op, hebben jullie nog suggesties of verklaren mij compleet voor gek.

Het ontwerp

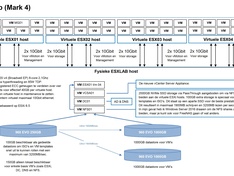

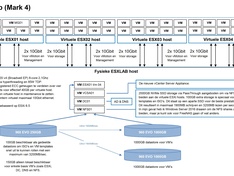

Het ontwerp voor de Mark4 (niet geheel toevallig mijn naam, een naamgevingssysteem en alweer mijn vierde VMware HomeLab ) gaat uit van nested ESXi's. Deze nested/virtuele ESXi's zullen op hun beurt dan de overige VM's draaien. De fysieke host draait naast de nested ESXi's ook nog een Domain Controller voor authenticatie, DNS en eventueel DHCP indien nodig. Er is nog een Windows Server 2016 actief die NFS shares geeft aan de vSphere omgeving en de VCSA appliance zelf staat hier ook op. Je hoeft met deze opzet alleen de VM's op de fysieke host te starten en je gehele basis is actief.

) gaat uit van nested ESXi's. Deze nested/virtuele ESXi's zullen op hun beurt dan de overige VM's draaien. De fysieke host draait naast de nested ESXi's ook nog een Domain Controller voor authenticatie, DNS en eventueel DHCP indien nodig. Er is nog een Windows Server 2016 actief die NFS shares geeft aan de vSphere omgeving en de VCSA appliance zelf staat hier ook op. Je hoeft met deze opzet alleen de VM's op de fysieke host te starten en je gehele basis is actief.

Omdat ik performance belangrijk vindt heb ik niet gekozen voor een Xeon met L toevoeging (energiezuinig) of Intel NUC. De Xeon-D is erg interessant, maar beperkt tot 128GB geheugen en dit wilde ik niet als beperking. Uiteindelijk ben ik gegaan voor een volwaardige Xeon E5-2620v4 (Broadwell-EP) 2,1Ghz 8-core met hyperthreading en 95W TDP. Hierbij heb ik uiteindelijk ook gekozen voor 192GB geheugen (Registered ECC DDR4), zodat geheugen echt geen bottleneck gaat zijn bij testopstellingen. Eventueel is dit nog uit te breiden naar 256GB, maar dat lijkt mij onwaarschijnlijk.

Dit alles gaat op een Supermicro X10SRA-F serverboard met IPMI 2.0 (ILO / DRAC out-of-band management).

De opslag is geregeld door ESXi te installeren op een Samsung 960 EVO 250GB. Deze nieuwe "budget" NVMe SSD's kwamen net beschikbaar toen ik ging bestellen en heb toen besloten om volledig op deze standaard over te stappen vanwege de specificaties. De overige schrijfruimte bevat de basis VM's en een disk waar VMware templates en ISO's op staan die als NFS share aangeboden wordt (zie mijn ontwerp). Ook bevat de host nog twee Samsung 960 EVO 1TB die via Passhtrough aan de NFS server gehangen worden. Dit zal dienen als NFS datastores voor de vSphere omgeving.

De 3200MB/sec lezen (380.000 IOPS) en 1900MB/sec schrijven (360.000IOPS) moeten ervoor zorgen dat de storage geen bottleneck is in dit verhaal. Mijn verwachting is dat dit eerder zal liggen bij de virtuele 10Gbit verbindingen in combinatie met de CPU belasting die dit veroorzaakt. Nu is het een moderne 8-core, dus ik hoop een heel eind te komen.

De 960 EVO 1TB heeft een SLC cache van maar liefst 42GB, dus de kans is relatief klein dat je daar doorheen gaat. Doe je dat wel dan ga je terug naar 1200MB/sec schrijven. Daar kan ik mee leven!

De oude QNAP 419 PII NAS is ook vervangen door een Synology DiskStation DS216+II, maar is verder niet actief meer in gebruik voor VMware. Mocht ik toch plotseling veel opslagruimte nodig hebben, dan is hij echter wel als nog te koppelen als trage datastore.

Er is optioneel nog een extra 960 EVO bij te plaatsen of een refurbished videokaart die Horizon View (VDI) ondersteuning heeft.

De onderdelen

De lijst met onderdelen! Zoals je kunt zien gaat het meeste geld zitten in de kasten, processor, geheugen en SSD's.

Benchmarks en mijn ervaring

Dit weekend ga ik de twee Samsung 960 EVO's aan de NFS server hangen en kan ik gaan benchen met ATTO hoe de omgeving als geheel functioneert en of ik de performance kan halen die erin zit. Hoe snel er VMware Templates of ISO's uit te rollen zijn en hoe snel is een server leeg te vMotion'en etc. Deze zaken zijn echter erg afhankelijk van de virtuele 10Gbit performance. Hier zal deels ook nog tuning nodig zijn, maar zal waarschijnlijk niet het volledige potentieel van de 960 EVO's kunnen behalen.

Bij inrichtingsproblemen kan het echter nog wel een weekje duren voordat ik alle antwoorden heb.

Enige tijd geleden ben ik begonnen met het zoeken naar een vervanging voor mijn huidige zelfstudie VMware Homelab. Het ging hierbij om een budget "server" met een AMD FX-8350 en 32GB geheugen. Deze draaide overigens de nieuwe ESXi 6.5, maar ik wilde meer geheugen en de onderliggende storage (een QNAP 419 PII) hield bij een VM of acht op te functioneren.

Omdat het uiteindelijk toch om studie gaat voor onder andere mijn werkgever, heb ik hiervoor budget geregeld. Het is thuis lastig uit te leggen dat je zoveel geld uitgeeft aan iets waar je werkgever ook veel belang bij heeft. Het is zelfstudie (certificeringen), troubleshooten klantproblemen/migraties en natuurlijk ook mijn eigen carrière in de ICT business. Zit op detacheringsbasis bij klanten voor voornamelijk Systeembeheer, maar doe er vaak veel naast.

Ik wilde dit dus naar een hoger platform tillen en hierbij heb ik ook gekeken naar een zwaardere NAS en managed switches. Ik kwam er al snel achter dat ik dan behoorlijk wat geld kwijt was aan uiteindelijk minimale performance. De beperkende factor is dan voornamelijk de 1Gbit verbindingen, waarbij 10Gbit of de NAS te duur worden. En dus besloot ik om dit budget te gebruiken voor betere hardware in de kast en het virtueel op te lossen. Natuurlijk wil ik jullie meenemen in wat ik neergezet heb en wie weet doen jullie ideeën op, hebben jullie nog suggesties of verklaren mij compleet voor gek.

Het ontwerp

Het ontwerp voor de Mark4 (niet geheel toevallig mijn naam, een naamgevingssysteem en alweer mijn vierde VMware HomeLab

Omdat ik performance belangrijk vindt heb ik niet gekozen voor een Xeon met L toevoeging (energiezuinig) of Intel NUC. De Xeon-D is erg interessant, maar beperkt tot 128GB geheugen en dit wilde ik niet als beperking. Uiteindelijk ben ik gegaan voor een volwaardige Xeon E5-2620v4 (Broadwell-EP) 2,1Ghz 8-core met hyperthreading en 95W TDP. Hierbij heb ik uiteindelijk ook gekozen voor 192GB geheugen (Registered ECC DDR4), zodat geheugen echt geen bottleneck gaat zijn bij testopstellingen. Eventueel is dit nog uit te breiden naar 256GB, maar dat lijkt mij onwaarschijnlijk.

Dit alles gaat op een Supermicro X10SRA-F serverboard met IPMI 2.0 (ILO / DRAC out-of-band management).

De opslag is geregeld door ESXi te installeren op een Samsung 960 EVO 250GB. Deze nieuwe "budget" NVMe SSD's kwamen net beschikbaar toen ik ging bestellen en heb toen besloten om volledig op deze standaard over te stappen vanwege de specificaties. De overige schrijfruimte bevat de basis VM's en een disk waar VMware templates en ISO's op staan die als NFS share aangeboden wordt (zie mijn ontwerp). Ook bevat de host nog twee Samsung 960 EVO 1TB die via Passhtrough aan de NFS server gehangen worden. Dit zal dienen als NFS datastores voor de vSphere omgeving.

De 3200MB/sec lezen (380.000 IOPS) en 1900MB/sec schrijven (360.000IOPS) moeten ervoor zorgen dat de storage geen bottleneck is in dit verhaal. Mijn verwachting is dat dit eerder zal liggen bij de virtuele 10Gbit verbindingen in combinatie met de CPU belasting die dit veroorzaakt. Nu is het een moderne 8-core, dus ik hoop een heel eind te komen.

De 960 EVO 1TB heeft een SLC cache van maar liefst 42GB, dus de kans is relatief klein dat je daar doorheen gaat. Doe je dat wel dan ga je terug naar 1200MB/sec schrijven. Daar kan ik mee leven!

De oude QNAP 419 PII NAS is ook vervangen door een Synology DiskStation DS216+II, maar is verder niet actief meer in gebruik voor VMware. Mocht ik toch plotseling veel opslagruimte nodig hebben, dan is hij echter wel als nog te koppelen als trage datastore.

Er is optioneel nog een extra 960 EVO bij te plaatsen of een refurbished videokaart die Horizon View (VDI) ondersteuning heeft.

De onderdelen

De lijst met onderdelen! Zoals je kunt zien gaat het meeste geld zitten in de kasten, processor, geheugen en SSD's.

| # | Product | Prijs | Subtotaal |

| 1 | Intel Xeon E5-2620 v4 Boxed | € 464,95 | € 464,95 |

| 1 | Supermicro X10SRA-F (Retail Pack) | € 338,25 | € 338,25 |

| 2 | HGST Deskstar NAS, 3TB | € 113,74 | € 227,48 |

| 2 | Phanteks Enthoo Evolv ATX Tempered Glass Edition Zwart | € 170,01 | € 340,02 |

| 1 | be quiet! Straight Power 10 CM 800W | € 138,- | € 138,- |

| 1 | be quiet! Shadow Rock Slim | € 40,95 | € 40,95 |

| 1 | Razer BlackWidow X Chroma (US) | € 156,95 | € 156,95 |

| 1 | Razer Mamba Tournament Edition 5G | € 85,- | € 85,- |

| 6 | Kingston ValueRAM KVR21R15D4/32 | € 288,19 | € 1.729,14 |

| 3 | Asus Hyper M.2 X4 PCI-E Mini Card | € 31,99 | € 95,97 |

| 2 | Samsung 960 EVO 1TB | € 463,50 | € 927,- |

| 1 | Samsung 960 EVO 250GB | € 128,95 | € 128,95 |

| 1 | Synology DiskStation DS216+II | € 312,65 | € 312,65 |

| Totaal | € 4985,31 | ||

Benchmarks en mijn ervaring

Dit weekend ga ik de twee Samsung 960 EVO's aan de NFS server hangen en kan ik gaan benchen met ATTO hoe de omgeving als geheel functioneert en of ik de performance kan halen die erin zit. Hoe snel er VMware Templates of ISO's uit te rollen zijn en hoe snel is een server leeg te vMotion'en etc. Deze zaken zijn echter erg afhankelijk van de virtuele 10Gbit performance. Hier zal deels ook nog tuning nodig zijn, maar zal waarschijnlijk niet het volledige potentieel van de 960 EVO's kunnen behalen.

Bij inrichtingsproblemen kan het echter nog wel een weekje duren voordat ik alle antwoorden heb.

[ Voor 230% gewijzigd door Silencer1981 op 23-02-2017 11:20 . Reden: Corrigeren van schoonheidsfoutjes ]

"The only true wisdom is in knowing you know nothing." - Socrates

:fill(white):strip_exif()/i/2001268413.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2001197999.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2000586347.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2000902244.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/1389952871.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2000545750.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2001020859.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2001094661.jpeg?f=thumbmini)

:fill(white):strip_exif()/i/2006124152.jpeg?f=thumbmini)

:strip_icc():strip_exif()/u/97654/crop58073a7f5a66b_cropped.jpeg?f=community)

/u/35508/crop61e6aa7b579e2_cropped.png?f=community)

:strip_icc():strip_exif()/u/6607/klootviool2.jpg?f=community)

/u/242978/crop66a33d061908f_cropped.png?f=community)