Ik zit al een tijdje met een idee voor de Pricewatch in mijn hoofd.

Het is namelijk als volgt. Misschien herkennen jullie dit probleem wel. Je zoekt naar een product in de Pricewatch en je ziet een product wat je overweegt om aan te schaffen. Is dit product wel goed, vraag je jezelf af. Hmmm.. er is maar 1 review op het product. Is dat dan wel betrouwbaar genoeg om daarop af te gaan?

Bekend gevoel?

Goed natuurlijk ga je ervan uit dat iemand een eerlijke review plaatst van een product, maar toch. De een overdrijft een beetje te veel waar dat product toch niet zo goed blijkt te zijn en de ander duwt een product keihard de grond in, terwijl het product helemaal niet zo slecht is. Dit soort acties zal door de reviewers misschien onbewust of bewust zo ingevuld worden. Dus hoe betrouwbaar zijn die reviews nou werkelijk?

Ik dacht het dat misschien wel nuttig zou zijn als er iets van een betrouwbaarheidsindicator bij een product zou zijn. Als een product maar 1 review heeft is dat natuurlijk minder betrouwbaar dan een product met 10 reviews. Aan de andere kant, die ene review heeft misschien wel een beoordeling van +2 of +3 wat die ene review weer wel betrouwbaar maakt.

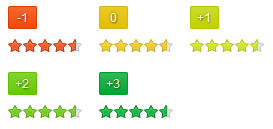

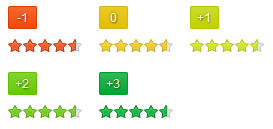

Mijn idee is om de sterren, beoordeling van een product, verschillende kleuren te geven. De dezelfde kleuren als die van de -1, 0, +1, +2 of +3 waarderingen (geen idee of ze allemaal gebruikt worden in de Pricewatch??) die mensen aan een review kunnen geven. Je zou dan kunnen kijken naar een gemiddelde (of andere formule) van deze waarderingen en aan de hand daarvan de gemiddelde beoordeling/betrouwbaarheid bepalen. Als je veel "0"-review-waarderingen en veel "+2"-reviewwaarderingen hebt, zal de waarheid ergens in het midden liggen, dus een +1 reviewwaardering. Als de reviews dan zelf een productscore van 4,5 opleverd, zal de reviewwaardering de kleur van de sterren een +1-lichtgroene kleur krijgen. Zie afbeelding hierboven.

Dus hoe groener de sterren zijn, hoe betrouwbaarder de productscore uiteindelijk is.

Tot zover mijn idee.

Het is namelijk als volgt. Misschien herkennen jullie dit probleem wel. Je zoekt naar een product in de Pricewatch en je ziet een product wat je overweegt om aan te schaffen. Is dit product wel goed, vraag je jezelf af. Hmmm.. er is maar 1 review op het product. Is dat dan wel betrouwbaar genoeg om daarop af te gaan?

Bekend gevoel?

Goed natuurlijk ga je ervan uit dat iemand een eerlijke review plaatst van een product, maar toch. De een overdrijft een beetje te veel waar dat product toch niet zo goed blijkt te zijn en de ander duwt een product keihard de grond in, terwijl het product helemaal niet zo slecht is. Dit soort acties zal door de reviewers misschien onbewust of bewust zo ingevuld worden. Dus hoe betrouwbaar zijn die reviews nou werkelijk?

Ik dacht het dat misschien wel nuttig zou zijn als er iets van een betrouwbaarheidsindicator bij een product zou zijn. Als een product maar 1 review heeft is dat natuurlijk minder betrouwbaar dan een product met 10 reviews. Aan de andere kant, die ene review heeft misschien wel een beoordeling van +2 of +3 wat die ene review weer wel betrouwbaar maakt.

Mijn idee is om de sterren, beoordeling van een product, verschillende kleuren te geven. De dezelfde kleuren als die van de -1, 0, +1, +2 of +3 waarderingen (geen idee of ze allemaal gebruikt worden in de Pricewatch??) die mensen aan een review kunnen geven. Je zou dan kunnen kijken naar een gemiddelde (of andere formule) van deze waarderingen en aan de hand daarvan de gemiddelde beoordeling/betrouwbaarheid bepalen. Als je veel "0"-review-waarderingen en veel "+2"-reviewwaarderingen hebt, zal de waarheid ergens in het midden liggen, dus een +1 reviewwaardering. Als de reviews dan zelf een productscore van 4,5 opleverd, zal de reviewwaardering de kleur van de sterren een +1-lichtgroene kleur krijgen. Zie afbeelding hierboven.

Dus hoe groener de sterren zijn, hoe betrouwbaarder de productscore uiteindelijk is.

Tot zover mijn idee.

Trans-life! :::: "All things change, whether from inside out or the outside in. That is what magic is. And we are magic too."

:strip_icc():strip_exif()/u/92368/crop67f122a4021bc.jpg?f=community)

:strip_icc():strip_exif()/u/445269/crop57863889288ba_cropped.jpeg?f=community)

:strip_icc():strip_exif()/u/58622/weird_kitten.jpg?f=community)

:strip_icc():strip_exif()/u/3550/S2462.jpg?f=community)

:strip_icc():strip_exif()/u/129865/crop5cb775b8692d8.jpeg?f=community)