♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Verwijderd

Zijn disks zijn niet stuk, althans daar ga ik niet vanuit. FakeRAID en hardware RAID vallen vaak uit door bad sectors en kabelfouten of stroomsplitterstekkertjes. De RAID laag reageert hier gewoon heel slecht op; het zit gewoon heel knullig in elkaar. De details bespaar ik je.redfoxert schreef op vrijdag 13 juli 2012 @ 21:04:

RAID5 beschermt tegen uitval van 1 disk, niet 3 tegelijk. Of je je pron kunt redden is dan dus zeer onwaarschijnlijk...

Maargoed, normaliter kun je dit voorkomen door RAID edition hardeschijven te kopen met TLER feature. Daar betaal je dan wel grof voor. Mijn advies: ga niet uit dat dit soort slechte RAID lagen je data beschermt! Als je dat wilt, gebruik dan ZFS, een topic hierover kun je in dit forum vinden. In alle andere gevallen is het hebben van een goede backup éxtra belangrijk. Ouderwets RAID gaat gewoon slecht om met bad sectors.

Maar zijn data is er gewoon nog hoor, en na wat tweaken kan hij alles gewoon recoveren. Maar dan moet hij geen fouten maken en geen wijzigingen aanbrengen, want bijvoorbeeld een 'foute' rebuild starten kan wel permanent grote blokken data vernietigen en dan is het einde verhaal. Wees kalm en als de data echt belangrijk is maak dan niet de fout door overhaast dingen te proberen!

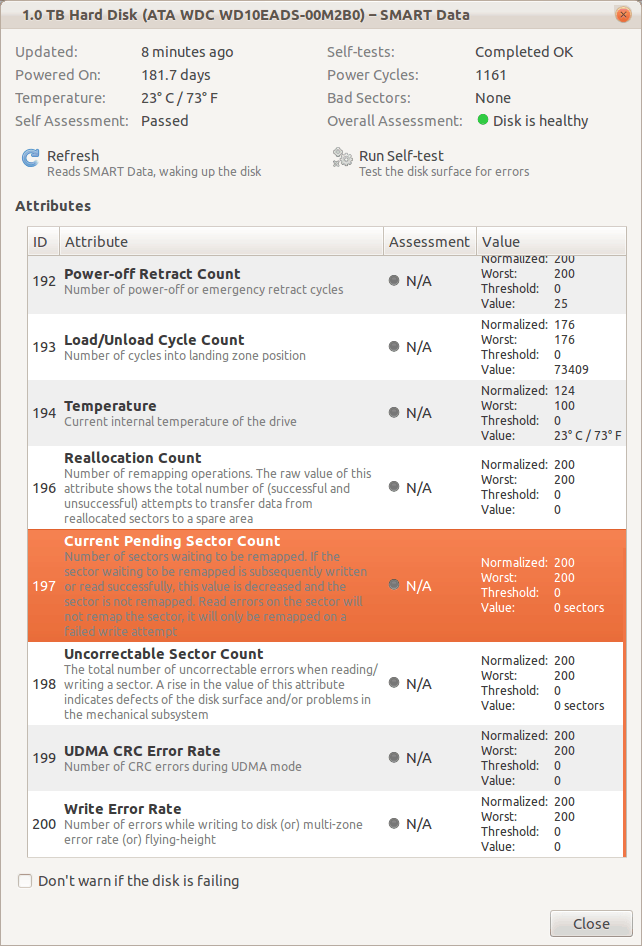

Begin eerst met de SMART data, dat is elk startpunt van opslagproblemen.

[ Voor 74% gewijzigd door Verwijderd op 13-07-2012 21:08 ]

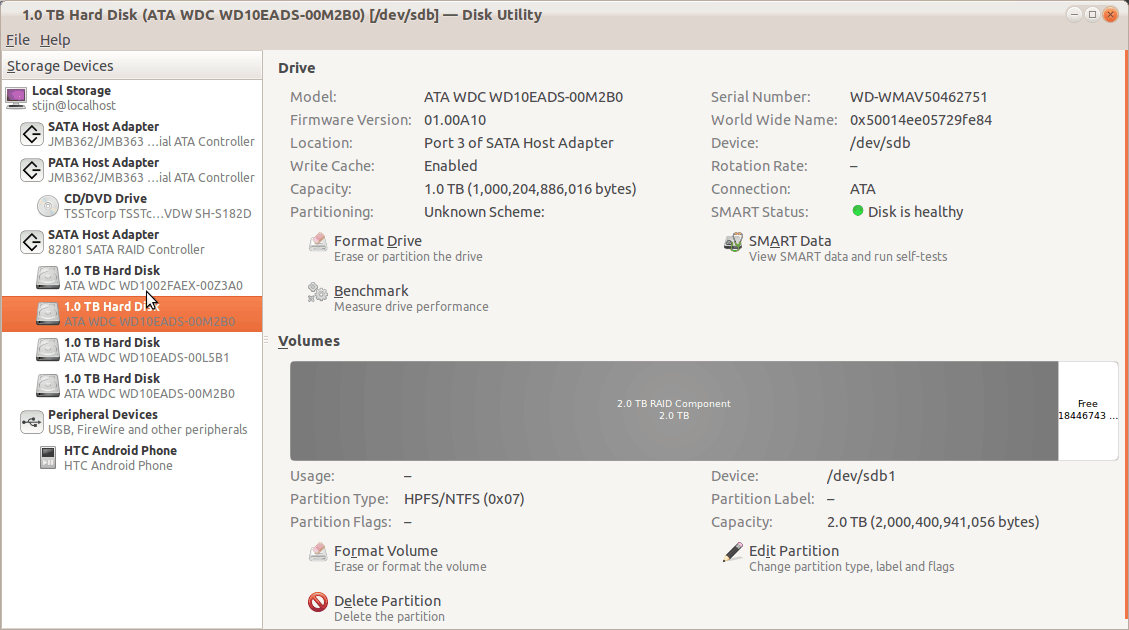

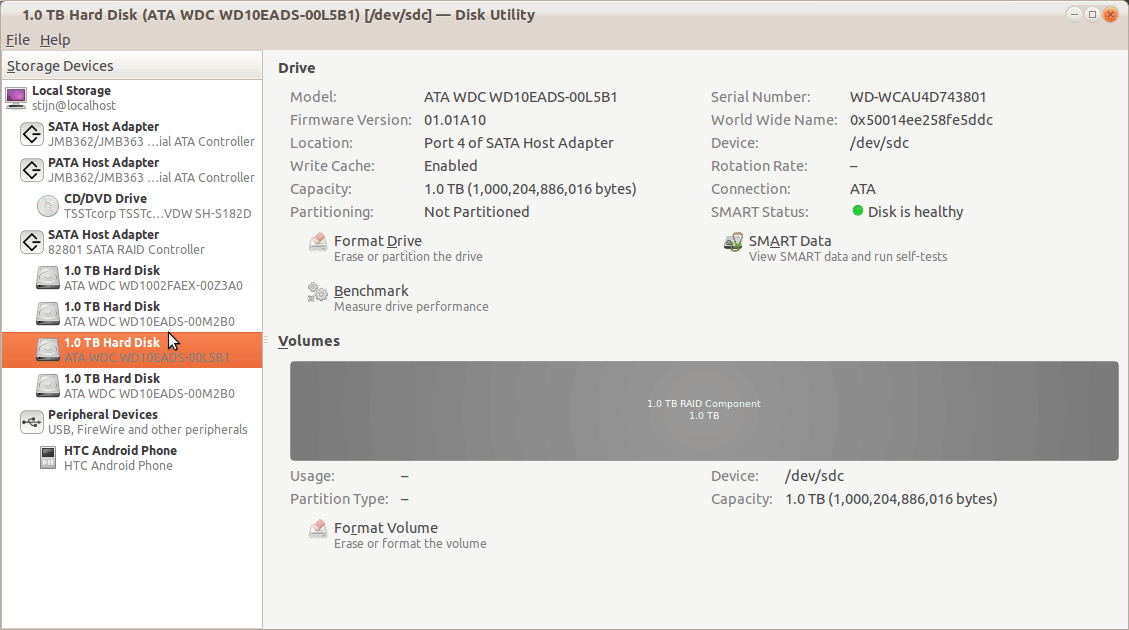

Wat me echter opviel was dat 2 HDD 2TB-raid weergaven en ééntje 1TB-raid

Beetje offtopic, maar is fakeraid echt zo onbetrouwbaar? We gebruiken dit op sommige toestellen op mijn werk en zelden of nooit problemen mee gehad (Mirrored).

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Sorry dat ik zo inhaak op dit topic, ik zit nl. met soortgelijk probleem ...

Ben al even bezig met dit euvel, en wil het nu wel eens oplossen !!

Verwijderd

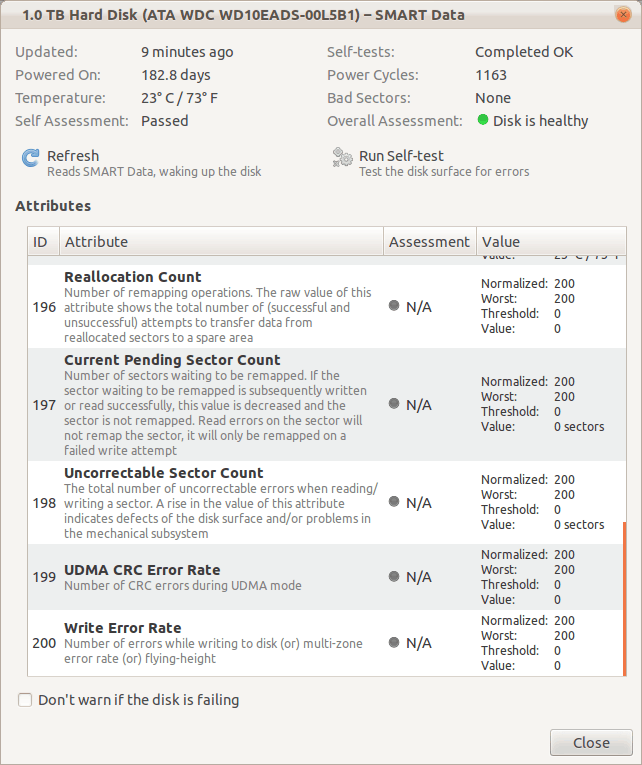

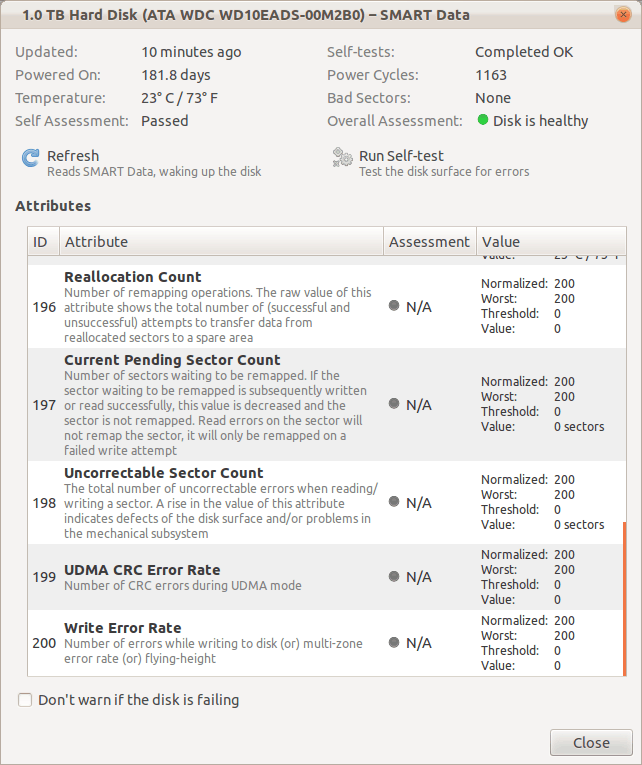

Klik dus op die knoppen en maak screenshots als je wilt, maar check in elk geval:

Current Pending Sector

UDMA CRC Error Count

Beide moeten een raw value van 0 hebben. De genormaliseerde waarden (Current/Worst/Threshold) kun je beter vergeten als je dat systeem nog niet snapt, want daar geldt juist hoe hoger hoe beter. Een waarde van 200 kan overeen komen met 0 bad sectors. Je moet het maar net even verteld krijgen hoe het werkt, want anders interpreteer je het al heel snel verkeerd.

Succes!

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Wat zegt dmraid over je array? (gebruik dmesg om de messages te vinden, eventueel nog kernel module laden)

En helpt het om de SATA mode in je BIOS te veranderen naar AHCI? Ik heb zo wel eens een NVidia fakeraid array gered. In RAID modus kreeg ik ook deze symptomen. Wel opletten dat je op geen enkele manier naar je disks schrijft. Niet in GUI mounten en als je command line iets doet, altijd read-only mounten.

Kia e-Niro 2021 64kWh DynamicPlusLine. 3x Victron MP-II op 15kWh US5000 3f thuisbatterij met 3x25A→3x40A PowerAssist, Victron EVCS, 3200Wp HoyMiles zp. my GitHub, my blog

Verwijderd

Dat is normaal. Die ene schijf heeft dan een partitietabel van de RAID-array. kortom, dit is de 'eerste' disk in de RAID-array, dus de eerste 0-128KiB staat dus op deze disk. Op de RAID-array heb je dan een 2TB partitie. Maar als je de schijven los gaat benaderen zoals Ubuntu nu doet, dan zie je dus op één schijf de partitietabel met een partitie die groter is dan de schijf zelf. Dat is volkomen normaal!IStealYourGun schreef op vrijdag 13 juli 2012 @ 21:34:

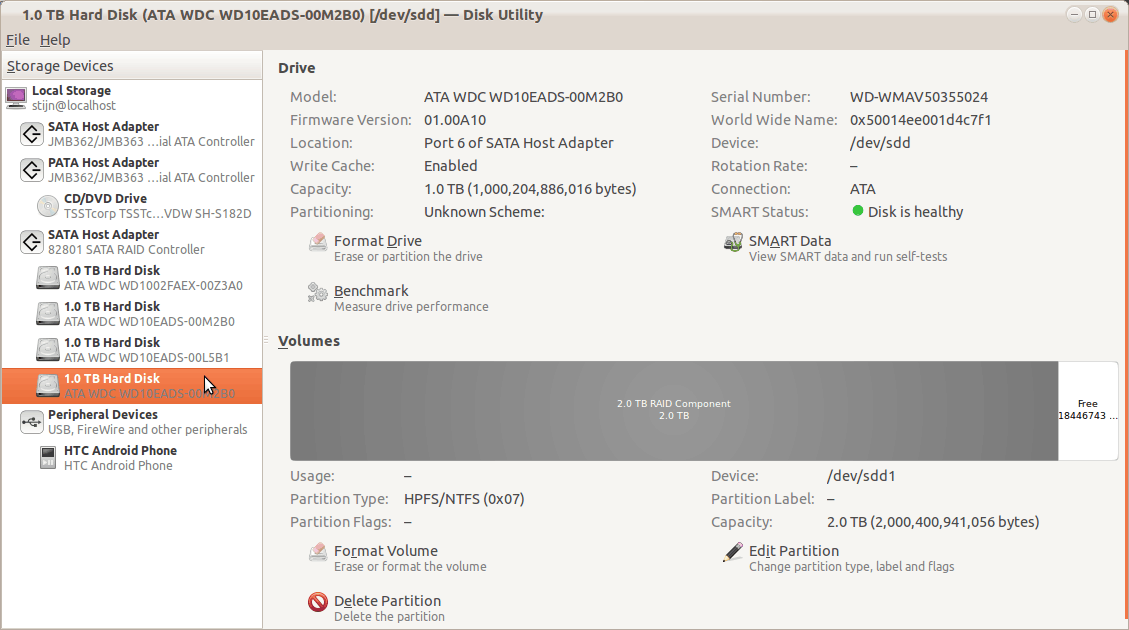

Heb alle Smart gegevens nagekeken (Ubuntu staat hier ook geïnstalleerd)

Wat me echter opviel was dat 2 HDD 2TB-raid weergaven en ééntje 1TB-raid

Ja. FakeRAID en hardware RAID kunnen zeer slecht tegen bad sectors en timeouts, juist iets wat door toegenomen datadichtheid een veel groter probleem is dan vroeger.Beetje offtopic, maar is fakeraid echt zo onbetrouwbaar? We gebruiken dit op sommige toestellen op mijn werk en zelden of nooit problemen mee gehad (Mirrored).

Je SMART ziet er verder goed uit, al zijn die maar 3 schijven die ik zie. Maar ik neem aan dat je eenzelfde beeld op de 4e schijf ziet. Dit is goed nieuws, je schijven zijn dan in orde. Je kunt dan opzich beginnen met recovery.

Dat recoveren kun je ook via Linux doen, door een RAID5 array aan te maken van je huidige schijven, conform dezelfde settings als nu het geval is: stripesize, raid level, disk order en disk count. Dit proces is gevaarlijk! Als je echt je data terug wilt, raad ik je aan om 4 nieuwe schijven te kopen (4x1TB) of 2 grotere schijven (2x 2TB) zodat je alles wat nu 'ruw' op de 4 disks staat, kunt backuppen. Als je dit wilt, dan kan ik je bijna garanderen dat je je data terug krijgt. Bijna, want er kan ook nog filesystem schade zijn. Maar hey dat is een volgende stap. Eerst je RAID-volume werkend krijgen binnen Linux dan kun je alle data ervanaf kopiëren naar iets anders.

Wel beetje kut dat het zaterdag avond is, winkels zijn nu dicht voor wat extra backup-schijven.

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Verwijderd

Oh en bij de screenshots in deze reactie: IStealYourGun in "[Raid] Raid-5 array stuk en verdwenen." , heb je daar je controller in RAID modus staan of AHCI? Je kunt beide proberen overigens. Als je geluk hebt staat je RAID-volume er namelijk automatisch bij, maar dat hangt af of de metadata nog intact is.

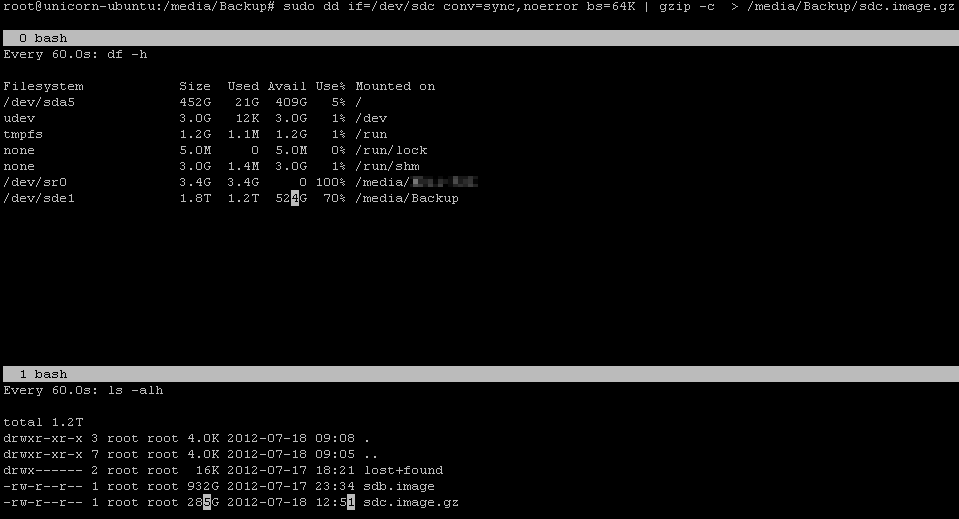

Ik vermoed dat ik het best een backup maak door middel van dd

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Gaat dit eigenlijk werken? Uiteindelijk heb ik die via de BIOS van mijn sata-controller gemaakt en wat je me nu voorstelt is een software-RAID binnen linux (die volgens mij dan enkel te benaderen is via Linux).Verwijderd schreef op zaterdag 14 juli 2012 @ 18:45:

[...]

Dat recoveren kun je ook via Linux doen, door een RAID5 array aan te maken van je huidige schijven, conform dezelfde settings als nu het geval is: stripesize, raid level, disk order en disk count. Dit proces is gevaarlijk! Als je echt je data terug wilt, raad ik je aan om 4 nieuwe schijven te kopen (4x1TB) of 2 grotere schijven (2x 2TB) zodat je alles wat nu 'ruw' op de 4 disks staat, kunt backuppen. Als je dit wilt, dan kan ik je bijna garanderen dat je je data terug krijgt. Bijna, want er kan ook nog filesystem schade zijn. Maar hey dat is een volgende stap. Eerst je RAID-volume werkend krijgen binnen Linux dan kun je alle data ervanaf kopiëren naar iets anders.

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Verwijderd

Omdat iedere fabrikant/merk de configuratiegegevens in zijn eigen formaat opslaat, gaat het niet werken als je jouw disks gemaakt met onboard RAID op een hardware RAID controller zet. Die controller kan niet het formaat RAID-configuratie lezen omdat die controller weer een ander formaat gebruikt.

Linux is dus een uitzondering, net als pseudoRAID in FreeBSD, waarbij Linux wél de metadata-formaten kent van een groot aantal RAID systemen. Dit betekent dat je je onboard RAID gewoon in Linux kunt gebruiken. Maar in jouw geval assembled de RAID niet automatisch dus moet je zelf gaan ingrijpen. Op het moment dat je handmatig de juiste configuratie maakt, zul je de inhoud van je RAID volume kunnen zien. De 'juiste configuratie' hierbij wordt bedoeld de configuratie die jij hebt gebruikt om de RAID aan te maken. Denk hierbij aan de volgorde van schijven (heel belangrijk) en de stripesize, disk count en disk offset is minder belangrijk.

Zodra je genoeg backup-ruimte hebt, kun je echt proberen. Zolang de filesystem niet beschadigd is, kun je dan gewoon alles terugkrijgen.

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Verwijderd

backup.rar

backup.r01

backup.r02

ofzoiets. Die zet je dan op aparte disks, want dat is wat je wilt?

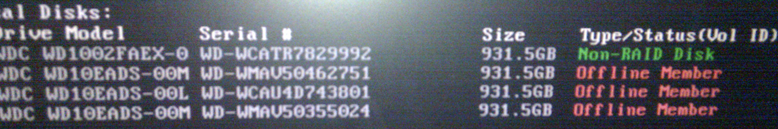

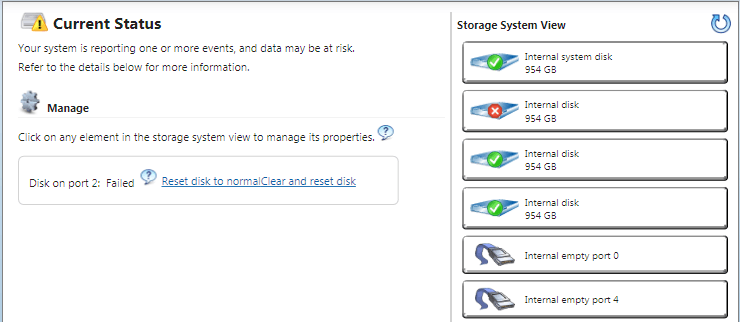

Het ziet er naar uit dat disk 2 corrupt is:

Device Boot Start End Blocks Id System /dev/sdb1 2048 3907035135 1953516544 7 HPFS/NTFS/exFAT Disk /dev/sdc: 1000.2 GB, 1000204886016 bytes 255 heads, 63 sectors/track, 121601 cylinders, total 1953525168 sectors Units = sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk identifier: 0x00000000 Disk /dev/sdc doesn't contain a valid partition table

Ik ga er dus vanuit dat deze zeker moet worden rebuild dus mag die worden gezipt worden, helaas duurt hierdoor een back-up nemen duidelijk langer.

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Verwijderd

Dus dat je 'dd' gebruikt ligt natuurlijk voor de hand. De compressie werkt goed waarschijnlijk omdat een groot gedeelte van de schijf nog niet is geschreven, dus uit nullen bestaat. Maar zo krijg je wel alle drie de schijven gebackupped lijkt me.

Zodra je de backup klaar hebt, kun je met Linux RAID gaan spelen. Je kunt daarbij ook slechts twee schijven gebruiken en dus een 'degraded' RAID aan te maken. Tijdens deze fase moet je 'backup' zijn afgekoppeld voor de zekerheid en dan nog steeds doe je zoveel mogelijk acties in read-only mode. Bijvoorbeeld als een RAID5 aanmaakt kun je het rebuilden opschorten. Het is een tijdje geleden dat ik recovery via Linux deed. Misschien moet ik zelf eens prutsen als een soort test, dan kan ik je ook beter helpen.

Alternatief is BSD, maar je draait nu toch Linux en daar moet het ook mee kunnen. Zodra je Linux RAID volume draait en de data lijkt intact, kun je beginnen met kopiëren naar je backup schijf, die backup bestanden heb je dan niet meer nodig, aangenomen dat je goed checkt dat je RAID volume geen corruptie vertoont.

Maar in tussentijd heb ik wel eens wat verder gekeken om te rebuilden. Vreemd genoeg kan hij geen superbloks vinden als ik mdadm --examine /dev/sd[bcd]1 uitvoer, maar dat zou nog geen ramp mogen zijn.

Met mdadm --examine /dev/sd[bcd] kreeg ik het volgende

/dev/sdb:

Magic : Intel Raid ISM Cfg Sig.

Version : 1.0.00

Orig Family : 539db933

Family : 539db933

Generation : 00000000

UUID : eb944b1e:d3162425:25b6f58a:0dc61dcd

Checksum : fad92abd correct

MPB Sectors : 1

Disks : 1

RAID Devices : 0

Disk00 Serial : WD-WMAV50462751

State :

Id : 00020000

Usable Size : 1953520654 (931.51 GiB 1000.20 GB)

/dev/sdc:

Magic : Intel Raid ISM Cfg Sig.

Version : 1.2.02

Orig Family : d95cbe56

Family : d95cc543

Generation : 000b26e5

UUID : 0896e699:7e90bcb8:8f60345e:d8e77bbd

Checksum : 8e14a3cb correct

MPB Sectors : 2

Disks : 3

RAID Devices : 1

Disk01 Serial : WD-WCAU4D743801

State : active

Id : 00030000

Usable Size : 1953520654 (931.51 GiB 1000.20 GB)

[Home]:

UUID : a9884335:b3e50afc:29e6a0b6:e3159517

RAID Level : 5

Members : 3

Slots : [_UU]

This Slot : 1

Array Size : 3907039232 (1863.02 GiB 2000.40 GB)

Per Dev Size : 1953519880 (931.51 GiB 1000.20 GB)

Sector Offset : 0

Num Stripes : 15261872

Chunk Size : 64 KiB

Reserved : 0

Migrate State : idle

Map State : degraded

Dirty State : clean

Disk00 Serial : WD-WMAV50462751

State : active failed

Id : 00020000

Usable Size : 1953520654 (931.51 GiB 1000.20 GB)

Disk02 Serial : WD-WMAV50355024

State : active

Id : 00050000

Usable Size : 1953520654 (931.51 GiB 1000.20 GB)

/dev/sdd:

Magic : Intel Raid ISM Cfg Sig.

Version : 1.2.02

Orig Family : d95cbe56

Family : d95cc543

Generation : 000b26e5

UUID : 0896e699:7e90bcb8:8f60345e:d8e77bbd

Checksum : 8e14a3cb correct

MPB Sectors : 2

Disks : 3

RAID Devices : 1

Disk02 Serial : WD-WMAV50355024

State : active

Id : 00050000

Usable Size : 1953520654 (931.51 GiB 1000.20 GB)

[Home]:

UUID : a9884335:b3e50afc:29e6a0b6:e3159517

RAID Level : 5

Members : 3

Slots : [_UU]

This Slot : 2

Array Size : 3907039232 (1863.02 GiB 2000.40 GB)

Per Dev Size : 1953519880 (931.51 GiB 1000.20 GB)

Sector Offset : 0

Num Stripes : 15261872

Chunk Size : 64 KiB

Reserved : 0

Migrate State : idle

Map State : degraded

Dirty State : clean

Disk00 Serial : WD-WMAV50462751

State : active failed

Id : 00020000

Usable Size : 1953520654 (931.51 GiB 1000.20 GB)

Disk01 Serial : WD-WCAU4D743801

State : active

Id : 00030000

Usable Size : 1953520654 (931.51 GiB 1000.20 GB)

Waarmee ik met

mdadm --create --assume-clean --level=5 --raid-devices=3 /dev/md0 missing /dev/sdc1 /dev/sdd1

mijn raid weer "veilig" kan herstellen (zonder device 1 die in active failed status staat) en waar dev/md0 mijn "nieuwe" raid zal worden. Klopt dit?

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Weet je zeker dat je moet createn en niet assemblen? Maakt hij er dan geen mdadm-softwareraid van?IStealYourGun schreef op donderdag 19 juli 2012 @ 09:32:

Waarmee ik met

mdadm --create --assume-clean --level=5 --raid-devices=3 /dev/md0 missing /dev/sdc1 /dev/sdd1

mijn raid weer "veilig" kan herstellen (zonder device 1 die in active failed status staat) en waar dev/md0 mijn "nieuwe" raid zal worden. Klopt dit?

[ Voor 8% gewijzigd door gertvdijk op 19-07-2012 10:03 ]

Kia e-Niro 2021 64kWh DynamicPlusLine. 3x Victron MP-II op 15kWh US5000 3f thuisbatterij met 3x25A→3x40A PowerAssist, Victron EVCS, 3200Wp HoyMiles zp. my GitHub, my blog

Met asamble gaat bij mij falen omdat ik geen suporblocks (meer) heb of een config file. Dus moet ik hem helemaal manueel hermaken:gertvdijk schreef op donderdag 19 juli 2012 @ 10:03:

[...]

Weet je zeker dat je moet createn en niet assemblen? Maakt hij er dan geen mdadm-softwareraid van?

http://kevin.deldycke.com...ng-zero-ized-superblocks/

http://blog.al4.co.nz/201...-with-two-failed-devices/

Enige wat ik niet mag vergeten is de chunck size, die is bij mdadm blijkbaar 512k en ik heb 64k genomen (vraag me niet waarom ik dat ooit gedaan heb).

Dus:

mdadm --create --assume-clean --chunk=64 --level=5 --raid-devices=3 /dev/md0 missing /dev/sdc1 /dev/sdd1

Laatste HDD is bijna gebackupt, dus vanacht gaan we (pogen tot) rebuilden.

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

Bij het starten met disk 2 ontkoppeld werkte de raid plots weer, daarna PC herstart met disk 2 er weer in en dan is hij begonnen met rebuilden.

♥ Under Construction ♦ © 1985 - 2013 and counting. ♣ Born to be Root ★ In the end, we are all communists ♠ Please, don't feed me meat

/u/1176/crop635f8931b2b68_cropped.png?f=community)