Ergens vorige week is een website die ik een tijd geleden gebouwd heb (www.eurocollege.nl) gehackt. Hoe het precies gebeurd is is mij niet helemaal duidelijk, maar waarschijnlijk heeft iemand op de een of andere manier FTP-toegang tot de server gekregen.

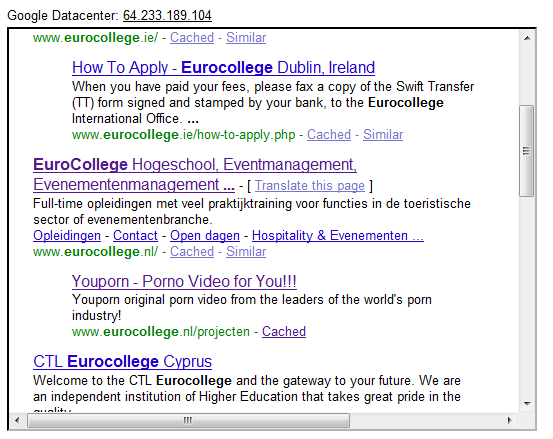

Degene die dit gedaan heeft heeft een robots.txt op de server geplaatst met een volledige HTML-pagina als inhoud. Ik wist niet dat dit überhaupt iets uit zou halen, maar Google is vervolgens die content gaan indexeren in plaats van de echte content. Ook de "in cache" pagina van Google toonde de inhoud van die robots.txt (wat overigens een <h1> was met wat YouPorn teksten en verder een verzameling willekeurige Engelse woorden). Fetch as Googlebot uit de Webmaster Tools liet dan ook deze content zien en niet de echte site.

Uiteindelijk heb ik de robots.txt verwijderd, het FTP wachtwoord aangepast en met de Google Webmaster Tools de cache weg laten gooien. Fetch as Googlebot geeft nu netjes weer de juiste content weer. Maar: de zoekresultaten tonen nog steeds de titel "Youporn - Porno Video for You!!!". Dat het even wat tijd kost is natuurlijk logisch, maar ik kan me niet voorstellen dat Google er een week over doet voor de pagina opnieuw geïndexeerd is. Daarom hier de vraag: wat kan ik verder nog doen?

Op het Google Support forum loopt ook een draadje (opgezet door een medewerker van de school) over dit onderwerp. Hier reageert een aantal mensen op, maar ik kan eigenlijk niet zoveel met de antwoorden. Maar goed, waarschijnlijk zijn dit dan ook geen Tweakers

Ik hoop dat iemand mij kan helpen

Degene die dit gedaan heeft heeft een robots.txt op de server geplaatst met een volledige HTML-pagina als inhoud. Ik wist niet dat dit überhaupt iets uit zou halen, maar Google is vervolgens die content gaan indexeren in plaats van de echte content. Ook de "in cache" pagina van Google toonde de inhoud van die robots.txt (wat overigens een <h1> was met wat YouPorn teksten en verder een verzameling willekeurige Engelse woorden). Fetch as Googlebot uit de Webmaster Tools liet dan ook deze content zien en niet de echte site.

Uiteindelijk heb ik de robots.txt verwijderd, het FTP wachtwoord aangepast en met de Google Webmaster Tools de cache weg laten gooien. Fetch as Googlebot geeft nu netjes weer de juiste content weer. Maar: de zoekresultaten tonen nog steeds de titel "Youporn - Porno Video for You!!!". Dat het even wat tijd kost is natuurlijk logisch, maar ik kan me niet voorstellen dat Google er een week over doet voor de pagina opnieuw geïndexeerd is. Daarom hier de vraag: wat kan ik verder nog doen?

Op het Google Support forum loopt ook een draadje (opgezet door een medewerker van de school) over dit onderwerp. Hier reageert een aantal mensen op, maar ik kan eigenlijk niet zoveel met de antwoorden. Maar goed, waarschijnlijk zijn dit dan ook geen Tweakers

Ik hoop dat iemand mij kan helpen

[ Voor 4% gewijzigd door posttoast op 02-05-2010 11:41 ]

:strip_exif()/u/5779/posttoast.gif?f=community)

:strip_exif()/u/266570/crop66602ce74603f_cropped.webp?f=community)

:strip_exif()/u/47168/loop.gif?f=community)

:strip_exif()/u/11775/SoulTaker.gif?f=community)

/u/61403/crop58bff192a74cb_cropped.png?f=community)

:strip_exif()/u/86829/madmarty_droid.gif?f=community)